Spotlight: AI chat, spil som Retro, stedskifter, Roblox fjernet blokeringen

Spotlight: AI chat, spil som Retro, stedskifter, Roblox fjernet blokeringen

Siden den banebrydende udgivelse af Llama 1 er de lukkede, proprietære API'er blevet uigenkaldeligt demokratiseret. Metas open source Llama (Large Language Model Meta AI) serie har omformet AI-landskabet. Den yderst kapable Llama 3 og dens senest udgivne Llama 4 gør denne modelfamilie til fundamentet for open source AI-innovation.

Hvis du er forvirret af utallige AI-modeller, så læs denne omfattende Llama-anmeldelseDu kan lære, hvad Llama er, hvad der gør Llama AI unik, dens overbevisende business case, den konkurrencemæssige position i forhold til giganter som ChatGPT, en praktisk guide til virksomheder og meget mere.

Indholdsfortegnelse

Lama refererer til en samling af grundlæggende store sprogmodeller udviklet af Meta. I modsætning til tidligere modeller, der kun kan tilgås via API, er Llama-serien offentligt udgivet til forskning og kommerciel brug. Faktisk er en brugerdefineret licens designet til at forhindre misbrug, og den gælder under specifikke skaleringsbetingelser. Den seneste version er Llama 4.

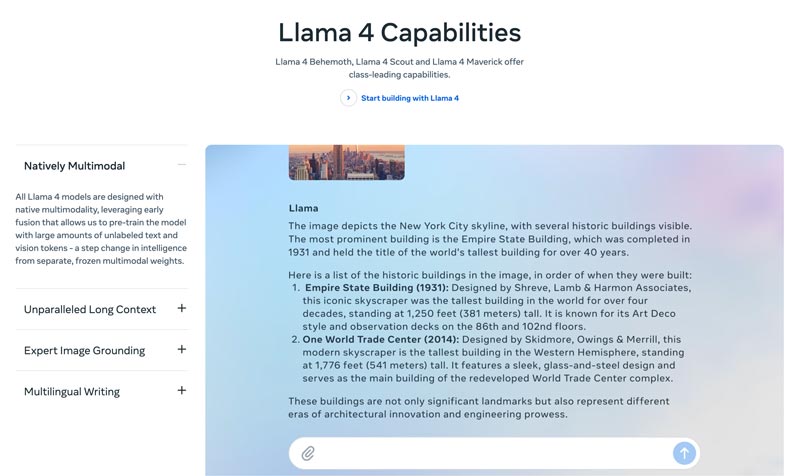

Lama 4 er den seneste version. Meta hævder, at det er den mest intelligente, skalerbare og praktiske version. Med mere avancerede ræsonnements- og planlægningsevner, multimodale muligheder og flersprogede skrivefunktioner kan Llama 4 være det brancheførende kontekstvindue. Det giver dig mulighed for nemt at implementere dine mest utrolige ideer med Llama API og Llama Stack. Den nuværende Llama 4 giver mulighed for mere personlige oplevelser.

Lama 3 blev udgivet i april 2024. Sammenlignet med Llama 2 har Llama 3 adskillige forbedringer, herunder forbedret ræsonnement og kodning, forbedrede træningsdata, et større kontekstvindue og en mere effektiv tokenizer.

Lama 1 & 2: Den originale Llama blev udgivet i starten af 2023, og Llama 2 blev udgivet i juli 2023. De markerede Metas direkte indtræden i chatbot-arenaen. Med en finjusteret variant, siden Llama 2, leverer serien en nyttig og sikker dialog. Llama 1/2 er primært udviklet til at udfordre OpenAI's ChatGPT og Googles Bard direkte.

Udviklet af Meta til at omforme AI-landskabet, høj ydeevne Det vil ikke være din bekymring. Llama er finjusteret på din virksomheds specifikke data for at overgå større generiske modeller til specifikke opgaver. Potentialet for finjustering gør det velegnet til de fleste udviklere og forskere.

Llamas unikke karakter ligger ikke kun i dens præstation. økosystemet Llama har skabt kan være en større fordel. Dens Hugging Face-økosystem har udløst en eksplosion af innovation. Tusindvis af finjusterede derivater tilbydes til forskellige tænkelige opgaver.

Derudover har Llama givet en LLM i topklasse i alles hænder. demokratisering af AI er endnu en fordel, der gør Llama unik. Llama AI-modeller er tilgængelige for alle forskere, udviklere og startups til brug, innovation og udvikling uden at betale API-gebyrer eller bede om tilladelse.

Strategisk fordel for virksomheder. Med Llama kan du eje din AI-bygning. Du behøver ikke længere at være bundet til en leverandørs priser, politikændringer eller API-forældelser. Det undgår effektivt leverandørbinding.

Business casen for Llama handler ikke blot om at bruge en anden AI-model. Faktisk kan det være en fundamental ændring i, hvordan en virksomhed håndterer AI.

I de tidlige dage anvendte mange virksomheder API-baserede tjenester, såsom OpenAI's GPT-4. Det kan være den mest bekvemme løsning, da det muliggør eksperimentering med lave barrierer og hurtig prototyping. Denne AI-strategi er dog blevet erstattet af en mere strategisk, langsigtet tilgang, open source-fundamentsmodeller som Metas Llama. Llama-sagen hviler på tre nøglefaktorer: omkostningsbesparelser, kontrol og tilpasning samt datasikkerhed.

API-omkostningerne for mange virksomheder (der behandler millioner af forespørgsler om dagen) kan løbe op i millioner årligt. Implementeringen af Llama er et skift fra driftsudgifter (OpEx) til kapitaludgifter (CapEx). Det gør ROI tydeligt ved høj volumen.

Med Llama kan du skabe en unik, finjusteret AI, der passer bedst til din virksomhed eller dine produkter. Du har også fuld kontrol over din models input og output. Den bliver et kerneaktiv, ikke en lejet tjeneste.

Regering og finans har strenge krav til datastyring. Llama kan implementeres fuldt ud on-premise eller i en kompatibel VPC (Virtual Private Cloud). Det er ofte den eneste lovlige måde at udnytte LLM-teknologi på. Desuden betyder implementering af Llama i en sikker VPC, at alle dine data er sikret og aldrig forlader din firewall. Det eliminerer effektivt risikoen for dataeksponering fra tredjeparter.

Kort sagt handler forretningsmodellen for Llama om ejendomsretDu får ejerskabet over din konkurrencefordel, sikkerheden af dine data og dine omkostninger tilbage.

Metas Llama giver virksomheder en ny måde at bruge AI på. Denne kraftfulde AI-model har en bred vifte af anvendelser, herunder konversationel AI, billed- og tekstgenerering, sprogtræning, opsummering og andre relaterede opgaver. Ved at bruge avancerede AI-funktioner kan Llama hjælpe virksomheder med at opnå succes.

• Kundeservice og support

Avancerede chatbots eller virtuelle assistenter drevet af Llama kan bedre forstå kundernes spørgsmål, især komplekse forespørgsler, og give korrekte, kontekstbevidste svar. Det er fordelagtigt at tilbyde kundesupport døgnet rundt.

• Dataanalyse og Business Intelligence

Llama kan trække data fra forskellige kilder og træffe beslutninger, der i starten krævede tekniske færdigheder. Det giver forretningsledere og analytikere mulighed for at få en SQL-forespørgsel ved at stille spørgsmål. Modellen kan analysere tekst, billeder, diagrammer og andet indhold for at give et narrativt resumé. Det hjælper med hurtigt at identificere nye tendenser, konkurrenceindsigt og almindelige klager.

• Marketing- og indholdsautomatisering

Processen med at producere indhold af høj kvalitet og SEO-optimeret er tidskrævende. Llama kan hurtigt generere udkast eller hele artikler med et simpelt emne og flere søgeord. Menneskelige redaktører kan derefter forfine disse resultater. Modellen kan også automatisere oprettelsen af opslag på sociale medier. Derudover kan den hjælpe med at skrive overbevisende emnelinjer til e-mails og annoncer.

• Softwareudvikling

En kodespecifik Llama-model kan fungere som en avanceret autofuldførelsesmetode til at opretholde kodekvalitet, administrere ældre systemer og accelerere udviklingscyklusser. Den kan hjælpe med at gennemgå kode for potentielle fejl. Derudover kan den automatisk generere og opdatere kodedokumentation og API-referencer baseret på kildekodekommentarer.

Dette afsnit giver en side-om-side sammenligning af Metas Llama-serie med andre førende alternativer i tabelformat. Du kan sammenligne disse nøglefaktorer for at finde den bedste løsning til dine specifikke behov.

Det burde være klart, at disse AI-modeller har deres egne styrker og svagheder. Valget handler ikke om at finde én enkelt mulighed.

| AI modeller | Metas LLaMA 4/3/2 | OpenAIs GPT-4 | Antropisk Claude 3 | Googles PaLM 2 |

| Licens | Open source, brugerdefineret licens | Proprietær | Proprietær | Proprietær |

| Adgang | Download og selvhost | Kun API Adgang via abonnement | Kun API Adgang via brugsbaseret prisfastsættelse | Kun API Adgang via Googles Vertex AI |

| AI modeller | Metas LLaMA 4/3/2 | OpenAIs GPT-4 | Antropisk Claude 3 | Googles PaLM 2 |

| Ydeevne | Topniveau Konkurrencedygtig med de bedste AI-modeller Kræver finjustering for at matche GPT-4-ydeevne på specifikke opgaver Mangler at levere engagerende kreativt indhold af høj kvalitet | Brancheleder Håndter kompleks ræsonnement, nuancer og kreativ problemløsning | Topniveau Fremragende til dataanalyse, sofistikeret dialog og lang kontekstbaseret ræsonnement | Topniveau Fremragende til ræsonnement og flersprogede opgaver |

| Omkostningsstruktur | Høje anlægsomkostninger, lave driftsomkostninger Omkostningsskalaer med modelstørrelse og brugsvolumen | Ingen anlægsinvesteringer, høj driftsudgift startpris, men betaling pr. token for brug | Ingen anlægsinvesteringer, høj driftsinvestering Ligesom OpenAI, betal-per-token | Ingen anlægsinvesteringer, høj driftsinvestering Betal pr. token på Vertex AI med mængderabatter |

| Databeskyttelse og -sikkerhed | Maksimal kontrol Data forlader aldrig din infrastruktur. Ideel til stærkt regulerede brancher. | Input/output-data behandles på OpenAIs servere | Stærk privatlivspolitik, men data behandles af Anthropic | Sikkerhed i virksomhedsklasse Data behandlet på Google Cloud Tilbyder VPC-kontroller og forpligtelser til dataopbevaring |

| Tilpasning og kontrol | Fuld kontrol Kan finjusteres fuldt ud på proprietære data | Begrænset Finjustering er kun tilgængelig for ældre modeller (ikke GPT-4) | Begrænset Tilpasset via prompt engineering og kontekst | Stærk God støtte til finjustering og forstærkningslæring |

| Skalerbarhed | Du skal selv klargøre og administrere din infrastruktur | OpenAI administrerer al infrastruktur | Anthropic administrerer al infrastruktur | Google Cloud administrerer infrastrukturen |

Generelt er Llama ideel til virksomheder, der foretrækker fuld kontrol, databeskyttelse og tilpasningsmuligheder. GPT-4 er bedst egnet til virksomheder, der kræver den højeste rå ydeevne og ræsonnementsevner. Den kan bedre håndtere komplekse opgaver, især kreativ og avanceret analyse. Claude 3 er ideel til applikationer, hvor sikkerhed og reduceret bias er altafgørende. Den producerer sjældent skadelige resultater. PaLM 2 er bedst til virksomheder, der er dybt integreret i Google Cloud-økosystemet. Den sikrer en problemfri integration med andre Google-værktøjer.

Før du implementerer Llama, bør du først finde ud af dine behov i henhold til den specifikke use case. Har du brug for 70B-parametermodellen for maksimal kvalitet eller kun 8B-modellen til basale opgaver?

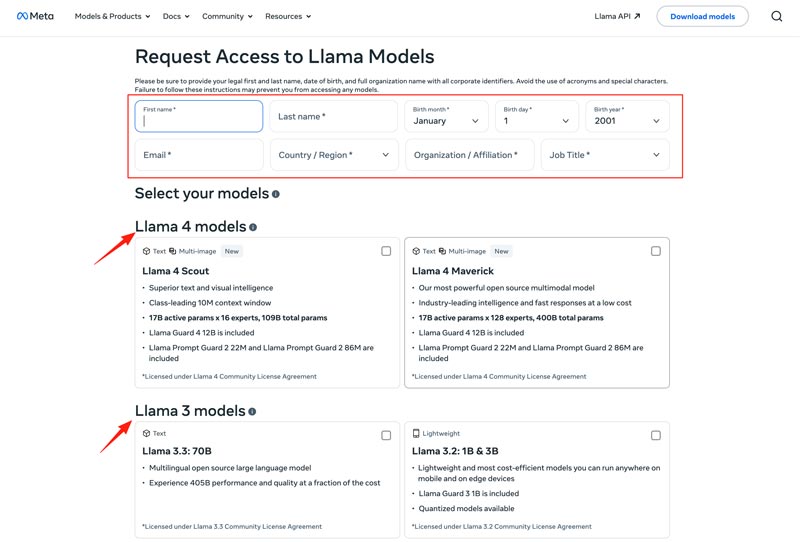

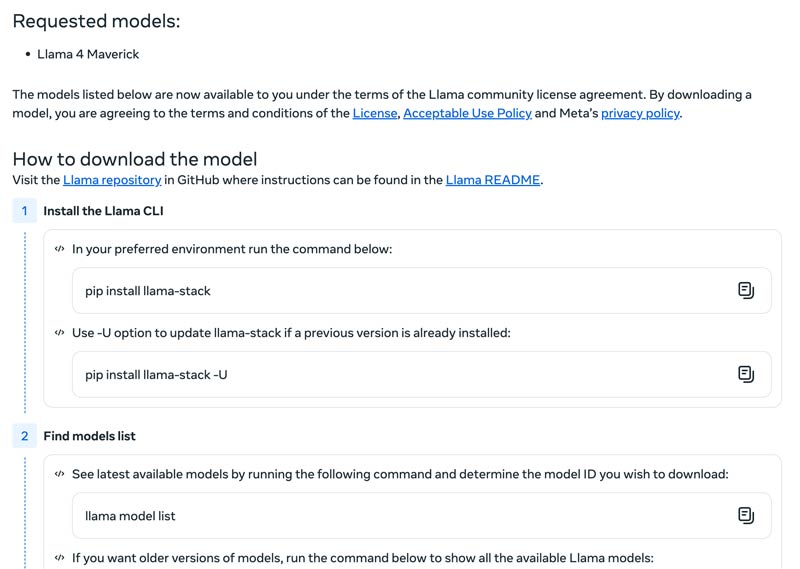

Du bør vælge din implementeringsmetode, f.eks. en lokal maskine, en cloud-VM eller en administreret tjeneste. Effektiv kørsel af Llama-modeller kræver ofte en kraftig GPU, især for de større modeller. Derefter kan du downloade den korrekte model fra Meta-webstedet.

Klik på Download modeller knappen for at indtaste Anmod om adgang side. Angiv de nødvendige oplysninger, og vælg en ønsket lamamodel.

Klik på Næste knap for at læse Vilkår og betingelserDu bør læse fællesskabslicensaftalen omhyggeligt og derefter klikke på Accepter og fortsæt knappen. Følg instruktionerne på skærmen for at downloade din valgte model.

Du kan bruge et framework som Text Generation Inference til at få en højtydende API-server. Hvis du har brug for en chatgrænseflade, skal du implementere en brugergrænseflade som f.eks. Chatbot Brugergrænseflade eller NextChat. Brug derefter dine proprietære data med frameworks til at oprette din egen specialiserede model.

Du bør vide, hvordan du overvinder udfordringer for at bruge AI-modeller effektivt.

• Kompleksitet ved indledende opsætning

Du kan bruge dens præbyggede værktøjer og containere. Kør modeller lokalt med en enkelt kommando. Du kan også bruge cloudbaserede platforme uden lokal opsætning. Hugging Face giver dig mulighed for at køre og oprette demoer ved hjælp af prækonfigurerede miljøer. Derudover kan du starte med llama.cpp for at køre en kvantiseret version af Llama.

• Ressourcestyring og omkostningsoptimering

Store modeller kræver GPU'er med høj hukommelse, som ofte er knappe og dyre.

Kvantisering er den mest effektive teknik. Du kan bruge biblioteker til 4-bit kvantisering under inferens eller finjustering. På mindre kraftfuld hardware skal du bruge llama.cpp til at køre modeller. Begge metoder kan effektivt reducere hukommelsesforbruget. Sørg desuden for at vælge den korrekte model til dine opgaver. En mindre, finjusteret model kan være mere omkostningseffektiv.

• Hold dig opdateret med nye udgivelser

Mange nye modeller, teknikker og biblioteker udgives ugentligt. Det kan være svært at holde sig opdateret.

Du bør abonnere på de officielle blogs som Meta AI, Hugging Face og vLLM. Derudover deles nye finjusteringsteknikker, applikationer, effektivitetsgevinster, erfaringer, løsninger og mere på platforme som GitHub og Hugging Face. Det giver dit team mulighed for at integrere forbedringer.

Du har muligvis også brug for:

Spørgsmål 1. Er det tilladt at bruge outputtet fra Llama-modellerne til at træne andre LLM'er?

Ja, Meta har tilladelse til at bruge nyere versioner (Llama 3.1 og senere) af Llamas output til at træne andre modeller. Du har helt sikkert ikke tilladelse til at bruge det til at skabe et produkt, der konkurrerer med Meta. Desuden skal du være meget opmærksom på de juridiske grænser, der er fastsat af Metas licens.

Spørgsmål 2. Har lamamodeller begrænsninger? Hvad er de relaterede termer?

Ja, Llama-modeller har betydelige begrænsninger, defineret af deres licensstruktur. Disse modeller er ikke ægte open source. I stedet udgives de under en proprietær licens fra Meta. Det er for at beskytte Metas interesser og forhindre konkurrenceprægede brugsscenarier.

Spørgsmål 3. Hvad er de almindelige anvendelsesscenarier for Llama?

Daglige anvendelser af Llama omfatter forståelse af billeder og dokumenter, besvarelse af spørgsmål, generering af billeder og tekst, sproggenerering og -opsummering, sprogtræning, samtale-AI og meget mere. Llama kan besvare dit spørgsmål baseret på det billed- eller dokumentindhold, du har angivet. Derudover kan det bruges til at oprette en chatbot eller en visuel assistent.

Spørgsmål 4. Hvad er hardwarekravene for at bruge Llama-modeller?

Hardwarekravene til at køre Llama-modeller bestemmes af tre nøglefaktorer: modelstørrelse, kvantisering og use case. For de fleste udviklere er en RTX 4070/4080/4090 eller en Mac med 16-36 GB Unified Memory et fleksibelt valg til Llama-modeller op til 70 MB. Til GPU-baseret drift er den mest afgørende faktor dit grafikkorts VRAM. Som nævnt skal du vælge den korrekte modelstørrelse baseret på dine behov, og derefter vælge det kvantiseringsniveau, der kan køre på din hardware.

Spørgsmål 5. Er Llama lige så god som ChatGPT?

Du kan tjekke tabellen ovenfor for at sammenligne deres nøglefaktorer mellem Llama og ChatGPTLlama kan køres lokalt og offline. Det tilbyder mere sikker databeskyttelse. Desuden er selve Llama-modellen gratis at bruge. ChatGPT har en gratis version, men dens avancerede modeller og funktioner kræver et betalt abonnement.

Konklusion

Lama er ikke bare endnu en model. Det ses ofte som et strategisk skift mod en mere tilgængelig og brugerdefineret AI-fremtid. Du kan lære forskellige relaterede oplysninger om Llama AI-familien i denne praktiske anmeldelse og derefter finde ud af, om den er hypen værd.

Fandt du dette nyttigt?

484 Stemmer