Scheinwerfer: KI-Chat, Spiele wie Retro, Standortwechsler, Roblox entsperrt

Scheinwerfer: KI-Chat, Spiele wie Retro, Standortwechsler, Roblox entsperrt

Seit der bahnbrechenden Veröffentlichung von Llama 1 wurden die geschlossenen, proprietären APIs unwiderruflich demokratisiert. Metas Open-Source-Reihe Llama (Large Language Model Meta AI) hat die KI-Landschaft neu gestaltet. Das leistungsstarke Llama 3 und die neueste Version Llama 4 machen diese Modellfamilie zur Grundlage für Open-Source-KI-Innovationen.

Wenn Sie durch die unzähligen KI-Modelle verwirrt sind, lesen Sie diese umfassende Lama-Rezension. Sie können erfahren, was Llama ist, was Llama AI einzigartig macht, sein überzeugendes Geschäftsmodell, die Wettbewerbsposition gegenüber Giganten wie ChatGPT, einen praktischen Leitfaden für Unternehmen und vieles mehr.

Inhaltsverzeichnis

Lama bezeichnet eine Sammlung grundlegender, großer Sprachmodelle, die von Meta entwickelt wurden. Im Gegensatz zu früheren Modellen, die nur über eine API zugänglich waren, ist die Llama-Reihe öffentlich für Forschung und kommerzielle Nutzung freigegeben. Eine spezielle Lizenz soll Missbrauch verhindern und gilt unter bestimmten Skalierungsbedingungen. Die neueste Version ist Llama 4.

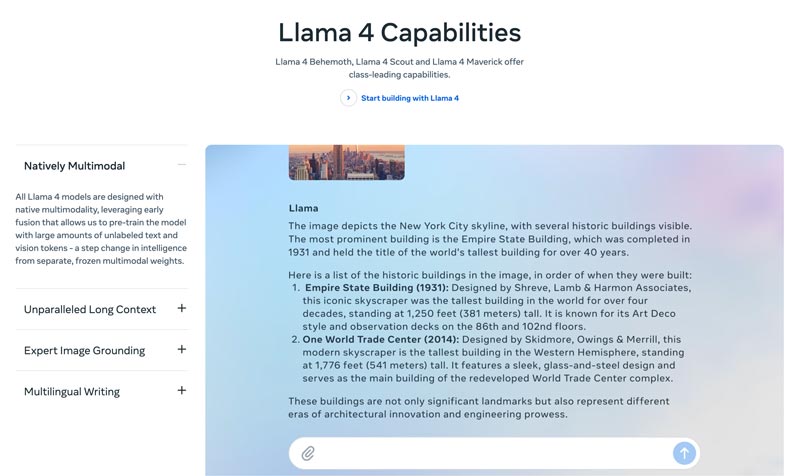

Lama 4 ist die neueste Version. Meta behauptet, es sei die intelligenteste, skalierbarste und komfortabelste Version. Mit erweiterten Denk- und Planungsfähigkeiten, multimodalen Funktionen und mehrsprachigen Schreibfunktionen kann Llama 4 das branchenführende Kontextfenster sein. Mit der Llama-API und dem Llama-Stack können Sie Ihre unglaublichsten Ideen ganz einfach umsetzen. Das aktuelle Llama 4 ermöglicht personalisiertere Erlebnisse.

Lama 3 wurde im April 2024 veröffentlicht. Im Vergleich zu Llama 2 weist Llama 3 mehrere Verbesserungen auf, darunter verbessertes Denken und Codieren, verbesserte Trainingsdaten, ein größeres Kontextfenster und einen effizienteren Tokenizer.

Lama 1 & 2: Das Original-Llama erschien Anfang 2023, Llama 2 im Juli 2023. Sie markierten Metas direkten Einstieg in die Chatbot-Welt. Mit einer optimierten Variante bietet die Serie seit Llama 2 einen hilfreichen und sicheren Dialog. Llama 1/2 wurde hauptsächlich entwickelt, um OpenAIs ChatGPT und Googles Bard direkt herauszufordern.

Entwickelt von Meta zur Neugestaltung der KI-Landschaft, hohe Leistung Sie müssen sich keine Sorgen machen. Llama ist auf die spezifischen Daten Ihres Unternehmens abgestimmt und übertrifft größere generische Modelle bei bestimmten Aufgaben. Dank des Potenzials zur Feinabstimmung eignet es sich für die meisten Entwickler und Forscher.

Llamas Einzigartigkeit liegt nicht nur in seiner Leistung. Die Ökosystem Lama hat hervorgebracht kann ein größerer Vorteil sein. Sein Hugging Face-Ökosystem hat eine Explosion der Innovation ausgelöst. Tausende fein abgestimmte Derivate werden für unterschiedliche denkbare Aufgaben angeboten.

Darüber hinaus hat Llama jedem ein erstklassiges LLM in die Hände gelegt. Die Demokratisierung der KI ist ein weiterer Vorteil, der Llama einzigartig macht. Llama-KI-Modelle stehen allen Forschern, Entwicklern und Startups zur Nutzung, Innovation und Entwicklung zur Verfügung, ohne dass API-Gebühren gezahlt oder um Erlaubnis gefragt werden muss.

Strategischer Vorteil für Unternehmen. Mit Llama gehört Ihr KI-Build Ihnen. Sie müssen sich nicht mehr an die Preise, Richtlinienänderungen oder API-Abkündigungen eines Anbieters binden. Das verhindert effektiv die Abhängigkeit von einem Anbieter.

Der Business Case für Llama besteht nicht nur darin, ein anderes KI-Modell zu verwenden. Vielmehr kann es zu einer grundlegenden Veränderung im Umgang eines Unternehmens mit KI kommen.

Anfangs setzten viele Unternehmen auf API-basierte Dienste wie GPT-4 von OpenAI. Dies kann die bequemste Option sein, da es einfaches Experimentieren und schnelles Prototyping ermöglicht. Diese KI-Strategie wurde jedoch durch einen strategischeren, langfristigeren Ansatz ersetzt: Open-Source-basierte Modelle wie Llama von Meta. Der Fall Llama beruht auf drei Schlüsselfaktoren: Kosteneinsparungen, Kontrolle und Anpassung sowie Datensicherheit.

Die API-Kosten für viele Unternehmen (die täglich Millionen von Abfragen verarbeiten) können jährlich in die Millionen gehen. Die Bereitstellung von Llama bedeutet eine Verlagerung von Betriebsausgaben (OpEx) zu Investitionsausgaben (CapEx). Das macht den ROI bei hohem Volumen deutlich.

Mit Llama erstellen Sie eine individuell abgestimmte KI, die optimal zu Ihrem Unternehmen oder Ihren Produkten passt. Sie haben die volle Kontrolle über die Ein- und Ausgaben Ihres Modells. Llama wird zu einem zentralen Asset, nicht zu einer gemieteten Dienstleistung.

Behörden und Finanzwesen haben strenge Anforderungen an die Datenverwaltung. Llama kann vollständig vor Ort oder in einer konformen VPC (Virtual Private Cloud) eingesetzt werden. Dies ist oft die einzige legale Möglichkeit, LLM-Technologie zu nutzen. Darüber hinaus bedeutet die Bereitstellung von Llama in einer sicheren VPC, dass alle Ihre Daten geschützt sind und Ihre Firewall nie verlassen. Dadurch wird das Risiko einer Datenfreigabe durch Dritte effektiv eliminiert.

Kurz gesagt, der Business Case für Llama ist Eigentum. Sie erhalten die Kontrolle über Ihren Wettbewerbsvorteil, die Sicherheit Ihrer Daten und Ihre Kosten zurück.

Metas Llama bietet Unternehmen eine neue Möglichkeit, KI zu nutzen. Dieses leistungsstarke KI-Modell bietet ein breites Anwendungsspektrum, darunter Konversations-KI, Bild- und Textgenerierung, Sprachtraining, Zusammenfassungen und andere damit verbundene Aufgaben. Durch den Einsatz fortschrittlicher KI-Funktionen kann Llama Unternehmen dabei helfen, erfolgreich zu sein.

• Kundenservice und Support

Fortschrittliche Chatbots oder virtuelle Assistenten mit Llama-Unterstützung können Kundenfragen, insbesondere komplexe, besser verstehen und korrekte, kontextbezogene Antworten liefern. Ein 24/7-Kundensupport ist von Vorteil.

• Datenanalyse und Business Intelligence

Llama kann Daten aus verschiedenen Quellen abrufen und Entscheidungen treffen, die zunächst technische Kenntnisse erforderten. Es ermöglicht Geschäftsführern und Analysten, durch das Stellen von Fragen eine SQL-Abfrage zu erhalten. Das Modell kann Text, Bilder, Diagramme und andere Inhalte analysieren, um eine narrative Zusammenfassung zu erstellen. So lassen sich neue Trends, Wettbewerbseinblicke und häufige Beschwerden schnell erkennen.

• Marketing- und Inhaltsautomatisierung

Die Erstellung hochwertiger und SEO-optimierter Inhalte ist zeitaufwändig. Llama kann schnell Entwürfe oder ganze Artikel mit einem einfachen Thema und mehreren Schlüsselwörtern erstellen. Menschliche Redakteure können diese Ergebnisse anschließend verfeinern. Das Modell kann auch die Erstellung von Social-Media-Posts automatisieren. Darüber hinaus hilft es beim Verfassen überzeugender Betreffzeilen für E-Mails und Anzeigen.

• Softwareentwicklung

Ein codespezifisches Llama-Modell kann als erweiterte Autovervollständigung fungieren, um die Codequalität zu erhalten, Legacy-Systeme zu verwalten und Entwicklungszyklen zu beschleunigen. Es kann bei der Überprüfung des Codes auf potenzielle Fehler helfen. Darüber hinaus kann es basierend auf den Quellcodekommentaren automatisch Codedokumentation und API-Referenzen generieren und aktualisieren.

Dieser Abschnitt bietet einen tabellarischen Vergleich der Llama-Serie von Meta mit anderen führenden Alternativen. Sie können diese Schlüsselfaktoren vergleichen, um die beste Lösung für Ihre spezifischen Anforderungen zu finden.

Es sollte klar sein, dass diese KI-Modelle ihre eigenen Stärken und Schwächen haben. Bei der Auswahl geht es nicht darum, eine einzige Option zu finden.

| KI-Modelle | Metas LLaMA 4/3/2 | GPT-4 von OpenAI | Anthropics Claude 3 | Googles PaLM 2 |

| Lizenz | Open Source, benutzerdefinierte Lizenz | Proprietär | Proprietär | Proprietär |

| Zugang | Herunterladen und selbst hosten | Nur API Zugang über Abonnement | Nur API Zugriff über nutzungsbasierte Preise | Nur API Zugriff über Googles Vertex AI |

| KI-Modelle | Metas LLaMA 4/3/2 | GPT-4 von OpenAI | Anthropics Claude 3 | Googles PaLM 2 |

| Leistung | Spitzenklasse Konkurrenzfähig mit führenden KI-Modellen. Erfordert Feinabstimmung, um bei bestimmten Aufgaben die Leistung von GPT-4 zu erreichen. Liefert nicht genügend ansprechende, hochwertige kreative Inhalte. | Branchenführer Beherrschen Sie komplexes Denken, Nuancen und kreative Problemlösungen | Spitzenklasse Hervorragend in Datenanalyse, anspruchsvollem Dialog und Argumentation im Langzeitkontext | Spitzenklasse Hervorragend im logischen Denken und bei mehrsprachigen Aufgaben |

| Kostenstruktur | Hohe Investitionskosten, niedrige Betriebskosten Kostenstaffelung mit Modellgröße und Nutzungsvolumen | Keine Investitionsausgaben, hohe Betriebsausgaben Nein Anschaffungskosten, aber Bezahlung pro Token für die Nutzung | Keine Investitionskosten, hohe Betriebskosten Ähnlich wie bei OpenAI, Pay-per-Token | Keine Investitionskosten, hohe Betriebskosten Pay-per-Token auf Vertex AI, mit Mengenrabatten |

| Datenschutz und Sicherheit | Maximale Kontrolle Die Daten verlassen niemals Ihre Infrastruktur. Ideal für stark regulierte Branchen. | Eingabe-/Ausgabedaten werden auf den Servern von OpenAI verarbeitet | Strenge Datenschutzrichtlinien, aber die Daten werden von Anthropic verarbeitet | Sicherheit auf Unternehmensniveau. Daten werden in Google Cloud verarbeitet. Bietet VPC-Kontrollen und Verpflichtungen zur Datenaufbewahrung. |

| Anpassung und Kontrolle | Vollständige Kontrolle Kann vollständig auf proprietäre Daten abgestimmt werden | Begrenzt Feinabstimmung ist nur für ältere Modelle verfügbar (nicht GPT-4) | Begrenzt Individuell angepasst durch schnelles Engineering und Kontext | Stark Gute Unterstützung für Feinabstimmung und bestärkendes Lernen |

| Skalierbarkeit | Sie müssen Ihre eigene Infrastruktur bereitstellen und verwalten | OpenAI verwaltet die gesamte Infrastruktur | Anthropic verwaltet die gesamte Infrastruktur | Google Cloud verwaltet die Infrastruktur |

Generell eignet sich Llama ideal für Unternehmen, die volle Kontrolle, Datenschutz und individuelle Anpassungsmöglichkeiten wünschen. GPT-4 eignet sich am besten für Unternehmen, die höchste Leistung und höchste Argumentationsfähigkeiten benötigen. Es bewältigt komplexe Aufgaben, insbesondere kreative und fortgeschrittene Analysen, besser. Claude 3 eignet sich ideal für Anwendungen, bei denen Sicherheit und reduzierte Verzerrungen im Vordergrund stehen. Es erzeugt selten schädliche Ergebnisse. PaLM 2 eignet sich am besten für Unternehmen, die tief in das Google Cloud-Ökosystem integriert sind. Es gewährleistet eine nahtlose Integration mit anderen Google-Tools.

Bevor Sie Llama einsetzen, sollten Sie zunächst Ihre Anforderungen entsprechend dem spezifischen Anwendungsfall ermitteln. Benötigen Sie das 70B-Parametermodell für maximale Qualität oder nur das 8B-Modell für grundlegende Aufgaben?

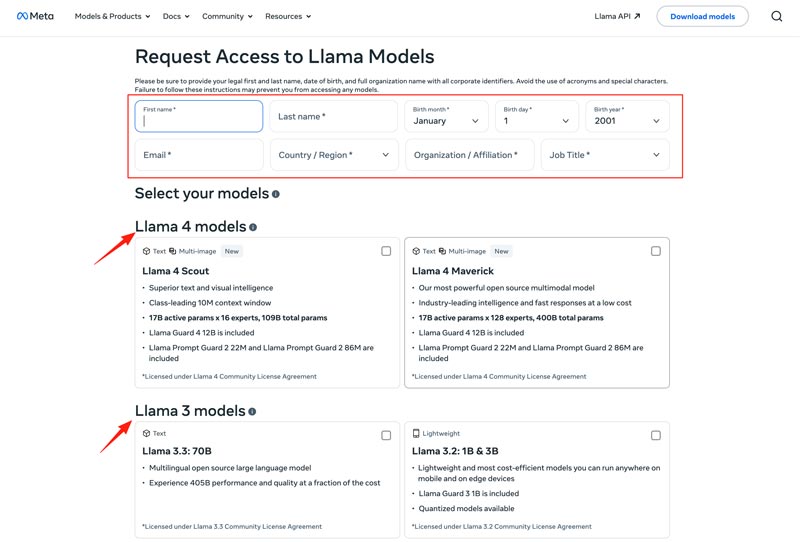

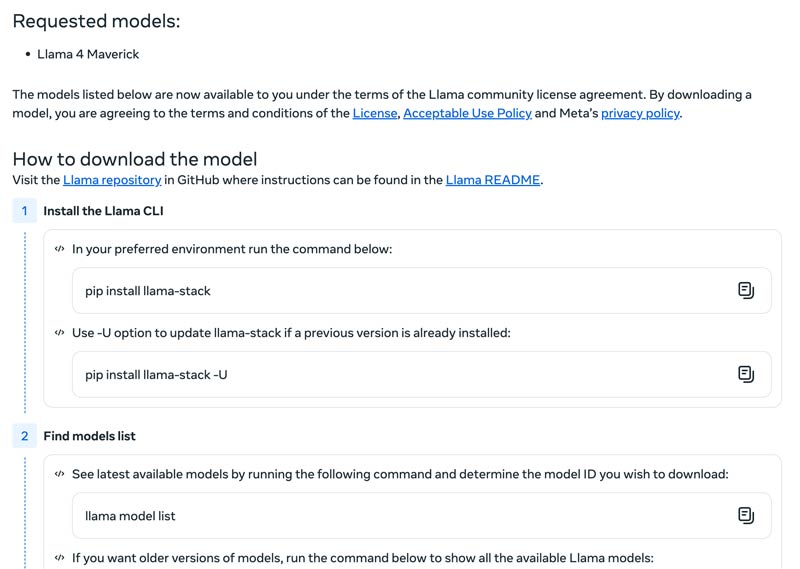

Wählen Sie Ihre Bereitstellungsmethode, z. B. einen lokalen Computer, eine Cloud-VM oder einen verwalteten Dienst. Für die effiziente Ausführung von Llama-Modellen ist häufig eine leistungsstarke GPU erforderlich, insbesondere bei größeren Modellen. Anschließend können Sie das passende Modell von der Meta-Website herunterladen.

Drücke den Modelle herunterladen , um die Zugriff anfordern Seite. Geben Sie die erforderlichen Informationen ein und wählen Sie das gewünschte Llama-Modell aus.

Drücke den Nächste Schaltfläche zum Lesen Geschäftsbedingungen. Sie sollten die Community-Lizenzvereinbarung sorgfältig prüfen und dann auf Akzeptieren und fortfahren Klicken Sie auf die Schaltfläche. Folgen Sie den Anweisungen auf dem Bildschirm, um das ausgewählte Modell herunterzuladen.

Sie können ein Framework wie Text Generation Inference verwenden, um einen leistungsstarken API-Server zu erhalten. Wenn Sie eine Chat-Schnittstelle benötigen, implementieren Sie eine Benutzeroberfläche wie Chatbot UI oder NextChat. Verwenden Sie anschließend Ihre proprietären Daten mit Frameworks, um Ihr eigenes spezialisiertes Modell zu erstellen.

Sie sollten wissen, wie Sie Herausforderungen meistern, um KI-Modelle effektiv zu nutzen.

• Komplexität der Ersteinrichtung

Sie können die vorgefertigten Tools und Container nutzen. Führen Sie Modelle lokal mit einem einzigen Befehl aus. Sie können auch auf Cloud-basierte Plattformen ohne lokale Einrichtung zurückgreifen. Mit Hugging Face können Sie Demos in vorkonfigurierten Umgebungen ausführen und erstellen. Darüber hinaus können Sie mit llama.cpp eine quantisierte Version von Llama ausführen.

• Ressourcenmanagement und Kostenoptimierung

Große Modelle erfordern GPUs mit großem Speicher, die oft selten und teuer sind.

Quantisierung ist die effektivste Technik. Sie können Bibliotheken für die 4-Bit-Quantisierung während der Inferenz oder Feinabstimmung verwenden. Verwenden Sie auf weniger leistungsstarker Hardware llama.cpp zum Ausführen von Modellen. Beide Methoden können den Speicherverbrauch effektiv reduzieren. Stellen Sie außerdem sicher, dass Sie das richtige Modell für Ihre Aufgaben auswählen. Ein kleineres, feinabgestimmtes Modell kann kostengünstiger sein.

• Bleiben Sie über Neuerscheinungen auf dem Laufenden

Wöchentlich werden zahlreiche neue Modelle, Techniken und Bibliotheken veröffentlicht. Es kann schwierig sein, auf dem Laufenden zu bleiben.

Abonnieren Sie die offiziellen Blogs wie Meta AI, Hugging Face und vLLM. Darüber hinaus werden auf Plattformen wie GitHub und Hugging Face neue Optimierungstechniken, Anwendungen, Effizienzsteigerungen, Erfahrungen, Lösungen und mehr geteilt. So kann Ihr Team Verbesserungen integrieren.

Sie benötigen möglicherweise auch:

Frage 1. Ist es zulässig, die Ausgabe der Llama-Modelle zum Trainieren anderer LLMs zu verwenden?

Ja, Meta erlaubt die Verwendung neuerer Versionen (Llama 3.1 und höher) der Llama-Ausgabe zum Trainieren anderer Modelle. Natürlich ist es Ihnen nicht gestattet, damit ein Produkt zu erstellen, das mit Meta konkurriert. Darüber hinaus müssen Sie sich der rechtlichen Grenzen der Meta-Lizenz bewusst sein.

Frage 2. Gibt es für Llama-Modelle Einschränkungen? Welche Begriffe sind damit verbunden?

Ja, Llama-Modelle unterliegen erheblichen Einschränkungen, die durch ihre Lizenzstruktur definiert sind. Diese Modelle sind nicht wirklich Open Source. Stattdessen werden sie unter einer proprietären Lizenz von Meta veröffentlicht. Dies dient dem Schutz der Interessen von Meta und der Verhinderung konkurrierender Anwendungsfälle.

Frage 3. Was sind die häufigsten Anwendungsfälle von Llama?

Zu den alltäglichen Anwendungsfällen von Llama gehören Bild- und Dokumentverständnis, Fragenbeantwortung, Bild- und Textgenerierung, Sprachgenerierung und -zusammenfassung, Sprachtraining, Konversations-KI und mehr. Llama kann Ihre Fragen basierend auf den von Ihnen bereitgestellten Bild- oder Dokumentinhalten beantworten. Darüber hinaus kann es zur Erstellung eines Chatbots oder eines visuellen Assistenten verwendet werden.

Frage 4. Welche Hardwareanforderungen gelten für die Verwendung von Llama-Modellen?

Die Hardwareanforderungen für die Ausführung von Llama-Modellen werden durch drei Schlüsselfaktoren bestimmt: Modellgröße, Quantisierung und Anwendungsfall. Für die meisten Entwickler ist eine RTX 4070/4080/4090 oder ein Mac mit 16–36 GB Unified Memory eine flexible Wahl für Llama-Modelle bis zu 70 B. Für den GPU-basierten Betrieb ist der VRAM Ihrer Grafikkarte der wichtigste Faktor. Wählen Sie wie bereits erwähnt die richtige Modellgröße entsprechend Ihren Anforderungen und anschließend die Quantisierungsstufe, die auf Ihrer Hardware ausgeführt werden kann.

Frage 5. Ist Llama so gut wie ChatGPT?

Sie können die Tabelle oben überprüfen, um die Schlüsselfaktoren zwischen Lama und ChatGPTLlama kann lokal und offline ausgeführt werden. Es bietet einen sichereren Datenschutz. Darüber hinaus ist das Llama-Modell selbst kostenlos nutzbar. ChatGPT bietet eine kostenlose Version, für die erweiterten Modelle und Funktionen ist jedoch ein kostenpflichtiger Plan erforderlich.

Abschluss

Lama ist nicht einfach nur ein weiteres Modell. Es wird oft als strategischer Wandel hin zu einer zugänglicheren und anpassbareren KI-Zukunft angesehen. In diesem sachlichen Testbericht erfahren Sie alles Wissenswerte über die Llama AI-Familie und finden heraus, ob sie den Hype wert ist.

Fanden Sie dies hilfreich?

484 Stimmen