Reflektorfény: AI chat, játékok, mint a Retro, helyváltó, Roblox feloldva

Reflektorfény: AI chat, játékok, mint a Retro, helyváltó, Roblox feloldva

A Llama 1 úttörő megjelenése óta a zárt, saját API-k visszavonhatatlanul demokratizálódtak. A Meta nyílt forráskódú Llama (Large Language Model Meta AI) sorozata átalakította a mesterséges intelligencia világát. A rendkívül hatékony Llama 3 és a legújabb kiadású Llama 4 teszi ezt a modellcsaládot a nyílt forráskódú mesterséges intelligencia innováció alapjává.

Ha a számtalan mesterséges intelligencia modell zavarba ejt, olvasd el ezt az átfogó képet Láma értékelésMegtudhatod, mi a Llama, mi teszi egyedivé a Llama AI-t, meggyőző üzleti indoklást, versenyhelyzetet olyan óriásokkal szemben, mint a ChatGPT, egy gyakorlati útmutatót vállalatoknak és még sok mást.

Tartalomjegyzék

Láma a Meta által fejlesztett alapvető nagy nyelvi modellek gyűjteményére utal. A korábbi, csak API-n keresztül elérhető modellekkel ellentétben a Llama sorozat nyilvánosan elérhető kutatási és kereskedelmi felhasználásra. Valójában egy egyedi licencet terveztek a visszaélések megakadályozására, és meghatározott skálázási feltételek mellett érvényes. A legújabb verzió a Llama 4.

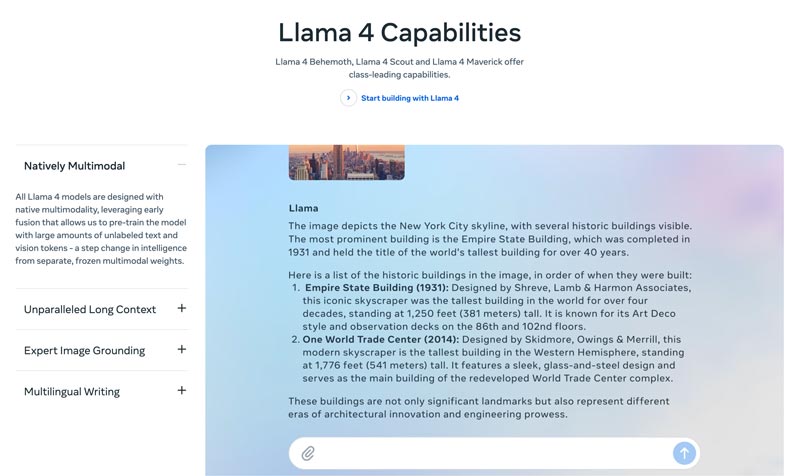

Láma 4 a legújabb verzió. A Meta azt állítja, hogy ez a legintelligensebb, legskálázhatóbb és legkényelmesebb verzió. Fejlettebb érvelési és tervezési képességeivel, multimodális képességeivel és többnyelvű írási funkcióival a Llama 4 az iparágvezető kontextuális ablak lehet. Lehetővé teszi a leghihetetlenebb ötletek egyszerű megvalósítását a Llama API és a Llama Stack segítségével. A jelenlegi Llama 4 személyre szabottabb élményt kínál.

Láma 3 2024 áprilisában jelent meg. A Llama 2-höz képest a Llama 3 számos fejlesztést tartalmaz, beleértve a továbbfejlesztett érvelést és kódolást, a továbbfejlesztett betanítási adatokat, a nagyobb kontextuális ablakot és a hatékonyabb tokenizert.

1. és 2. láma: Az eredeti Llama 2023 elején, a Llama 2 pedig 2023 júliusában jelent meg. Ez jelentette a Meta közvetlen belépését a chatbot arénába. A Llama 2 óta egy finomhangolt változattal a sorozat hasznos és biztonságos párbeszédet biztosít. A Llama 1/2-t elsősorban az OpenAI ChatGPT-jének és a Google Bardjának szemtől szembeni kihívására fejlesztették ki.

A Meta által fejlesztett, a mesterséges intelligencia világának átalakítására szolgáló... nagy teljesítményű Nem lesz gondod. A Llama a vállalatod specifikus adataira van finomhangolva, hogy bizonyos feladatokhoz felülmúlja a nagyobb, általános modelleket. A finomhangolás lehetősége a legtöbb fejlesztő és kutató számára alkalmassá teszi.

A Láma egyedisége nem csak a teljesítményében rejlik. láma által létrehozott ökoszisztéma nagyobb előnyt jelenthet. A Hugging Face ökoszisztéma innovációs robbanást indított el. Több ezer finomhangolt származék áll rendelkezésre a különböző elképzelhető feladatokhoz.

Ráadásul Llama mindenki kezébe adott egy első osztályú LLM-et. a mesterséges intelligencia demokratizálása egy másik előny, ami egyedivé teszi a Llamát. A Llama MI-modelljei minden kutató, fejlesztő és startup számára elérhetők, hogy API-díjak fizetése vagy engedélykérés nélkül használhassák, újíthassák és építhessenek.

Stratégiai előny a vállalkozások számára. A Llama lehetővé teszi, hogy a mesterséges intelligencia épületed a saját tulajdonod legyen. Nem kell többé egy szállító árazásához, szabályzatváltozásaihoz vagy API-elavulásaihoz kötődnöd. Ez hatékonyan elkerüli a szállítóhoz való kötődést.

A Llama üzleti terve nem csupán egy másik MI-modell használatáról szól. Valójában alapvető változást hozhat abban, ahogyan egy vállalat a mesterséges intelligenciát kezeli.

A kezdeti időkben sok vállalkozás API-alapú szolgáltatásokat vezetett be, mint például az OpenAI GPT-4-ét. Ez lehet a legkényelmesebb megoldás, amely lehetővé teszi az alacsony küszöbű kísérletezést és a gyors prototípus-készítést. Ezt a mesterséges intelligencia stratégiát azonban egy stratégiaibb, hosszú távú megközelítés, olyan nyílt forráskódú alapmodellek váltották fel, mint a Meta Llama-ja. A Llama esete három kulcsfontosságú tényezőn nyugszik: költségmegtakarítás, kontroll és testreszabás, valamint adatbiztonság.

Az API-költségek sok vállalat számára (naponta több millió lekérdezés feldolgozása) évi több millióra rúghatnak. A Llama bevezetése az üzemeltetési költségekről (OpEx) a tőkekiadásokra (CapEx) való áttérést jelenti. Ez nagy volumen esetén egyértelművé teszi a megtérülést (ROI).

A Llama segítségével egyedileg finomhangolt mesterséges intelligenciát hozhatsz létre, amely a legjobban illik az üzleti tevékenységedhez vagy termékeidhez. Teljes mértékben kontrollálhatod a modelled bemeneteit és kimeneteit. Az alapvető eszközzé válik, nem pedig bérelt szolgáltatássá.

A kormányzati és pénzügyi szektornak szigorú adatkezelési követelményei vannak. A Llama telepíthető teljes egészében helyszíni környezetben vagy egy megfelelő VPC-ben (virtuális magánfelhő). Ez gyakran az egyetlen legális módja az LLM technológia kihasználásának. Sőt, a Llama biztonságos VPC-n belüli telepítése azt jelenti, hogy minden adata biztonságban van, és soha nem hagyja el a tűzfalat. Ez hatékonyan kiküszöböli a harmadik féltől származó adatok kiszivárgásának kockázatát.

Egy szóval, a Llama üzleti terve a következő: tulajdonVisszakapod a versenyelőnyöd, az adatbiztonságod és a költségeid tulajdonjogát.

A Meta Llama új módot kínál a vállalkozások számára a mesterséges intelligencia használatára. Ez a hatékony MI-modell széleskörű alkalmazási lehetőségekkel rendelkezik, beleértve a beszélgetési MI-t, a képfeldolgozást és a... szöveggenerálás, nyelvi képzés, összefoglalás és egyéb kapcsolódó feladatok. A fejlett mesterséges intelligencia képességeinek használatával a Llama segíthet a vállalkozásoknak a siker elérésében.

• Ügyfélszolgálat és támogatás

A Llama által működtetett fejlett chatbotok vagy virtuális asszisztensek jobban megértik az ügyfelek kérdéseit, különösen az összetett lekérdezéseket, és helyes, kontextus-érzékeny válaszokat adnak. Előnyös a 24/7-es ügyfélszolgálat biztosítása.

• Adatelemzés és üzleti intelligencia

A Llama különböző forrásokból képes adatokat kinyerni, és olyan döntéseket hozni, amelyek kezdetben technikai ismereteket igényeltek. Lehetővé teszi az üzleti vezetők és elemzők számára, hogy kérdések feltevésével SQL-lekérdezéseket kapjanak. A modell képes szöveget, képeket, diagramokat és egyéb tartalmakat elemezni, hogy narratív összefoglalót adjon. Ez segít gyorsan azonosítani a felmerülő trendeket, a versenyhelyzettel kapcsolatos információkat és a gyakori panaszokat.

• Marketing és tartalomautomatizálás

A kiváló minőségű és SEO-optimalizált tartalom előállítása időigényes folyamat. A Llama gyorsan képes vázlatokat vagy teljes cikkeket generálni egy egyszerű témával és néhány kulcsszóval. Az emberi szerkesztők ezután finomíthatják ezeket az eredményeket. A modell automatizálhatja a közösségi média bejegyzések létrehozását is. Ezenkívül segíthet vonzó tárgysorok írásában e-mailekhez és hirdetésekhez.

• Szoftverfejlesztés

Egy kódspecifikus Llama modell fejlett automatikus kiegészítésként működhet a kódminőség fenntartása, a régi rendszerek kezelése és a fejlesztési ciklusok felgyorsítása érdekében. Segíthet a kód áttekintésében az esetleges hibák szempontjából. Ezenkívül automatikusan generálhatja és frissítheti a kóddokumentációt és az API-hivatkozásokat a forráskódhoz fűzött megjegyzések alapján.

Ez a rész táblázatos formában összehasonlítja a Meta Llama sorozatát más vezető alternatívákkal. Összehasonlíthatja ezeket a kulcsfontosságú tényezőket, hogy megtalálja az Ön igényeinek leginkább megfelelőt.

Világosnak kell lennie, hogy ezeknek a mesterséges intelligencia modelleknek megvannak a maguk erősségei és gyengeségei. A választás nem arról szól, hogy egyetlen lehetőséget találjunk.

| AI modellek | Meta LLaMA 4/3/2 | Az OpenAI GPT-4-je | Antropic Claude 3 | A Google PaLM 2-je |

| Engedély | Nyílt forráskódú, egyedi licenc | Szabadalmazott | Szabadalmazott | Szabadalmazott |

| Hozzáférés | Letöltés és saját tárhely | Csak API-n keresztül Hozzáférés előfizetésen keresztül | Csak API-n keresztül Hozzáférés használatalapú árképzésen keresztül | Csak API-n keresztül Hozzáférés a Google Vertex mesterséges intelligenciáján keresztül |

| AI modellek | Meta LLaMA 4/3/2 | Az OpenAI GPT-4-je | Antropic Claude 3 | A Google PaLM 2-je |

| Teljesítmény | Felső kategóriás Versenyképes a vezető AI-modellekkel Finomhangolást igényel a GPT-4 teljesítményének eléréséhez bizonyos feladatoknál Nem elég hatékony a lebilincselő, kiváló minőségű kreatív tartalom előállításában | Iparágvezető Kezeli az összetett érvelést, az árnyaltságot és a kreatív problémamegoldást | Felső kategóriás Kiváló adatelemzésben, kifinomult párbeszédekben és hosszú kontextusú érvelésben | Felső kategóriás Kiválóan képes logikusan gondolkodni és többnyelvű feladatokat végezni |

| Költségszerkezet | Magas tőkekiadás, alacsony működési költség Költségskálák modellmérettel és felhasználási volumennel | Nincsenek beruházási költségek, magas üzemeltetési költségek. kezdeti költség, de a használatért tokenenként kell fizetni | Nincsenek beruházási költségek, magas üzemeltetési költségek Az OpenAI-hoz hasonlóan, tokenenkénti fizetés | Nincsenek beruházási költségek, magas üzemeltetési költségek Fizetés tokenenként a Vertex AI-n, mennyiségi kedvezményekkel |

| Adatvédelem és biztonság | Maximális kontroll Az adatok soha nem hagyják el az infrastruktúráját. Ideális a szigorúan szabályozott iparágak számára. | A bemeneti/kimeneti adatokat az OpenAI szerverein dolgozzák fel. | Szigorú adatvédelmi irányelvek, de az adatokat az Anthropic dolgozza fel | Vállalati szintű biztonság Google Cloudon feldolgozott adatok VPC-vezérlést és adattárolási kötelezettségeket kínál |

| Testreszabás és vezérlés | Teljes kontroll Saját adatokon teljesen finomhangolható | Korlátozott A finomhangolás csak régebbi modelleken érhető el (nem GPT-4) | Korlátozott Testreszabható gyors mérnöki és kontextusalapú megoldásokkal | Erős Jó támogatás a finomhangoláshoz és a megerősítéses tanuláshoz |

| Skálázhatóság | Saját infrastruktúrát kell kiépítenie és kezelnie | Az OpenAI kezeli az összes infrastruktúrát | Az Anthropic kezeli az összes infrastruktúrát | A Google Cloud kezeli az infrastruktúrát |

Általánosságban elmondható, hogy a Llama ideális azoknak a vállalatoknak, amelyek a teljes kontrollt, az adatvédelmet és a testreszabhatóságot részesítik előnyben. A GPT-4 azoknak a vállalatoknak a legmegfelelőbb, amelyek a legmagasabb nyers teljesítményt és logikai képességeket igénylik. Jobban képes kezelni az összetett feladatokat, különösen a kreatív és a haladó elemzéseket. A Claude 3 ideális olyan alkalmazásokhoz, ahol a biztonság és a csökkentett torzítás kiemelkedő fontosságú. Ritkán termel káros kimeneteket. A PaLM 2 a legjobb azoknak a vállalkozásoknak, amelyek mélyen integrálódtak a Google Cloud ökoszisztémába. Zökkenőmentes integrációt biztosít más Google eszközökkel.

A Llama telepítése előtt először is fel kell mérned az igényeidet az adott felhasználási esetnek megfelelően. Szükséged van-e a 70B paramétermodellre a maximális minőség érdekében, vagy csak a 8B modellre az alapvető feladatokhoz?

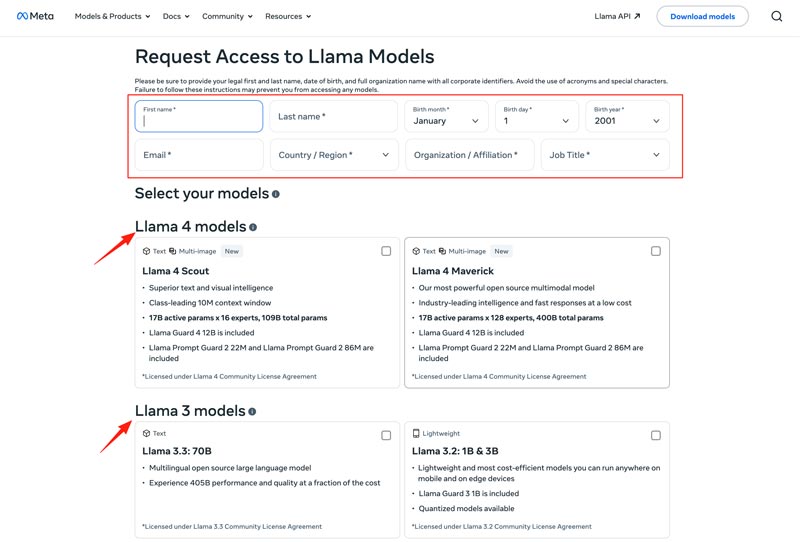

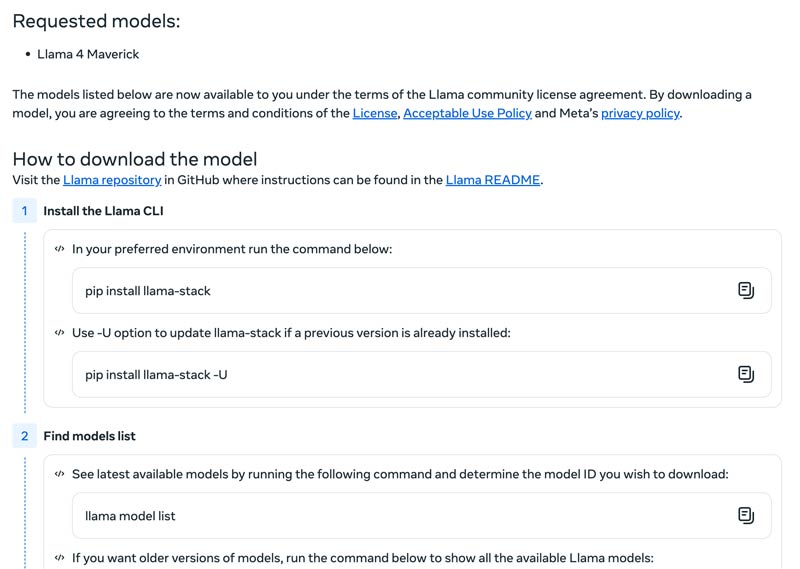

Ki kell választania a telepítési módszert, például helyi gépet, felhőalapú virtuális gépet vagy felügyelt szolgáltatást. A Llama modellek hatékony futtatásához gyakran nagy teljesítményű GPU szükséges, különösen a nagyobb modellek esetében. Ezt követően letöltheti a megfelelő modellt a Meta webhelyéről.

Kattints a Modellek letöltése gombot a belépéshez Hozzáférés kérése oldal. Adja meg a szükséges információkat, és válassza ki a kívánt láma modellt.

Kattints a Következő gomb az olvasáshoz Felhasználási feltételek. Gondosan ellenőrizze a Közösségi Licencszerződést, majd kattintson a Elfogadás és folytatás gombra. A kiválasztott modell letöltéséhez kövesse a képernyőn megjelenő utasításokat.

Használhatsz egy olyan keretrendszert, mint a Text Generation Inference, hogy nagy teljesítményű API-kiszolgálót kapj. Ha csevegőfelületre van szükséged, telepíts egy olyan felhasználói felületet, mint a Csevegőrobot UI vagy NextChat. Ezután a saját adataid felhasználásával keretrendszereket használhatsz saját, specializált modelled létrehozásához.

Tudnia kell, hogyan győzheti le a kihívásokat az AI-modellek hatékony használatához.

• Kezdeti beállítás bonyolultsága

Használhatod az előre elkészített eszközeit és konténereit. Modelleket futtathatsz helyben egyetlen paranccsal. Felhőalapú platformokhoz is fordulhatsz helyi beállítások nélkül. A Hugging Face lehetővé teszi demók futtatását és létrehozását előre konfigurált környezetekben. Ezenkívül a llama.cpp fájllal elindíthatod a Llama kvantált verziójának futtatását.

• Erőforrás-gazdálkodás és költségoptimalizálás

A nagy modellek nagy memóriájú GPU-kat igényelnek, amelyek gyakran ritkák és költségesek.

A kvantálás a leghatékonyabb technika. Használhatsz könyvtárakat a 4 bites kvantáláshoz következtetés vagy finomhangolás során. Kevésbé erős hardvereken használd a llama.cpp fájlt modellek futtatásához. Mindkét módszer hatékonyan csökkentheti a memóriahasználatot. Ezenkívül ügyelj arra, hogy a feladatokhoz megfelelő modellt válaszd. Egy kisebb, finomhangolt modell költséghatékonyabb lehet.

• Naprakészség az új megjelenésekkel kapcsolatban

Hetente sok új modell, technika és könyvtár jelenik meg. Nehéz lehet naprakésznek maradni.

Iratkozz fel a hivatalos blogokra, mint például a Meta AI, a Hugging Face és a vLLM. Sőt, új finomhangolási technikákat, alkalmazásokat, hatékonyságnövelési ötleteket, tapasztalatokat, megoldásokat és egyebeket osztunk meg olyan platformokon, mint a GitHub és a Hugging Face. Ez lehetővé teszi a csapatod számára a fejlesztések integrálását.

Szükséged lehet még:

1. kérdés. Szabad-e a Llama modellek kimenetét más LLM-ek betanítására használni?

Igen, a Meta engedélyezi a Llama kimenetének újabb verzióinak (Llama 3.1 és újabb) használatát más modellek betanítására. Természetesen nem engedélyezett a Llama kimenetének felhasználása olyan termék létrehozására, amely versenyez a Metával. Ezenkívül tisztában kell lenned a Meta licence által meghatározott jogi korlátokkal.

2. kérdés. Vannak-e korlátozások a láma modellekre vonatkozóan? Milyen kapcsolódó kifejezések vannak?

Igen, a Llama modellek jelentős korlátozásokkal rendelkeznek, amelyeket a licencelési struktúrájuk határoz meg. Ezek a modellek nem igazán nyílt forráskódúak. Ehelyett a Meta saját licence alatt kerülnek kiadásra. Ez a Meta érdekeinek védelmét és a versenyképes felhasználási esetek megakadályozását szolgálja.

3. kérdés. Melyek a Llama leggyakoribb használati esetei?

A Llama mindennapi használati esetei közé tartozik a képek és dokumentumok megértése, a kérdések megválaszolása, a képek és szövegek generálása, a nyelvek generálása és összefoglalása, a nyelvi képzés, a mesterséges intelligencia és egyebek. A Llama a megadott kép vagy dokumentum tartalma alapján válaszolhat a kérdésére. Ezenkívül chatbot vagy vizuális asszisztens létrehozására is használható.

4. kérdés. Milyen hardverkövetelmények szükségesek a Llama modellek használatához?

A Llama modellek futtatásának hardverkövetelményeit három kulcsfontosságú tényező határozza meg: a modell mérete, a kvantálás és a használati eset. A legtöbb fejlesztő számára egy RTX 4070/4080/4090 vagy egy 16-36 GB Unified Memory-val rendelkező Mac rugalmas választás a Llama modellekhez, akár 70B-ig. GPU-alapú működés esetén a legfontosabb tényező a grafikus kártya VRAM-ja. Ahogy említettük, válaszd ki a megfelelő modellméretet az igényeid alapján, majd válaszd ki a hardvereden futtatható kvantálási szintet.

5. kérdés. A Llama olyan jó, mint a ChatGPT?

A fenti táblázatban összehasonlíthatja a Llama és a többi kulcsfontosságú tényezőjét. ChatGPTA Llama helyben és offline is futtatható. Biztonságosabb adatvédelmet kínál. Sőt, maga a Llama modell is ingyenesen használható. A ChatGPT-nek van egy ingyenes verziója, de a fejlett modellekhez és funkciókhoz fizetős csomag szükséges.

Következtetés

Láma nem csupán egy újabb modell. Gyakran tekintik stratégiai elmozdulásnak egy könnyebben hozzáférhető és testreszabható MI-jövő felé. Ebben a lényegre törő áttekintésben számos kapcsolódó információt tudhatsz meg a Llama AI-családról, majd megtudhatod, hogy megéri-e a felhajtást.

Hasznosnak találta ezt?

484 Szavazatok