Schijnwerper: AI-chat, spellen zoals Retro, locatie wisselaar, Roblox gedeblokkeerd

Schijnwerper: AI-chat, spellen zoals Retro, locatie wisselaar, Roblox gedeblokkeerd

Sinds de baanbrekende release van Llama 1 zijn de gesloten, propriëtaire API's onherroepelijk gedemocratiseerd. Meta's open-source Llama (Large Language Model Meta AI)-serie heeft het AI-landschap radicaal veranderd. De uiterst capabele Llama 3 en de recent uitgebrachte Llama 4 maken deze familie van modellen tot de basis voor open-source AI-innovatie.

Als u in de war raakt door de talloze AI-modellen, lees dan deze uitgebreide Lama recensieU leert wat Llama is, wat Llama AI uniek maakt, wat de overtuigende businesscase is, wat de concurrentiepositie is ten opzichte van giganten zoals ChatGPT, een praktische gids voor ondernemingen en nog veel meer.

Inhoudsopgave

Lama Verwijst naar een verzameling fundamentele, grote taalmodellen, ontwikkeld door Meta. In tegenstelling tot eerdere modellen, die alleen via API toegankelijk waren, wordt de Llama-serie openbaar gemaakt voor onderzoek en commercieel gebruik. Een aangepaste licentie is ontworpen om misbruik te voorkomen en is van toepassing onder specifieke schaalvoorwaarden. De nieuwste versie is Llama 4.

Lama 4 is de nieuwste versie. Meta beweert dat het de meest intelligente, schaalbare en gebruiksvriendelijke versie is. Met geavanceerdere redeneer- en planningsmogelijkheden, multimodale mogelijkheden en meertalige schrijffuncties kan Llama 4 hét toonaangevende contextvenster in de branche zijn. Het stelt je in staat om je meest fantastische ideeën eenvoudig te implementeren met de Llama API en de Llama Stack. De huidige Llama 4 biedt meer gepersonaliseerde ervaringen.

Lama 3 werd uitgebracht in april 2024. Vergeleken met Llama 2 bevat Llama 3 diverse verbeteringen, waaronder verbeterde redenering en codering, verbeterde trainingsgegevens, een groter contextvenster en een efficiëntere tokenizer.

Lama 1 & 2: De originele Llama werd begin 2023 uitgebracht en Llama 2 in juli 2023. Ze markeerden Meta's directe entree in de chatbot-arena. Met een verfijnde variant, sinds Llama 2, biedt de serie een nuttige en veilige dialoog. Llama 1/2 is voornamelijk ontwikkeld om OpenAI's ChatGPT en Google's Bard rechtstreeks uit te dagen.

Ontwikkeld door Meta om het AI-landschap opnieuw vorm te geven, de hoge prestaties Dat is niet uw zorg. Llama is afgestemd op de specifieke gegevens van uw bedrijf en presteert beter dan grotere generieke modellen voor specifieke taken. De mogelijkheid tot finetuning maakt het geschikt voor de meeste ontwikkelaars en onderzoekers.

Het unieke van Llama zit niet alleen in zijn prestaties. ecosysteem dat Lama heeft voortgebracht kan een groter voordeel zijn. Het Hugging Face-ecosysteem heeft een explosie aan innovatie teweeggebracht. Duizenden verfijnde derivaten worden aangeboden voor verschillende denkbare taken.

Bovendien heeft Llama iedereen een LLM van topniveau gegeven. democratisering van AI is nog een voordeel dat Llama uniek maakt. Llama AI-modellen zijn beschikbaar voor alle onderzoekers, ontwikkelaars en startups om te gebruiken, te innoveren en te bouwen zonder API-kosten te betalen of toestemming te vragen.

Strategisch voordeel voor bedrijven. Met Llama bent u zelf de eigenaar van uw AI-gebouw. U hoeft zich niet langer te binden aan leveranciersprijzen, beleidswijzigingen of API-deprecations. Zo voorkomt u effectief vendor lock-in.

De businesscase voor Llama gaat niet alleen over het gebruik van een ander AI-model. Het kan zelfs een fundamentele verandering betekenen in de manier waarop een bedrijf met AI omgaat.

In de beginjaren maakten veel bedrijven gebruik van API-gebaseerde diensten, zoals GPT-4 van OpenAI. Dat kan de meest geschikte optie zijn, omdat het laagdrempelige experimenten en snelle prototyping mogelijk maakt. Deze AI-strategie is echter vervangen door een meer strategische, langetermijnbenadering, open-source basismodellen zoals Llama van Meta. De Llama-case berust op drie belangrijke factoren: kostenbesparing, controle en maatwerk, en gegevensbeveiliging.

De API-kosten voor veel bedrijven (die miljoenen query's per dag verwerken) kunnen jaarlijks in de miljoenen lopen. De implementatie van Llama betekent een verschuiving van operationele uitgaven (OpEx) naar kapitaaluitgaven (CapEx). Dat maakt de ROI bij hoge volumes duidelijk.

Met Llama creëert u een uniek, verfijnde AI die het beste bij uw bedrijf of producten past. U behoudt bovendien volledige controle over de input en output van uw model. Het wordt een kernactiviteit, geen gehuurde dienst.

Overheid en financiële instellingen hanteren strenge eisen voor data governance. Llama kan volledig on-premise of in een compatibele VPC (Virtual Private Cloud) worden geïmplementeerd. Dat is vaak de enige legale manier om LLM-technologie te gebruiken. Bovendien betekent de implementatie van Llama in een beveiligde VPC dat al uw gegevens veilig zijn en nooit uw firewall verlaten. Dit elimineert effectief het risico op gegevenslekken van derden.

Kortom, de businesscase voor Llama is ongeveer eigendomU krijgt het eigenaarschap over uw concurrentievoordeel, de veiligheid van uw gegevens en uw kosten weer terug.

Meta's Llama biedt bedrijven een nieuwe manier om AI te gebruiken. Dit krachtige AI-model heeft een breed scala aan toepassingen, waaronder conversationele AI, beeld- en tekstgeneratie, taaltraining, samenvattingen en andere gerelateerde taken. Door gebruik te maken van geavanceerde AI-mogelijkheden kan Llama bedrijven helpen succes te behalen.

• Klantenservice en ondersteuning

Geavanceerde chatbots of virtuele assistenten van Llama kunnen de vragen van klanten, met name complexe vragen, beter begrijpen en correcte, contextbewuste antwoorden geven. Het is daarom belangrijk om 24/7 klantondersteuning te bieden.

• Data-analyse en business intelligence

Llama kan data uit verschillende bronnen halen en beslissingen nemen die in eerste instantie technische vaardigheden vereisten. Het stelt bedrijfsmanagers en analisten in staat om een SQL-query te krijgen door vragen te stellen. Het model kan tekst, afbeeldingen, grafieken en andere content analyseren om een verhalende samenvatting te geven. Dit helpt om snel opkomende trends, inzichten in de concurrentie en veelvoorkomende klachten te identificeren.

• Marketing- en contentautomatisering

Het produceren van hoogwaardige en SEO-geoptimaliseerde content is tijdrovend. Llama kan snel concepten of complete artikelen genereren met een eenvoudig onderwerp en meerdere trefwoorden. Menselijke redacteuren kunnen deze resultaten vervolgens verfijnen. Het model kan ook het maken van berichten op sociale media automatiseren. Bovendien kan het helpen bij het schrijven van pakkende onderwerpregels voor e-mails en advertenties.

• Softwareontwikkeling

Een codespecifiek Llama-model kan fungeren als een geavanceerde autocomplete om de codekwaliteit te behouden, legacysystemen te beheren en ontwikkelcycli te versnellen. Het kan helpen bij het controleren van code op potentiële bugs. Bovendien kan het automatisch codedocumentatie en API-referenties genereren en bijwerken op basis van de opmerkingen in de broncode.

In deze sectie wordt de Llama-serie van Meta naast andere toonaangevende alternatieven in tabelvorm vergeleken. U kunt deze belangrijke factoren vergelijken om de beste oplossing voor uw specifieke behoeften te vinden.

Het moet duidelijk zijn dat deze AI-modellen hun eigen sterke en zwakke punten hebben. De keuze gaat niet om het vinden van één optie.

| AI-modellen | Meta's LLaMA 4/3/2 | GPT-4 van OpenAI | Claude 3 van Anthropic | Google's PaLM 2 |

| Licentie | Open-source, aangepaste licentie | Eigendom | Eigendom | Eigendom |

| Toegang | Downloaden en zelf hosten | Alleen API Toegang via abonnement | Alleen API Toegang via op gebruik gebaseerde prijzen | Alleen API Toegang via Google's Vertex AI |

| AI-modellen | Meta's LLaMA 4/3/2 | GPT-4 van OpenAI | Claude 3 van Anthropic | Google's PaLM 2 |

| Prestatie | Topklasse Concurrerend met top AI-modellen Vereist fine-tuning om de GPT-4-prestaties op specifieke taken te evenaren Beperkt in het leveren van boeiende, hoogwaardige creatieve content | Marktleider Omgaan met complexe redeneringen, nuances en creatieve probleemoplossing | Topklasse Uitstekend in data-analyse, geavanceerde dialogen en redeneren in lange contexten | Topklasse Uitstekend in redeneren en meertalige taken |

| Kostenstructuur | Hoge CapEx, lage OpEx Kostenschalen met modelgrootte en gebruiksvolume | Geen CapEx, Hoge OpEx Nee initiële kosten, maar betaal per token voor gebruik | Geen CapEx, hoge OpEx Vergelijkbaar met OpenAI, pay-per-token | Geen CapEx, hoge OpEx Betalen per token op Vertex AI, met volumekortingen |

| Gegevensbescherming en -beveiliging | Maximale controle Gegevens verlaten uw infrastructuur nooit. Ideaal voor sterk gereguleerde sectoren. | Input-/outputgegevens worden verwerkt op de servers van OpenAI | Sterk privacybeleid, maar gegevens worden verwerkt door Anthropic | Beveiliging op ondernemingsniveau Gegevens verwerkt op Google Cloud Biedt VPC-controles en dataresidentieverplichtingen |

| Aanpassing en controle | Volledige controle Kan volledig worden verfijnd op basis van eigen gegevens | Beperkt Fijnafstemming is alleen beschikbaar voor oudere modellen (niet GPT-4) | Beperkt Op maat gemaakt via snelle engineering en context | Sterk Goede ondersteuning voor finetuning en reinforcement learning |

| Schaalbaarheid | U moet uw eigen infrastructuur inrichten en beheren | OpenAI beheert alle infrastructuur | Anthropic beheert alle infrastructuur | Google Cloud beheert de infrastructuur |

Over het algemeen is Llama ideaal voor bedrijven die de voorkeur geven aan volledige controle, dataprivacy en aanpasbaarheid. GPT-4 is het meest geschikt voor bedrijven die de hoogste ruwe prestatie- en redeneercapaciteiten nodig hebben. Het kan complexe taken, met name creatieve en geavanceerde analyses, beter aan. Claude 3 is ideaal voor toepassingen waarbij veiligheid en verminderde bias van cruciaal belang zijn. Het produceert zelden schadelijke output. PaLM 2 is het meest geschikt voor bedrijven die diep geïntegreerd zijn in het Google Cloud-ecosysteem. Het zorgt voor een naadloze integratie met andere Google-tools.

Voordat u Llama implementeert, moet u eerst uw behoeften bepalen op basis van de specifieke use case. Heeft u het 70B-parametermodel nodig voor maximale kwaliteit of alleen het 8B-model voor basistaken?

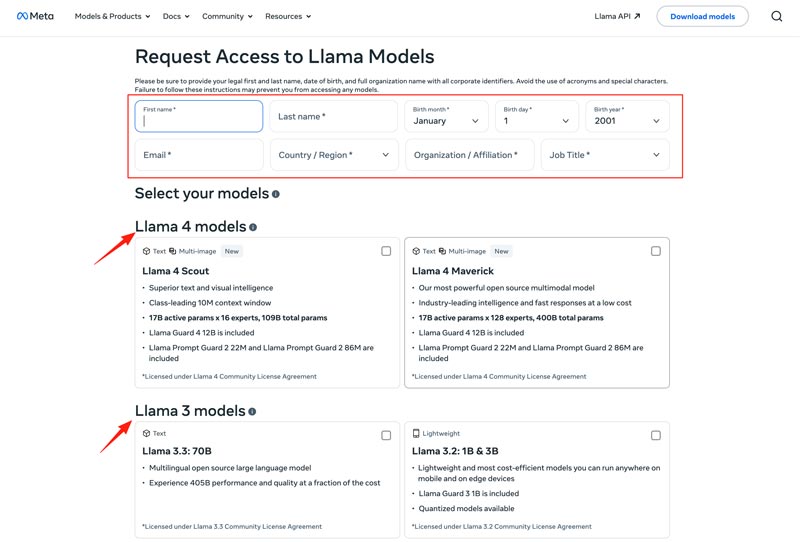

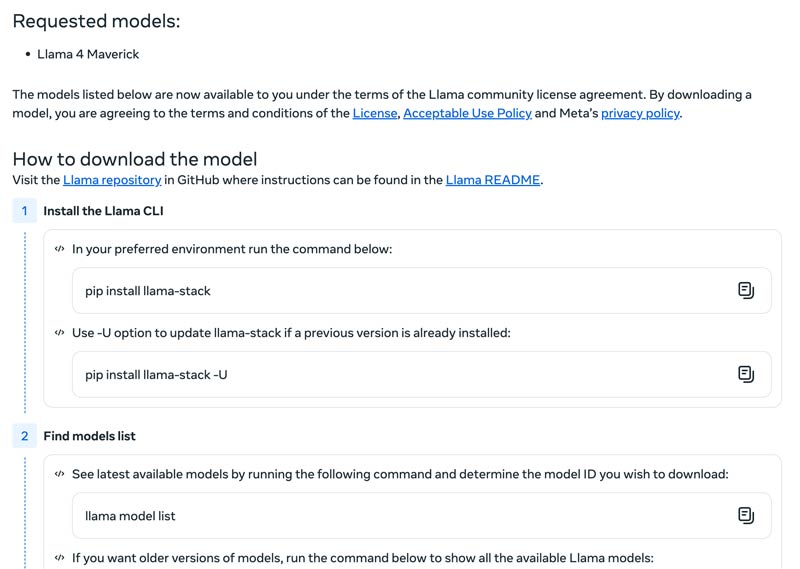

U moet uw implementatiemethode kiezen, zoals een lokale machine, een virtuele machine in de cloud of een beheerde service. Om Llama-modellen efficiënt te laten werken, is vaak een krachtige GPU vereist, vooral voor de grotere modellen. Daarna kunt u het juiste model downloaden van de Meta-website.

Klik op de Modellen downloaden knop om de Toegang aanvragen pagina. Geef de vereiste informatie en kies het gewenste Llama-model.

Klik op de Volgende knop om te lezen VoorwaardenControleer de Community-licentieovereenkomst zorgvuldig en klik vervolgens op de knop Accepteren en doorgaan knop. Volg de instructies op het scherm om het door u geselecteerde model te downloaden.

Je kunt een framework zoals Text Generation Inference gebruiken om een krachtige API-server te krijgen. Als je een chatinterface nodig hebt, implementeer dan een gebruikersinterface zoals Chatbot UI of NextChat. Gebruik daarna uw eigen data met frameworks om uw eigen gespecialiseerde model te creëren.

U moet weten hoe u uitdagingen kunt overwinnen om AI-modellen effectief te gebruiken.

• Complexiteit van de initiële installatie

U kunt de vooraf gebouwde tools en containers gebruiken. Voer modellen lokaal uit met één opdracht. U kunt ook overstappen op cloudgebaseerde platforms zonder lokale configuratie. Met Hugging Face kunt u demo's uitvoeren en maken met behulp van vooraf geconfigureerde omgevingen. Bovendien kunt u beginnen met llama.cpp om een gekwantiseerde versie van Llama uit te voeren.

• Resourcemanagement en kostenoptimalisatie

Grote modellen vereisen GPU's met veel geheugen, maar die zijn vaak schaars en duur.

Kwantisering is de meest effectieve techniek. U kunt bibliotheken gebruiken voor 4-bits kwantisering tijdens inferentie of fine-tuning. Op minder krachtige hardware kunt u llama.cpp gebruiken om modellen uit te voeren. Beide methoden kunnen het geheugengebruik effectief verminderen. Zorg er bovendien voor dat u het juiste model voor uw taken selecteert. Een kleiner, fine-tuned model kan kosteneffectiever zijn.

• Op de hoogte blijven van nieuwe releases

Er verschijnen wekelijks veel nieuwe modellen, technieken en bibliotheken. Het kan lastig zijn om op de hoogte te blijven.

Abonneer je op officiële blogs zoals Meta AI, Hugging Face en vLLM. Bovendien worden nieuwe finetuningtechnieken, toepassingen, efficiëntieverbeteringen, ervaringen, oplossingen en meer gedeeld op platforms zoals GitHub en Hugging Face. Zo kan je team verbeteringen integreren.

Mogelijk heeft u ook nodig:

Vraag 1. Is het toegestaan om de output van de Llama-modellen te gebruiken om andere LLM's te trainen?

Ja, Meta staat het toe om nieuwere versies (Llama 3.1 en later) van Llama's output te gebruiken om andere modellen te trainen. Je mag het toch zeker niet gebruiken om een product te creëren dat concurreert met Meta? Bovendien moet je je terdege bewust zijn van de juridische grenzen die de licentie van Meta stelt.

Vraag 2. Hebben lamamodellen beperkingen? Wat zijn de bijbehorende termen?

Ja, Llama-modellen hebben aanzienlijke beperkingen, die worden bepaald door hun licentiestructuur. Deze modellen zijn niet echt open source. In plaats daarvan worden ze vrijgegeven onder een propriëtaire licentie van Meta. Dit is bedoeld om de belangen van Meta te beschermen en concurrerende use cases te voorkomen.

Vraag 3. Wat zijn de meest voorkomende toepassingsgevallen van Llama?

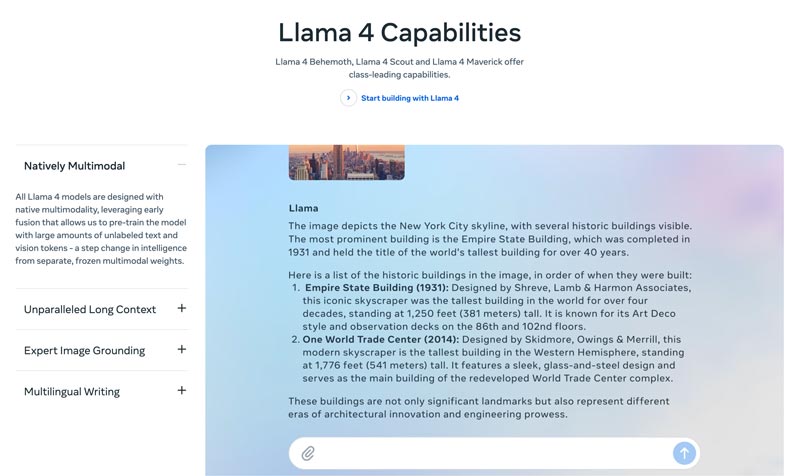

Dagelijkse toepassingen van Llama zijn onder andere het begrijpen van afbeeldingen en documenten, het beantwoorden van vragen, het genereren van afbeeldingen en tekst, het genereren en samenvatten van taal, taaltraining, conversatie-AI en meer. Llama kan uw vraag beantwoorden op basis van de afbeelding of de inhoud van het document dat u hebt aangeleverd. Bovendien kan het worden gebruikt om een chatbot of visuele assistent te creëren.

Vraag 4. Wat zijn de hardwarevereisten voor het gebruik van Llama-modellen?

De hardwarevereisten voor het draaien van Llama-modellen worden bepaald door drie belangrijke factoren: modelgrootte, kwantificering en gebruiksscenario. Voor de meeste ontwikkelaars is een RTX 4070/4080/4090 of een Mac met 16-36 GB Unified Memory een flexibele keuze voor Llama-modellen tot 70 GB. Voor GPU-gebaseerde werking is het VRAM van uw grafische kaart de belangrijkste factor. Zoals gezegd, selecteert u de juiste modelgrootte op basis van uw behoeften en kiest u vervolgens het kwantificeringsniveau dat op uw hardware kan draaien.

Vraag 5. Is Llama net zo goed als ChatGPT?

U kunt de bovenstaande tabel bekijken om hun belangrijkste factoren tussen Llama en ChatGPTLlama kan lokaal en offline worden gebruikt. Het biedt een veiligere gegevensbescherming. Bovendien is het Llama-model zelf gratis te gebruiken. ChatGPT heeft een gratis versie, maar voor de geavanceerde modellen en functies is een betaald abonnement vereist.

Conclusie

Lama is niet zomaar een model. Het wordt vaak gezien als een strategische verschuiving naar een toegankelijkere en aanpasbare AI-toekomst. In deze no-nonsense review vind je allerlei relevante informatie over de Llama AI-familie en kun je vervolgens ontdekken of het de hype waard is.

Vond je dit nuttig?

484 Stemmen