Strålkastare: AI-chatt, spel som Retro, platsväxlare, Roblox avblockerad

Strålkastare: AI-chatt, spel som Retro, platsväxlare, Roblox avblockerad

Sedan den banbrytande lanseringen av Llama 1 har de slutna, proprietära API:erna oåterkalleligen demokratiserats. Metas Llama-serie med öppen källkod (Large Language Model Meta AI) har omformat AI-landskapet. Den mycket kapabla Llama 3 och dess senaste Llama 4 gör denna modellfamilj till grunden för AI-innovation med öppen källkod.

Om du är förvirrad av otaliga AI-modeller, läs denna omfattande Lama-recensionDu kan lära dig vad Llama är, vad som gör Llama AI unik, dess övertygande affärsargument, dess konkurrenskraftiga ställning gentemot jättar som ChatGPT, en praktisk guide för företag och mer.

Innehållsförteckning

Lama hänvisar till en samling grundläggande stora språkmodeller utvecklade av Meta. Till skillnad från tidigare modeller som endast kan nås via API, släpps Llama-serien offentligt för forskning och kommersiellt bruk. En anpassad licens är utformad för att förhindra missbruk, och den gäller under specifika skalningsförhållanden. Den senaste versionen är Llama 4.

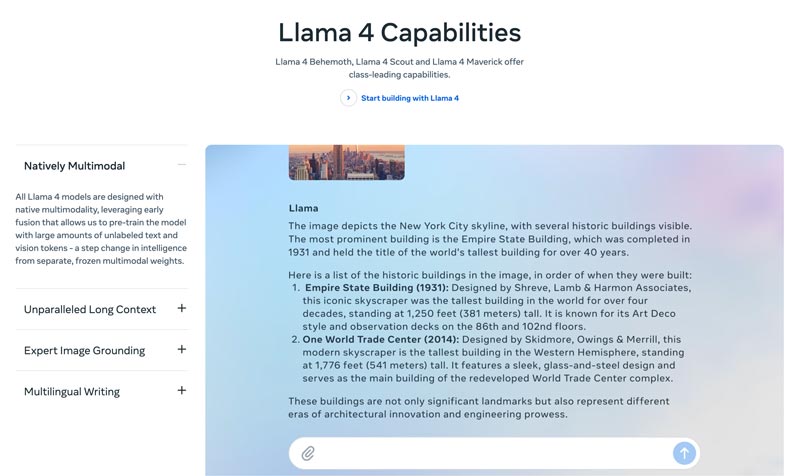

Lama 4 är den senaste versionen. Meta hävdar att det är den mest intelligenta, skalbara och bekväma versionen. Med mer avancerade resonemangs- och planeringsförmågor, multimodala funktioner och flerspråkiga skrivfunktioner kan Llama 4 vara det branschledande kontextfönstret. Det låter dig enkelt distribuera dina mest otroliga idéer med Llama API och Llama Stack. Den nuvarande Llama 4 möjliggör mer personliga upplevelser.

Lama 3 släpptes i april 2024. Jämfört med Llama 2 har Llama 3 flera förbättringar, inklusive förbättrad resonemang och kodning, förbättrad träningsdata, ett större kontextfönster och en effektivare tokenizer.

Lama 1 och 2: Det ursprungliga Llama släpptes i början av 2023, och Llama 2 släpptes i juli 2023. De markerade Metas direkta inträde i chatbot-arenan. Med en finjusterad variant, sedan Llama 2, levererar serien en hjälpsam och säker dialog. Llama 1/2 är huvudsakligen utvecklad för att utmana OpenAI:s ChatGPT och Googles Bard direkt.

Utvecklad av Meta för att omforma AI-landskapet, hög prestanda kommer inte att vara ditt problem. Llama är finjusterat på just ditt företags specifika data för att prestera bättre än större generiska modeller för specifika uppgifter. Potentialen för finjustering gör den lämplig för de flesta utvecklare och forskare.

Llamas unika karaktär ligger inte bara i dess prestanda. ekosystemet Llama har skapat kan vara en större fördel. Dess Hugging Face-ekosystem har utlöst en explosion av innovation. Tusentals finjusterade derivater erbjuds för olika tänkbara uppgifter.

Dessutom har Llama gett alla en juridikexamen i toppklass. demokratisering av AI är ytterligare en fördel som gör Llama unik. Llama AI-modeller är tillgängliga för alla forskare, utvecklare och startups att använda, förnya och bygga utan att betala API-avgifter eller be om tillstånd.

Strategisk fördel för företag. Med Llama äger du din AI-byggnad. Du behöver inte längre binda dig till en leverantörs prissättning, policyändringar eller API-utfasningar. Det undviker effektivt leverantörslåsning.

Affärsargumentet för Llama handlar inte bara om att använda en annan AI-modell. Det kan faktiskt innebära en fundamental förändring i hur ett företag hanterar AI.

I början använde många företag API-baserade tjänster, som OpenAI:s GPT-4. Det kan vara det enklaste alternativet, vilket möjliggör experiment med låga hinder och snabb prototypframställning. Denna AI-strategi har dock ersatts av en mer strategisk, långsiktig strategi, modeller baserade på öppen källkod, som Metas Llama. Fallet med Llama vilar på tre viktiga faktorer: kostnadsbesparingar, kontroll och anpassning samt datasäkerhet.

API-kostnaderna för många företag (som bearbetar miljontals frågor per dag) kan uppgå till miljoner årligen. Att driftsätta Llama innebär en övergång från driftskostnader (OpEx) till kapitalkostnader (CapEx). Det gör ROI tydlig vid hög volym.

Med Llama kan du skapa en unikt finjusterad AI som bäst passar ditt företag eller dina produkter. Du har också fullständig kontroll över din modells in- och utdata. Den blir en kärntillgång, inte en hyrd tjänst.

Myndigheter och finans har strikta krav på datastyrning. Llama kan driftsättas helt lokalt eller i en kompatibel VPC (Virtual Private Cloud). Det är ofta det enda lagliga sättet att utnyttja LLM-teknik. Dessutom innebär driftsättning av Llama inom en säker VPC att alla dina data är säkra och aldrig lämnar din brandvägg. Det eliminerar effektivt risken för dataexponering från tredje part.

Kort sagt handlar affärsnyttan för Llama om äganderättDu får tillbaka äganderätten till din konkurrensfördel, säkerheten för dina data och dina kostnader.

Metas Llama erbjuder ett nytt sätt för företag att använda AI. Denna kraftfulla AI-modell har ett brett utbud av tillämpningar, inklusive konversations-AI, bild- och textgenerering, språkutbildning, sammanfattningar och andra relaterade uppgifter. Genom att använda avancerade AI-funktioner kan Llama hjälpa företag att driva framgång.

• Kundtjänst och support

Avancerade chatbotar eller virtuella assistenter som drivs av Llama kan bättre förstå kundernas frågor, särskilt komplexa frågor, och ge korrekta, kontextmedvetna svar. Det är fördelaktigt att erbjuda kundsupport dygnet runt.

• Dataanalys och Business Intelligence

Llama kan hämta data från olika källor och fatta beslut som initialt krävde tekniska färdigheter. Det gör det möjligt för affärschefer och analytiker att få en SQL-fråga genom att ställa frågor. Modellen kan analysera text, bilder, diagram och annat innehåll för att ge en narrativ sammanfattning. Det hjälper till att snabbt identifiera nya trender, konkurrensinsikter och vanliga klagomål.

• Marknadsföring och innehållsautomatisering

Processen att producera högkvalitativt och SEO-optimerat innehåll är tidskrävande. Llama kan snabbt generera utkast eller hela artiklar med ett enkelt ämne och flera nyckelord. Mänskliga redaktörer kan sedan förfina dessa resultat. Modellen kan också automatisera skapandet av inlägg på sociala medier. Dessutom kan den hjälpa till att skriva övertygande ämnesrader för e-postmeddelanden och annonser.

• Programvaruutveckling

En kodspecifik Llama-modell kan fungera som en avancerad autokompletteringsmetod för att upprätthålla kodkvalitet, hantera äldre system och accelerera utvecklingscykler. Den kan hjälpa till att granska kod för potentiella buggar. Dessutom kan den automatiskt generera och uppdatera koddokumentation och API-referenser baserat på källkodskommentarer.

Det här avsnittet ger en jämförelse av Metas Llama-serie sida vid sida med andra ledande alternativ i tabellformat. Du kan jämföra dessa nyckelfaktorer för att hitta den som bäst passar dina specifika behov.

Det bör vara tydligt att dessa AI-modeller har sina egna styrkor och svagheter. Valet handlar inte om att hitta ett enda alternativ.

| AI-modeller | Metas LLaMA 4/3/2 | OpenAI:s GPT-4 | Antropikernas Claude 3 | Googles PaLM 2 |

| Licens | Öppen källkod, anpassad licens | Egenutvecklad | Egenutvecklad | Egenutvecklad |

| Tillträde | Ladda ner och host själv | Endast API Åtkomst via prenumeration | Endast API Åtkomst via användningsbaserad prissättning | Endast API Åtkomst via Googles Vertex AI |

| AI-modeller | Metas LLaMA 4/3/2 | OpenAI:s GPT-4 | Antropikernas Claude 3 | Googles PaLM 2 |

| Prestanda | Toppnivå Konkurrenskraftig med toppmodeller av AI Kräver finjustering för att matcha GPT-4-prestanda för specifika uppgifter Brister i att leverera engagerande, högkvalitativt kreativt innehåll | Branschledare Hantera komplexa resonemang, nyanser och kreativ problemlösning | Toppnivå Utmärkt på dataanalys, sofistikerad dialog och långsiktigt resonemang | Toppnivå Utmärkt på resonemang och flerspråkiga uppgifter |

| Kostnadsstruktur | Höga investeringar, låga driftskostnader Kostnadsskalor med modellstorlek och användningsvolym | Inga investeringar, höga driftskostnader initial kostnad, men betala per token för användning | Inga investeringar, höga driftskostnader Liknar OpenAI, betala per token | Inga investeringar, höga driftskostnader Betala per token på Vertex AI, med volymrabatter |

| Datasekretess och säkerhet | Maximal kontroll Data kommer aldrig att lämna din infrastruktur. Perfekt för hårt reglerade branscher. | In-/utdata bearbetas på OpenAIs servrar | Stark integritetspolicy, men data behandlas av Anthropic | Säkerhet i företagsklass Data bearbetas på Google Cloud Erbjuder VPC-kontroller och åtaganden om datalagring |

| Anpassning och kontroll | Fullständig kontroll Kan finjusteras helt på proprietär data | Begränsad Finjustering är endast tillgänglig för äldre modeller (inte GPT-4) | Begränsad Anpassad via snabb ingenjörskonst och kontext | Stark Bra stöd för finjustering och förstärkningsinlärning |

| Skalbarhet | Du behöver tillhandahålla och hantera din egen infrastruktur | OpenAI hanterar all infrastruktur | Anthropic hanterar all infrastruktur | Google Cloud hanterar infrastrukturen |

Generellt sett är Llama idealiskt för företag som föredrar fullständig kontroll, datasekretess och anpassningsmöjligheter. GPT-4 passar bäst för företag som kräver högsta möjliga råprestanda och resonemangsförmåga. Den kan bättre hantera komplexa uppgifter, särskilt kreativ och avancerad analys. Claude 3 är idealiskt för applikationer där säkerhet och minskad partiskhet är av största vikt. Den producerar sällan skadliga resultat. PaLM 2 är bäst för företag som är djupt integrerade i Google Cloud-ekosystemet. Den säkerställer en sömlös integration med andra Google-verktyg.

Innan du distribuerar Llama bör du först ta reda på dina behov utifrån det specifika användningsfallet. Behöver du 70B-parametermodellen för maximal kvalitet eller bara 8B-modellen för grundläggande uppgifter?

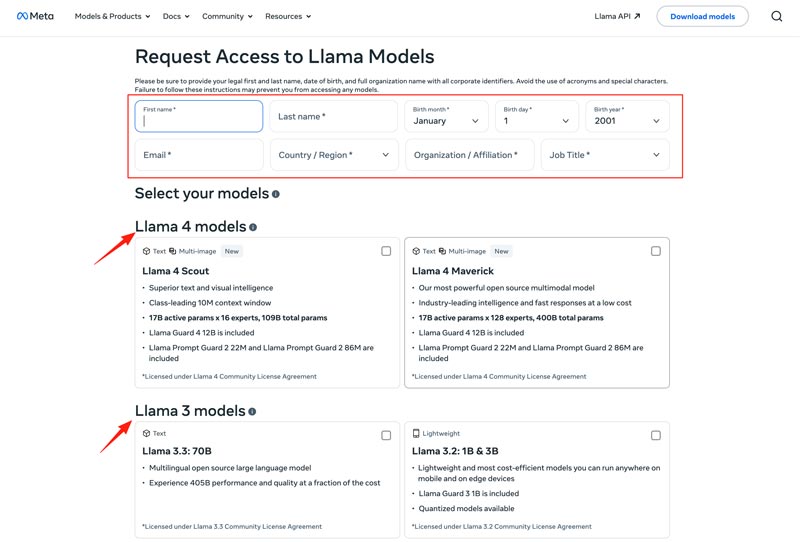

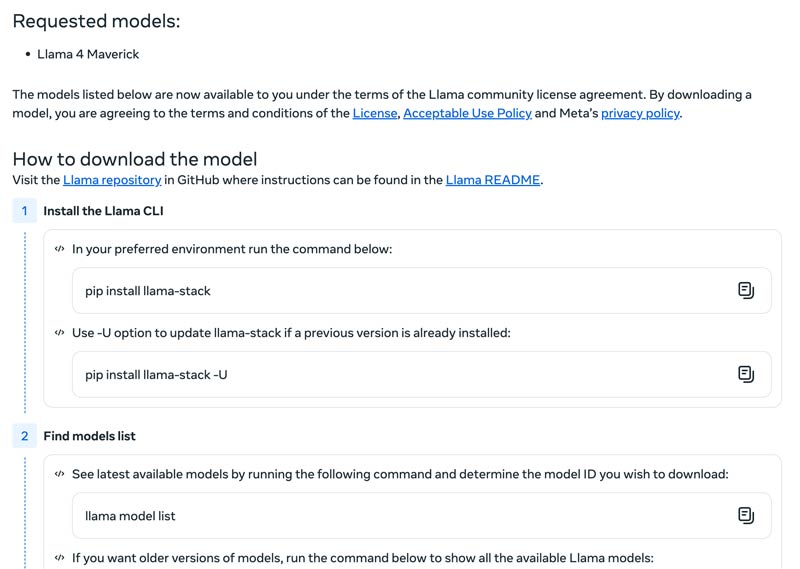

Du bör välja din distributionsmetod, till exempel en lokal maskin, molnbaserad virtuell maskin eller hanterad tjänst. Att köra Llama-modeller effektivt kräver ofta en kraftfull GPU, särskilt för de större modellerna. Därefter kan du ladda ner rätt modell från Metas webbplats.

Klicka på Ladda ner modeller knappen för att ange Begär åtkomst sida. Ange den information som krävs och välj en önskad lamamodell.

Klicka på Nästa knapp för att läsa VillkorDu bör noggrant kontrollera licensavtalet för communityt och sedan klicka på Acceptera och fortsätt knappen. Följ instruktionerna på skärmen för att ladda ner din valda modell.

Du kan använda ett ramverk som Text Generation Inference för att få en högpresterande API-server. Om du behöver ett chattgränssnitt, distribuera ett användargränssnitt som Chatbot UI eller NextChat. Använd sedan dina egna data med ramverk för att skapa din egen specialiserade modell.

Du bör veta hur man övervinner utmaningar för att använda AI-modeller effektivt.

• Komplexitet vid initial installation

Du kan använda dess förbyggda verktyg och containrar. Kör modeller lokalt med ett enda kommando. Du kan också använda molnbaserade plattformar utan någon lokal installation. Med Hugging Face kan du köra och skapa demonstrationer med hjälp av förkonfigurerade miljöer. Dessutom kan du börja med llama.cpp för att köra en kvantiserad version av Llama.

• Resurshantering och kostnadsoptimering

Stora modeller kräver GPU:er med högt minne, vilka ofta är sällsynta och dyra.

Kvantisering är den mest effektiva tekniken. Du kan använda bibliotek för 4-bitars kvantisering under inferens eller finjustering. På mindre kraftfull hårdvara, använd llama.cpp för att köra modeller. Båda metoderna kan effektivt minska minnesanvändningen. Se dessutom till att du väljer rätt modell för dina uppgifter. En mindre, finjusterad modell kan vara mer kostnadseffektiv.

• Hålla sig uppdaterad med nya utgåvor

Många nya modeller, tekniker och bibliotek släpps varje vecka. Det kan vara svårt att hålla sig uppdaterad.

Du bör prenumerera på officiella bloggar som Meta AI, Hugging Face och vLLM. Dessutom delas nya finjusteringstekniker, applikationer, effektivitetsvinster, erfarenheter, lösningar och mer på plattformar som GitHub och Hugging Face. Det gör det möjligt för ditt team att integrera förbättringar.

Du kan också behöva:

Fråga 1. Är det tillåtet att använda utdata från Llama-modellerna för att träna andra LLM:er?

Ja, Meta tillåter att använda nyare versioner (Llama 3.1 och senare) av Llamas utdata för att träna andra modeller. Du får väl inte använda den för att skapa en produkt som konkurrerar med Meta. Dessutom måste du vara mycket medveten om de juridiska gränser som Metas licens sätter.

Fråga 2. Har lamamodeller begränsningar? Vilka är de relaterade termerna?

Ja, Llama-modeller har betydande begränsningar, definierade av deras licensstruktur. Dessa modeller är inte helt öppen källkod. Istället släpps de under en proprietär licens från Meta. Det är för att skydda Metas intressen och förhindra konkurrensutsatta användningsfall.

Fråga 3. Vilka är de vanligaste användningsområdena för Llama?

Vardagliga användningsområden för Llama inkluderar bild- och dokumentförståelse, svar på frågor, generering av bilder och text, språkgenerering och sammanfattning, språkträning, AI för konversationer och mer. Llama kan svara på din fråga baserat på bild- eller dokumentinnehållet du tillhandahåller. Dessutom kan det användas för att skapa en chatbot eller en visuell assistent.

Fråga 4. Vilka är hårdvarukraven för att använda Llama-modeller?

Hårdvarukraven för att köra Llama-modeller bestäms av tre nyckelfaktorer: modellstorlek, kvantisering och användningsfall. För de flesta utvecklare är ett RTX 4070/4080/4090 eller en Mac med 16–36 GB Unified Memory ett flexibelt val för Llama-modeller upp till 70 MB. För GPU-baserad drift är den viktigaste faktorn grafikkortets VRAM. Som nämnts, välj rätt modellstorlek baserat på dina behov och välj sedan den kvantiseringsnivå som kan köras på din hårdvara.

Fråga 5. Är Llama lika bra som ChatGPT?

Du kan kontrollera tabellen ovan för att jämföra deras nyckelfaktorer mellan Llama och ChatGPTLlama kan köras lokalt och offline. Det erbjuder säkrare dataskydd. Dessutom är själva Llama-modellen gratis att använda. ChatGPT har en gratisversion, men dess avancerade modeller och funktioner kräver en betald plan.

Slutsats

Lama är inte bara en modell till. Det ses ofta som ett strategiskt skifte mot en mer tillgänglig och anpassningsbar AI-framtid. Du kan lära dig diverse relaterad information om Llama AI-familjen i den här praktiska recensionen och sedan ta reda på om den är värd all hype.

Tyckte du att det här var användbart?

484 Röster