أبرز ما في الأمر: دردشة الذكاء الاصطناعي ، ألعاب مثل ريترو ، تغيير الموقع ، روبلوكس غير محظورة

أبرز ما في الأمر: دردشة الذكاء الاصطناعي ، ألعاب مثل ريترو ، تغيير الموقع ، روبلوكس غير محظورة

منذ الإصدار الرائد لـ Llama 1، أصبحت واجهات برمجة التطبيقات المغلقة والملكية متاحة للجميع بشكل لا رجعة فيه. وقد أعادت سلسلة Llama (نموذج لغة كبيرة Meta AI) مفتوحة المصدر من Meta تشكيل مشهد الذكاء الاصطناعي. ويجعل Llama 3 عالي الكفاءة، وأحدث إصداراته Llama 4، هذه السلسلة من النماذج أساسًا لابتكار الذكاء الاصطناعي مفتوح المصدر.

إذا كنت تشعر بالحيرة بسبب عدد لا يحصى من نماذج الذكاء الاصطناعي، فاقرأ هذه المراجعة الشاملة لـLlama. يمكنك أن تتعرّف على ما هو Llama، وما الذي يجعل Llama AI فريدًا، وحجته المقنعة في مجال الأعمال، وموقعه التنافسي أمام عمالقة مثل ChatGPT، ودليلًا عمليًا للمؤسسات، وغير ذلك الكثير.

جدول المحتويات

يشير Llama إلى مجموعة من نماذج اللغة الكبيرة الأساسية التي طورتها شركة ميتا. على عكس النماذج السابقة التي لا يمكن الوصول إليها إلا عبر واجهة برمجة التطبيقات (API)، تم إصدار سلسلة Llama بشكل علني لأغراض البحث والاستخدام التجاري. وبالفعل، تم تصميم ترخيص مخصص لمنع إساءة الاستخدام، وينطبق ذلك في ظل شروط معينة تتعلق بحجم الاستخدام. أحدث إصدار هو Llama 4.

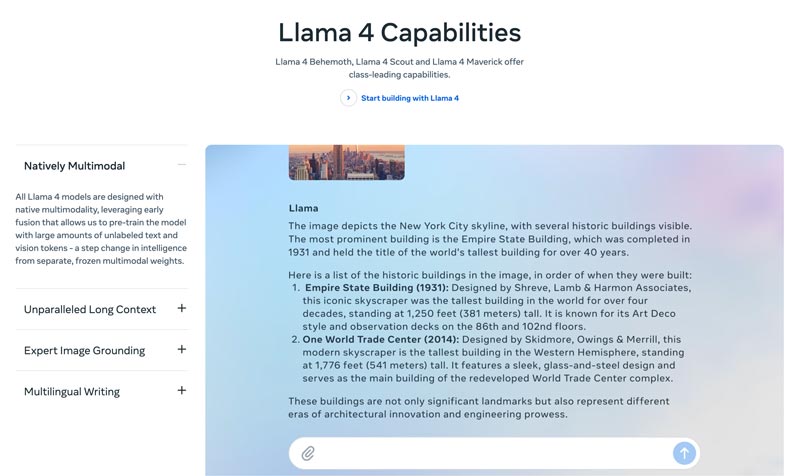

يعد Llama 4 أحدث إصدار. وتزعم ميتا أنه النسخة الأكثر ذكاءً وقابلية للتوسع وملاءمة للاستخدام حتى الآن. وبفضل قدراته الأكثر تقدمًا في الاستدلال والتخطيط، وإمكاناته متعددة الوسائط، ووظائفه في الكتابة متعددة اللغات، يمكن أن يكون Llama 4 صاحب نافذة السياق الرائدة في الصناعة. فهو يتيح لك نشر أفكارك المذهلة بسهولة عبر واجهة برمجة تطبيقات Llama وبيئة Llama Stack. يوفّر Llama 4 الحالي تجارب أكثر تخصيصًا.

تم إصدار Llama 3 في أبريل 2024. مقارنةً بـ Llama 2، يتضمن Llama 3 عدة تحسينات، بما في ذلك تعزيز قدرات الاستدلال والبرمجة، وتحسين بيانات التدريب، وتوسيع نافذة السياق، ومجزِّئ (tokenizer) أكثر كفاءة.

Llama 1 & 2: تم إصدار النسخة الأصلية من Llama في أوائل عام 2023، وتم إصدار Llama 2 في يوليو 2023. وقد شكّل ذلك دخول ميتا المباشر إلى ساحة روبوتات الدردشة. ومع النسخة المضبوطة بدقة، قدّمت السلسلة منذ Llama 2 حوارات مفيدة وآمنة. تم تطوير Llama 1/2 بشكل أساسي لمنافسة ChatGPT من OpenAI وBard من Google مباشرة.

طُوِّر Llama بواسطة ميتا لإعادة تشكيل مشهد الذكاء الاصطناعي، لذا فإن الأداء العالي لن يكون مصدر قلق لك. يتم ضبط Llama بدقة اعتمادًا على بيانات شركتك الخاصة ليتفوق على النماذج العامة الأكبر حجمًا في المهام المتخصصة. إن إمكانية الضبط الدقيق تجعل منه خيارًا مناسبًا لمعظم المطورين والباحثين.

لا تكمن فرادة Llama في أدائه فحسب، بل في النظام البيئي الذي أطلقه أيضًا، والذي يمكن أن يكون ميزة أكبر. فقد أشعل نظامه البيئي على منصة Hugging Face موجة هائلة من الابتكار. تُقدَّم آلاف النماذج المشتقة المضبوطة بدقة لمختلف المهام المتصوَّرة.

علاوة على ذلك، وضع Llama نموذجًا لغويًا كبيرًا من الدرجة الأولى في متناول الجميع. إن دمقرطة الذكاء الاصطناعي ميزة أخرى تجعل Llama فريدًا. نماذج Llama AI متاحة لجميع الباحثين والمطورين والشركات الناشئة للاستخدام والابتكار والبناء دون دفع رسوم واجهة برمجة التطبيقات أو طلب إذن.

ميزة استراتيجية للأعمال. يتيح لك Llama امتلاك عملية بناء حلول الذكاء الاصطناعي بنفسك. لم تَعُد مضطرًّا للارتباط بأسعار مورِّد معين أو تغييرات سياساته أو استغنائه عن واجهات برمجة التطبيقات. وهذا يتجنب الارتهان لمورّد واحد بشكل فعّال.

لا تقتصر جدوى لاما على استخدام نموذج ذكاء اصطناعي مختلف فحسب، بل قد تُحدث تغييرًا جذريًا في طريقة تعامل الشركة مع الذكاء الاصطناعي.

في البدايات، اعتمدت العديد من الشركات على خدمات قائمة على واجهات برمجة التطبيقات، مثل GPT-4 من OpenAI. قد يكون ذلك الخيار الأكثر ملاءمة، إذ يتيح تجارب أولية منخفضة العوائق ونماذج أولية سريعة. ومع ذلك، تم استبدال هذه الاستراتيجية في الذكاء الاصطناعي بنهج أكثر استراتيجية وطويل الأمد، يعتمد على نماذج مفتوحة المصدر أساسية مثل Llama من ميتا. وترتكز قضية Llama على ثلاثة عوامل رئيسية: توفـير التكاليف، والتحكّم والتخصيص، وأمن البيانات.

قد تصل تكاليف واجهة برمجة التطبيقات (API) للعديد من الشركات (معالجة ملايين الاستعلامات يوميًا) إلى ملايين الدولارات سنويًا. يُعدّ نشر Llama تحولًا من النفقات التشغيلية (OpEx) إلى النفقات الرأسمالية (CapEx). وهذا يُظهر بوضوح عائد الاستثمار عند حجم العمل الكبير.

يتيح لك لاما إنشاء ذكاء اصطناعي مُعدّل بدقة فائقة ليناسب أعمالك أو منتجاتك على النحو الأمثل. كما يمكنك التحكم الكامل في مدخلات ومخرجات نموذجك. يصبح لاما أصلًا أساسيًا، وليس خدمة مستأجرة.

لدى الحكومة والقطاع المالي متطلبات صارمة لحوكمة البيانات. يمكن نشر Llama بالكامل محليًا أو عبر سحابة خاصة افتراضية (VPC) متوافقة. غالبًا ما تكون هذه هي الطريقة القانونية الوحيدة للاستفادة من تقنية LLM. علاوة على ذلك، فإن نشر Llama ضمن سحابة خاصة افتراضية آمنة يعني أن جميع بياناتك محمية ولن تخرج من جدار الحماية الخاص بك. هذا يُجنّبك خطر كشف بياناتك لأي طرف ثالث.

باختصار، تتمحور جدوى Llama للأعمال حول الملكية. إذ يُعاد إليك امتلاك ميزتك التنافسية، وأمن بياناتك، وتكاليفك.

يوفّر Llama من ميتا طريقة جديدة للشركات لاستخدام الذكاء الاصطناعي. فهذا النموذج القوي لديه مجموعة واسعة من الاستخدامات، بما في ذلك الذكاء الاصطناعي للمحادثة، وتوليد الصور والنصوص، وتدريب اللغات، والتلخيص، وغيرها من المهام ذات الصلة. من خلال الاستفادة من قدرات الذكاء الاصطناعي المتقدمة، يمكن أن يساعد Llama الشركات على تحقيق النجاح.

• خدمة العملاء والدعم

تستطيع روبوتات الدردشة المتقدمة أو المساعدون الافتراضيون المدعومون من لاما فهم أسئلة العملاء بشكل أفضل، وخاصةً الاستفسارات المعقدة، وتقديم إجابات دقيقة وواضحة. ومن المفيد توفير دعم عملاء على مدار الساعة طوال أيام الأسبوع.

• تحليل البيانات وذكاء الأعمال

يستطيع لاما جمع البيانات من مصادر متنوعة واتخاذ قرارات تتطلب في البداية مهارات تقنية. يتيح لمديري الأعمال والمحللين الحصول على استعلام SQL عن طريق طرح الأسئلة. يستطيع النموذج تحليل النصوص والصور والرسوم البيانية وغيرها من المحتويات لتقديم ملخص سردي. يساعد ذلك على تحديد الاتجاهات الناشئة والرؤى التنافسية والشكاوى الشائعة بسرعة.

• التسويق وأتمتة المحتوى

إن عملية إنتاج محتوى عالي الجودة ومُحسّن لمحركات البحث تستغرق وقتًا طويلاً. يستطيع لاما إنشاء مسودات أو مقالات كاملة بسرعة بموضوع بسيط وعدة كلمات مفتاحية. ثم يقوم المحررون بتحسين هذه النتائج. كما يُمكّن النموذج من أتمتة إنشاء منشورات وسائل التواصل الاجتماعي. علاوة على ذلك، يُمكنه المساعدة في كتابة عناوين جذابة لرسائل البريد الإلكتروني والإعلانات.

• تطوير البرمجيات

يمكن لنموذج لاما الخاص بالكود أن يعمل كإكمال تلقائي متقدم للحفاظ على جودة الكود، وإدارة الأنظمة القديمة، وتسريع دورات التطوير. كما يُساعد في مراجعة الكود بحثًا عن أي أخطاء محتملة. علاوة على ذلك، يُمكنه إنشاء وتحديث وثائق الكود ومراجع واجهة برمجة التطبيقات (API) تلقائيًا بناءً على تعليقات الكود المصدر.

يقدم هذا القسم مقارنةً متوازية لسلسلة ميتا لاما مع بدائل رائدة أخرى في شكل جدول. يمكنك مقارنة هذه العوامل الرئيسية لاختيار الأنسب لاحتياجاتك الخاصة.

يجب أن يكون واضحًا أن نماذج الذكاء الاصطناعي هذه لها نقاط قوة ونقاط ضعف. فالاختيار لا يقتصر على إيجاد خيار واحد.

| نماذج الذكاء الاصطناعي | ميتا LLaMA 4/3/2 | GPT-4 من OpenAI | أنثروبيك كلود 3 | PaLM 2 من Google |

| رخصة | ترخيص مفتوح المصدر ومخصص | الملكية | الملكية | الملكية |

| وصول | التنزيل والاستضافة الذاتية | واجهة برمجة التطبيقات فقط الوصول عبر الاشتراك | واجهة برمجة التطبيقات فقط الوصول عبر التسعير القائم على الاستخدام | واجهة برمجة التطبيقات فقط الوصول عبر Vertex AI من Google |

| نماذج الذكاء الاصطناعي | ميتا LLaMA 4/3/2 | GPT-4 من OpenAI | أنثروبيك كلود 3 | PaLM 2 من Google |

| أداء | من الدرجة الأولى القدرة على المنافسة مع أفضل نماذج الذكاء الاصطناعي تتطلب ضبطًا دقيقًا لمطابقة أداء GPT-4 في مهام محددة عدم القدرة على تقديم محتوى إبداعي جذاب وعالي الجودة | رائد الصناعة التعامل مع التفكير المعقد والفروق الدقيقة وحل المشكلات الإبداعية | من الدرجة الأولى ممتاز في تحليل البيانات والحوار المتطور والتفكير في السياق الطويل | من الدرجة الأولى ممتاز في التفكير والمهام المتعددة اللغات |

| هيكل التكلفة | رأس مال مرتفع، ونفقات تشغيل منخفضة مقاييس التكلفة مع حجم النموذج وحجم الاستخدام | لا يوجد رأسمال، لا يوجد رأسمال تشغيلي مرتفع التكلفة الأولية، ولكن الدفع مقابل كل رمز مقابل الاستخدام | لا يوجد رأسمال، ونفقات تشغيلية عالية على غرار OpenAI، الدفع لكل رمز مميز | لا يوجد رأسمال، ونفقات تشغيلية عالية الدفع لكل رمز مميز على Vertex AI، مع خصومات على الحجم |

| خصوصية البيانات والأمان | الحد الأقصى من التحكم لن تترك البيانات البنية التحتية الخاصة بك أبدًا، مثالية للصناعات الخاضعة للتنظيم الشديد | تتم معالجة بيانات الإدخال/الإخراج على خوادم OpenAI | سياسة خصوصية قوية، ولكن تتم معالجة البيانات بواسطة Anthropic | أمان على مستوى المؤسسة تتم معالجة البيانات على Google Cloud وتوفر عناصر تحكم VPC والتزامات إقامة البيانات |

| التخصيص والتحكم | السيطرة الكاملة يمكن ضبطها بالكامل على البيانات الملكية | محدود الضبط الدقيق متاح فقط للطرز القديمة (وليس GPT-4) | محدود مخصصة من خلال الهندسة السريعة والسياق | قوي دعم جيد للضبط الدقيق والتعلم المعزز |

| قابلية التوسع | تحتاج إلى توفير وإدارة البنية التحتية الخاصة بك | تدير OpenAI جميع البنية التحتية | تدير شركة أنثروبيك جميع البنية التحتية | تدير Google Cloud البنية التحتية |

بشكل عام، يُعدّ Llama مثاليًا للشركات التي تُفضّل التحكّم الكامل وخصوصية البيانات وقابلية التخصيص. يُعدّ GPT-4 الأنسب للمؤسسات التي تتطلب أعلى أداء خام وقدرات استدلالية. فهو يُحسّن أداء المهام المعقدة، وخاصةً التحليلات الإبداعية والمتقدمة. يُعدّ Claude 3 مثاليًا للتطبيقات التي تُعدّ فيها السلامة وتقليل التحيز أمرًا بالغ الأهمية. ونادرًا ما يُنتج نتائج ضارة. يُعدّ PaLM 2 الأنسب للشركات المُدمجة بعمق في منظومة Google Cloud، حيث يضمن تكاملًا سلسًا مع أدوات Google الأخرى.

قبل نشر Llama، عليك أولاً تحديد احتياجاتك وفقًا لحالة الاستخدام المحددة. هل تحتاج إلى نموذج 70B لأقصى جودة أم نموذج 8B فقط للمهام الأساسية؟

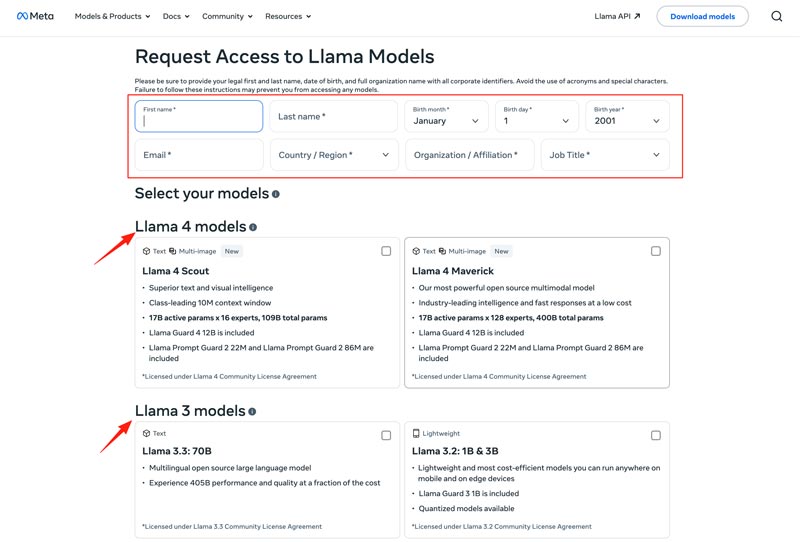

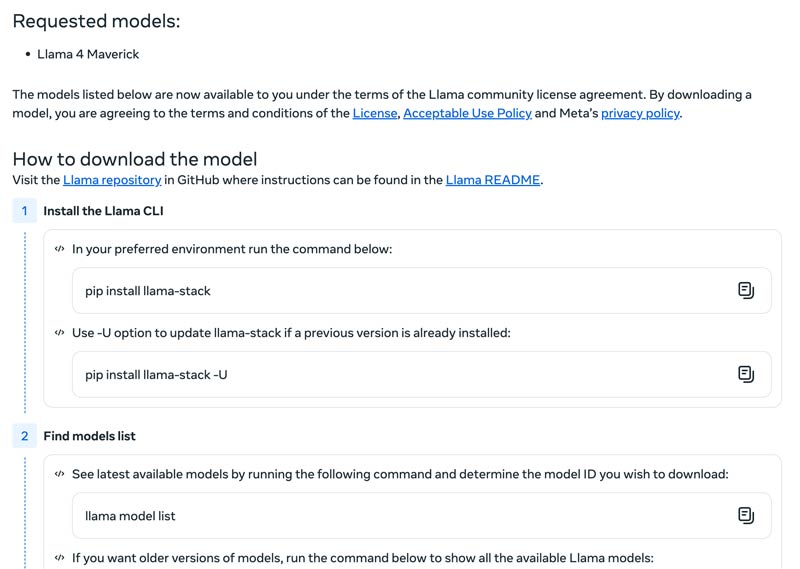

يجب عليك اختيار طريقة النشر المناسبة، مثل جهاز محلي، أو جهاز افتراضي سحابي، أو خدمة مُدارة. يتطلب تشغيل نماذج Llama بكفاءة وحدة معالجة رسومات قوية، خاصةً للنماذج الأكبر حجمًا. بعد ذلك، يمكنك تنزيل النموذج المناسب من موقع Meta الإلكتروني.

انقر على زر Download Models (تنزيل النماذج) للانتقال إلى صفحة Request Access (طلب الوصول). قدم المعلومات المطلوبة واختر نموذج Llama المرغوب.

انقر على زر Next (التالي) لقراءة Terms and Conditions (الشروط والأحكام). يجب أن تراجع اتفاقية الترخيص المجتمعية بعناية، ثم تنقر على زر Accept and Continue (قبول ومتابعة). اتبع التعليمات الظاهرة على الشاشة لتنزيل النموذج الذي اخترته.

يمكنك استخدام إطار عمل مثل Text Generation Inference للحصول على خادم واجهة برمجة تطبيقات عالي الأداء. إذا كنت بحاجة إلى واجهة دردشة، فقم بنشر واجهة مثل Chatbot UI أو NextChat. بعد ذلك، استخدم بياناتك الخاصة مع الأطر المتاحة لإنشاء نموذجك المتخصص.

يجب أن تعرف كيفية التغلب على التحديات لاستخدام نماذج الذكاء الاصطناعي بشكل فعال.

• تعقيد الإعداد الأولي

يمكنك استخدام أدواته وحاوياته المُعدّة مسبقًا. شغّل النماذج محليًا بأمر واحد. يمكنك أيضًا الانتقال إلى المنصات السحابية دون الحاجة إلى إعداد محلي. يتيح لك Hugging Face تشغيل وإنشاء عروض توضيحية باستخدام بيئات مُعدّة مسبقًا. علاوة على ذلك، يمكنك البدء باستخدام llama.cpp لتشغيل إصدار مُكمّم من Llama.

• إدارة الموارد وتحسين التكاليف

تتطلب النماذج الكبيرة وحدات معالجة رسومية ذات ذاكرة عالية، والتي غالبًا ما تكون نادرة ومكلفة.

التكميم هو الأسلوب الأكثر فعالية. يمكنك استخدام المكتبات لتكميم 4 بت أثناء الاستدلال أو الضبط الدقيق. على الأجهزة الأقل قوة، استخدم llama.cpp لتشغيل النماذج. كلتا الطريقتين تُقللان استخدام الذاكرة بفعالية. بالإضافة إلى ذلك، تأكد من اختيار النموذج المناسب لمهامك. فالنموذج الأصغر والأكثر ضبطًا يكون أكثر فعالية من حيث التكلفة.

• مواكبة الإصدارات الجديدة

يتم إصدار العديد من النماذج والتقنيات والمكتبات الجديدة أسبوعيًا. قد يكون من الصعب مواكبة التطورات.

يُنصح بالاشتراك في المدونات الرسمية مثل Meta AI وHugging Face وvLLM. علاوةً على ذلك، تُشارك تقنيات الضبط الدقيق الجديدة، والتطبيقات، ومكاسب الكفاءة، والتجارب، والحلول، وغيرها على منصات مثل GitHub وHugging Face. هذا يُمكّن فريقك من دمج التحسينات.

قد تحتاج أيضًا إلى:

السؤال 1. هل يُسمح باستخدام مخرجات نماذج Llama لتدريب نماذج لغوية كبيرة أخرى؟

نعم، يسمح ميتا باستخدام إصدارات أحدث (لاما 3.1 وما بعده) من مخرجات لاما لتدريب نماذج أخرى. ولكن، لا يُسمح لك باستخدامها لإنشاء منتج ينافس ميتا. علاوة على ذلك، يجب أن تكون على دراية تامة بالحدود القانونية التي يفرضها ترخيص ميتا.

السؤال 2. هل لدى نماذج Llama قيود؟ وما هي الشروط ذات الصلة؟

نعم، تخضع نماذج اللاما لقيود كبيرة، تُحددها بنية ترخيصها. هذه النماذج ليست مفتوحة المصدر تمامًا، بل تُصدر بموجب ترخيص خاص من ميتا، وذلك لحماية مصالح ميتا ومنع حالات الاستخدام التنافسية.

السؤال 3. ما هي حالات الاستخدام الشائعة لـ Llama؟

تشمل استخدامات لاما اليومية فهم الصور والمستندات، والإجابة على الأسئلة، وتوليد الصور والنصوص، وتوليد اللغة وتلخيصها، والتدريب اللغوي، والذكاء الاصطناعي للمحادثات، وغيرها. يجيب لاما على سؤالك بناءً على محتوى الصورة أو المستند الذي زودته. كما يمكن استخدامه لإنشاء روبوت محادثة أو مساعد بصري.

السؤال 4. ما هي متطلبات العتاد (الهاردوير) لاستخدام نماذج Llama؟

تُحدد متطلبات الأجهزة لتشغيل نماذج Llama بثلاثة عوامل رئيسية: حجم النموذج، والكمية، وحالة الاستخدام. بالنسبة لمعظم المطورين، يُعدّ استخدام بطاقة RTX 4070/4080/4090 أو جهاز Mac مزود بذاكرة موحدة بسعة 16-36 جيجابايت خيارًا مرنًا لنماذج Llama التي تصل إلى 70 جيجابايت. أما بالنسبة للتشغيل المعتمد على وحدة معالجة الرسومات، فإن العامل الأكثر أهمية هو ذاكرة الفيديو (VRAM) لبطاقة الرسومات. كما ذكرنا، اختر حجم النموذج المناسب بناءً على احتياجاتك، ثم اختر مستوى الكمية الذي يُمكن تشغيله على جهازك.

السؤال 5. هل Llama جيد مثل ChatGPT؟

يمكنك مراجعة الجدول أعلاه لمقارنة العوامل الرئيسية بين Llama وChatGPT. يمكن تشغيل Llama محليًا وفي وضع عدم الاتصال، ويوفر حماية أكثر أمانًا للبيانات. علاوة على ذلك، فإن نموذج Llama نفسه مجاني الاستخدام. يحتوي ChatGPT على نسخة مجانية، ولكن نماذجه وميزاته المتقدمة تتطلب خطة مدفوعة.

استنتاج

لا يُعد Llama مجرد نموذج آخر؛ بل يُنظر إليه غالبًا كتحوّل استراتيجي نحو مستقبل للذكاء الاصطناعي أكثر إتاحة وقابلية للتخصيص. يمكنك الاطلاع على مختلف المعلومات ذات الصلة بعائلة Llama AI في هذه المراجعة الواضحة لمعرفة ما إذا كان يستحق هذه الضجة أم لا.

هل وجدت هذا مفيدا؟

484 تصويتًا