Destacado: chat con IA , juegos como Retro , cambiador de ubicación , Roblox desbloqueado

Destacado: chat con IA , juegos como Retro , cambiador de ubicación , Roblox desbloqueado

Desde el revolucionario lanzamiento de Llama 1, las API cerradas y propietarias se democratizaron irrevocablemente. La serie Llama (Large Language Model Meta AI) de código abierto de Meta ha transformado el panorama de la IA. El potente Llama 3 y su reciente lanzamiento, Llama 4, convierten a esta familia de modelos en la base de la innovación en IA de código abierto.

Si te sientes confundido por la infinidad de modelos de IA, lee este completo análisis de Llama. Podrás aprender qué es Llama, qué hace que Llama AI sea único, su sólido caso de uso empresarial, su posición competitiva frente a gigantes como ChatGPT, una guía práctica para empresas y mucho más.

Tabla de contenidos

Llama se refiere a una colección de modelos de lenguaje grandes fundamentales desarrollados por Meta. A diferencia de modelos anteriores a los que solo se podía acceder mediante API, la serie Llama se ha publicado de forma abierta para uso tanto de investigación como comercial. De hecho, se ha diseñado una licencia personalizada para evitar usos indebidos, y se aplica bajo determinadas condiciones de escala. La versión más reciente es Llama 4.

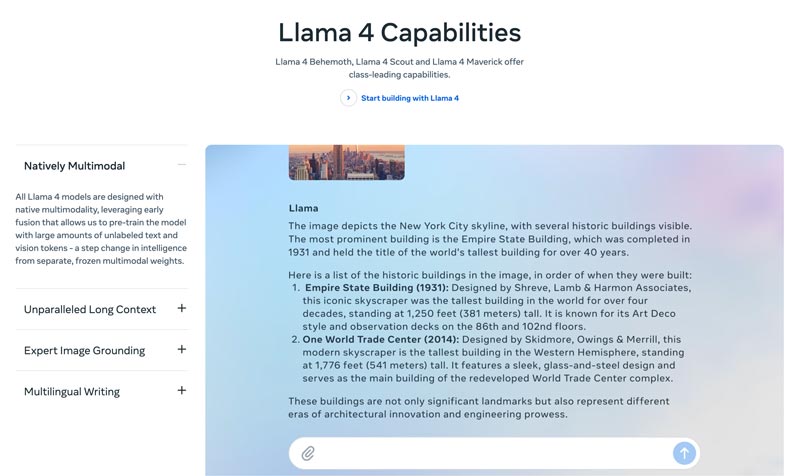

Llama 4 es la última versión. Meta afirma que es la versión más inteligente, escalable y práctica. Con capacidades más avanzadas de razonamiento y planificación, funciones multimodales y capacidades de redacción multilingüe, Llama 4 puede ofrecer una ventana de contexto líder en la industria. Te permite desplegar fácilmente tus ideas más increíbles con la API de Llama y Llama Stack. El Llama 4 actual permite experiencias más personalizadas.

Llama 3 se lanzó en abril de 2024. En comparación con Llama 2, Llama 3 presenta varias mejoras, como un razonamiento y programación reforzados, datos de entrenamiento mejorados, una ventana de contexto mayor y un tokenizador más eficiente.

Llama 1 y 2: El Llama original se lanzó a principios de 2023 y Llama 2 se lanzó en julio de 2023. Supusieron la entrada directa de Meta en el terreno de los chatbots. Con una variante ajustada con fine-tuning, desde Llama 2 la serie ofrece un diálogo útil y seguro. Llama 1/2 se desarrolló principalmente para competir directamente con ChatGPT de OpenAI y Bard de Google.

Desarrollado por Meta para remodelar el panorama de la IA, el alto rendimiento no será tu preocupación. Llama se ajusta mediante fine-tuning con los datos específicos de tu empresa para superar a modelos genéricos de mayor tamaño en tareas concretas. Su potencial para el fine-tuning lo hace adecuado para la mayoría de desarrolladores e investigadores.

La singularidad de Llama no reside solo en su rendimiento. El ecosistema que ha generado Llama puede ser una ventaja aún mayor. Su ecosistema en Hugging Face ha desencadenado una explosión de innovación. Se ofrecen miles de derivados ajustados con fine-tuning para todo tipo de tareas imaginables.

Además, Llama ha puesto un LLM de primer nivel en las manos de todo el mundo. La democratización de la IA es otro beneficio que hace que Llama sea único. Los modelos de Llama AI están disponibles para que todos los investigadores, desarrolladores y startups los utilicen, innoven y creen sin pagar tarifas de API ni pedir permiso.

Ventaja estratégica para las empresas. Llama te permite que la construcción de tu IA sea de tu propiedad. Ya no necesitas quedar atado a los precios de un proveedor, a cambios de políticas o a la retirada de APIs. Eso evita de forma efectiva la dependencia de un proveedor.

El argumento comercial para Llama no se limita a usar un modelo de IA diferente. De hecho, puede suponer un cambio fundamental en la forma en que una empresa aborda la IA.

En los primeros tiempos, muchas empresas adoptaron servicios basados en API, como GPT-4 de OpenAI. Esa puede ser la opción más cómoda, al permitir una experimentación con pocas barreras y una creación rápida de prototipos. Sin embargo, esta estrategia de IA ha sido reemplazada por un enfoque más estratégico y a largo plazo: los modelos fundacionales de código abierto, como Llama de Meta. El caso de Llama se apoya en tres factores clave: ahorro de costes, control y personalización, y seguridad de los datos.

Los costos de API para muchas empresas (que procesan millones de consultas al día) pueden ascender a millones anuales. Implementar Llama implica una transición de gastos operativos (OpEx) a gastos de capital (CapEx). Esto permite un retorno de la inversión (ROI) claro con un alto volumen.

Llama te permite crear una IA optimizada que se adapta perfectamente a tu negocio o productos. Además, tienes control total sobre las entradas y salidas de tu modelo. Se convierte en un activo fundamental, no en un servicio alquilado.

Los gobiernos y las finanzas tienen estrictos requisitos de gobernanza de datos. Llama puede implementarse completamente localmente o en una VPC (Nube Privada Virtual) compatible. Esta suele ser la única forma legal de aprovechar la tecnología LLM. Además, implementar Llama en una VPC segura significa que todos sus datos están protegidos y nunca salen de su firewall. Esto elimina eficazmente el riesgo de exposición de datos de terceros.

En una palabra, el caso empresarial de Llama tiene que ver con la propiedad. Se te devuelve la propiedad de tu ventaja competitiva, la seguridad de tus datos y tus costes.

Llama de Meta ofrece una nueva forma para que las empresas utilicen la IA. Este potente modelo de IA tiene una amplia gama de aplicaciones, como IA conversacional, generación de imágenes y texto, entrenamiento de idiomas, resumen y otras tareas relacionadas. Mediante el uso de capacidades avanzadas de IA, Llama puede ayudar a las empresas a impulsar su éxito.

• Servicio y asistencia al cliente

Los chatbots avanzados o asistentes virtuales con tecnología de Llama pueden comprender mejor las preguntas de los clientes, especialmente las consultas complejas, y ofrecer respuestas correctas y contextualizadas. Ofrecer soporte al cliente 24/7 es una ventaja.

• Análisis de datos e inteligencia empresarial

Llama puede extraer datos de diversas fuentes y tomar decisiones que inicialmente requerían habilidades técnicas. Permite a los gerentes y analistas empresariales obtener una consulta SQL mediante preguntas. El modelo puede analizar texto, imágenes, gráficos y otro contenido para generar un resumen narrativo. Esto ayuda a identificar rápidamente tendencias emergentes, información competitiva y quejas comunes.

• Marketing y automatización de contenidos

El proceso de producir contenido de alta calidad y optimizado para SEO requiere mucho tiempo. Llama puede generar rápidamente borradores o artículos completos con un tema sencillo y varias palabras clave. Los editores humanos pueden refinar estos resultados. El modelo también puede automatizar la creación de publicaciones en redes sociales. Además, puede ayudar a redactar asuntos atractivos para correos electrónicos y anuncios.

• Desarrollo de software

Un modelo Llama específico para cada código puede actuar como un autocompletado avanzado para mantener la calidad del código, gestionar sistemas heredados y acelerar los ciclos de desarrollo. Puede ayudar a revisar el código para detectar posibles errores. Además, puede generar y actualizar automáticamente la documentación del código y las referencias de la API basándose en los comentarios del código fuente.

Esta sección ofrece una comparación de la serie Llama de Meta con otras alternativas líderes en formato de tabla. Puede comparar estos factores clave para encontrar la opción que mejor se adapte a sus necesidades específicas.

Debe quedar claro que estos modelos de IA tienen sus propias fortalezas y debilidades. La elección no consiste en encontrar una única opción.

| Modelos de IA | LLaMA de Meta 4/3/2 | GPT-4 de OpenAI | Claude 3 de Anthropic | PaLM 2 de Google |

| Licencia | Licencia personalizada de código abierto | Propiedad | Propiedad | Propiedad |

| Acceso | Descargar y alojarlo usted mismo | Solo API Acceso mediante suscripción | Solo API Acceso mediante precios basados en el uso | Solo API Acceso a través de Vertex AI de Google |

| Modelos de IA | LLaMA de Meta 4/3/2 | GPT-4 de OpenAI | Claude 3 de Anthropic | PaLM 2 de Google |

| Rendimiento | De primer nivel Competitivo con los mejores modelos de IA Requiere ajustes para que coincida con el rendimiento de GPT-4 en tareas específicas Falta de entrega de contenido creativo atractivo y de alta calidad | Líder de la industria Manejar razonamientos complejos, matices y resolución creativa de problemas. | De primer nivel Excelente en análisis de datos, diálogos sofisticados y razonamiento de largo contexto. | De primer nivel Excelente en razonamiento y tareas multilingües. |

| Estructura de costos | Altos gastos de capital, bajos gastos operativos El costo se escala con el tamaño del modelo y el volumen de uso | Sin CapEx, Alto OpEx No Costo inicial, pero pago por token por uso | Sin gastos de capital, gastos operativos elevados Similar a OpenAI, pago por token | Sin gastos de capital, gastos operativos elevados Pago por token en Vertex AI, con descuentos por volumen |

| Privacidad y seguridad de datos | Máximo control Los datos nunca abandonarán su infraestructura Ideal para industrias altamente reguladas | Los datos de entrada/salida se procesan en los servidores de OpenAI | Política de privacidad estricta, pero los datos son procesados por Anthropic | Seguridad de nivel empresarial Datos procesados en Google Cloud Ofrece controles de VPC y compromisos de residencia de datos |

| Personalización y control | Control completo Se puede ajustar completamente con datos propietarios | Limitado El ajuste fino solo está disponible para modelos más antiguos (no GPT-4) | Limitado Personalizado mediante ingeniería rápida y contexto. | Fuerte Buen soporte para el ajuste fino y el aprendizaje de refuerzo |

| Escalabilidad | Necesita aprovisionar y administrar su propia infraestructura | OpenAI gestiona toda la infraestructura | Anthropic gestiona toda la infraestructura | Google Cloud administra la infraestructura |

En general, Llama es ideal para empresas que prefieren control total, privacidad de datos y personalización. GPT-4 es ideal para empresas que requieren el máximo rendimiento bruto y capacidad de razonamiento. Puede gestionar mejor tareas complejas, especialmente análisis creativos y avanzados. Claude 3 es ideal para aplicaciones donde la seguridad y la reducción de sesgos son primordiales. Rara vez produce resultados perjudiciales. PaLM 2 es ideal para empresas con una sólida integración en el ecosistema de Google Cloud. Garantiza una integración fluida con otras herramientas de Google.

Antes de implementar Llama, debe determinar sus necesidades según el caso de uso específico. ¿Necesita el modelo de parámetros de 70B para obtener la máxima calidad o solo el modelo de 8B para tareas básicas?

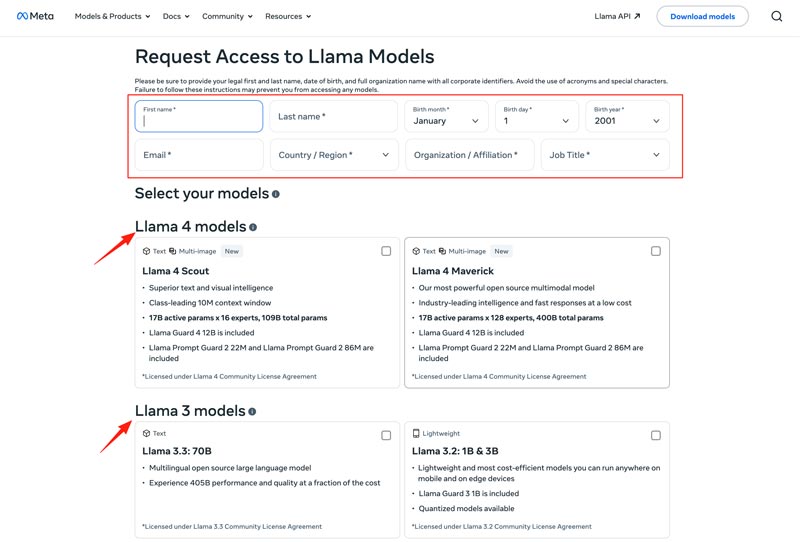

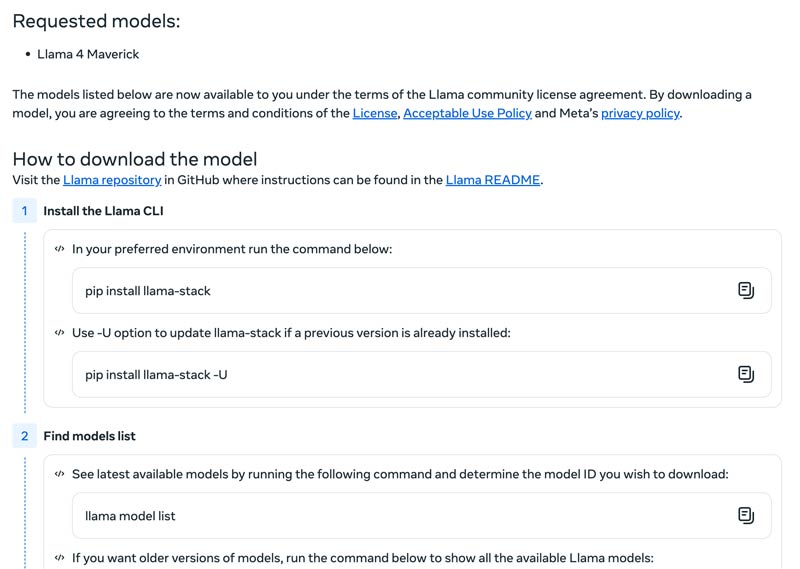

Debe elegir su método de implementación, como una máquina local, una máquina virtual en la nube o un servicio administrado. Ejecutar los modelos de Llama de forma eficiente suele requerir una GPU potente, especialmente para los modelos más grandes. Después, puede descargar el modelo correcto desde el sitio web de Meta.

Haz clic en el botón Download Models para entrar en la página de Request Access. Proporciona la información requerida y elige el modelo de Llama deseado.

Haz clic en el botón Next para leer los Términos y Condiciones. Debes revisar detenidamente el Acuerdo de Licencia Comunitaria y luego hacer clic en el botón Accept and Continue. Sigue las instrucciones en pantalla para descargar el modelo que hayas seleccionado.

Puedes utilizar un framework como Text Generation Inference para obtener un servidor de API de alto rendimiento. Si necesitas una interfaz de chat, despliega una interfaz como Chatbot UI o NextChat. Después, utiliza tus datos propios con frameworks para crear tu propio modelo especializado.

Debes saber cómo superar los desafíos para utilizar los modelos de IA de manera eficaz.

• Complejidad de la configuración inicial

Puedes usar sus herramientas y contenedores prediseñados. Ejecuta modelos localmente con un solo comando. También puedes recurrir a plataformas en la nube sin necesidad de configuración local. Hugging Face te permite ejecutar y crear demos usando entornos preconfigurados. Además, puedes empezar con llama.cpp para ejecutar una versión cuantificada de Llama.

• Gestión de recursos y optimización de costes

Los modelos grandes requieren GPU con mucha memoria, que a menudo son escasas y costosas.

La cuantificación es la técnica más eficaz. Puede usar bibliotecas para la cuantificación de 4 bits durante la inferencia o el ajuste fino. En hardware menos potente, use llama.cpp para ejecutar los modelos. Ambos métodos pueden reducir eficazmente el uso de memoria. Además, asegúrese de seleccionar el modelo correcto para sus tareas. Un modelo más pequeño y ajustado puede ser más rentable.

• Mantenerse al día con las nuevas versiones

Cada semana se lanzan nuevos modelos, técnicas y bibliotecas. Mantenerse actualizado puede ser difícil.

Suscríbete a blogs oficiales como Meta AI, Hugging Face y vLLM. Además, en plataformas como GitHub y Hugging Face se comparten nuevas técnicas de optimización, aplicaciones, mejoras de eficiencia, experiencias, soluciones y más. Esto permite a tu equipo integrar mejoras.

También puedes necesitar:

Pregunta 1. ¿Está permitido usar la salida de los modelos Llama para entrenar otros LLM?

Sí, Meta permite usar versiones más recientes (Llama 3.1 y posteriores) de la salida de Llama para entrenar otros modelos. Sin embargo, no está permitido usarla para crear un producto que compita con Meta. Además, debe ser plenamente consciente de los límites legales establecidos por la licencia de Meta.

Pregunta 2. ¿Tienen restricciones los modelos Llama? ¿Cuáles son los términos relacionados?

Sí, los modelos de Llama tienen restricciones significativas, definidas por su estructura de licencias. Estos modelos no son verdaderamente de código abierto. En cambio, se publican bajo una licencia propietaria de Meta. Esto con el fin de proteger los intereses de Meta y evitar casos de uso competitivos.

Pregunta 3. ¿Cuáles son los casos de uso más habituales de Llama?

Los usos cotidianos de Llama incluyen la comprensión de imágenes y documentos, la respuesta a preguntas, la generación de imágenes y texto, la generación y el resumen de idiomas, el entrenamiento de idiomas, la IA para conversaciones y mucho más. Llama puede responder a tu pregunta basándose en el contenido de la imagen o el documento que proporciones. Además, puede usarse para crear un chatbot o un asistente visual.

Pregunta 4. ¿Cuáles son los requisitos de hardware para usar los modelos Llama?

Los requisitos de hardware para ejecutar modelos Llama se determinan por tres factores clave: tamaño del modelo, cuantificación y caso de uso. Para la mayoría de los desarrolladores, una RTX 4070/4080/4090 o una Mac con 16-36 GB de memoria unificada es una opción flexible para modelos Llama de hasta 70 GB. Para el funcionamiento basado en GPU, el factor más crucial es la VRAM de la tarjeta gráfica. Como se mencionó, seleccione el tamaño del modelo correcto según sus necesidades y, a continuación, elija el nivel de cuantificación compatible con su hardware.

Pregunta 5. ¿Es Llama tan bueno como ChatGPT?

Puedes consultar la tabla anterior para comparar sus factores clave entre Llama y ChatGPT. Llama puede ejecutarse localmente y sin conexión. Ofrece una protección de datos más segura. Además, el propio modelo Llama es gratuito. ChatGPT tiene una versión gratuita, pero sus modelos avanzados y funciones requieren un plan de pago.

Conclusión

Llama no es solo otro modelo. A menudo se considera un cambio estratégico hacia un futuro de IA más accesible y personalizable. En este análisis directo al grano puedes conocer diversa información relacionada con la familia Llama AI y después decidir si está a la altura de las expectativas.

encuentras esto de ayuda?

484 votos