In evidenza: chat AI , giochi come Retro , cambio di posizione , Roblox sbloccato

In evidenza: chat AI , giochi come Retro , cambio di posizione , Roblox sbloccato

Sin dal lancio rivoluzionario di Llama 1, le API proprietarie e chiuse sono state irrevocabilmente democratizzate. La serie open source Llama (Large Language Model Meta AI) di Meta ha rimodellato il panorama dell'intelligenza artificiale. Llama 3, ad alte prestazioni, e il suo ultimo rilascio, Llama 4, fanno di questa famiglia di modelli la base per l'innovazione dell'intelligenza artificiale open source.

Se sei confuso dai innumerevoli modelli di IA, leggi questa completa recensione di Llama. Potrai scoprire che cos’è Llama, cosa rende unica Llama AI, il suo convincente caso d’uso per il business, il posizionamento competitivo rispetto ai giganti come ChatGPT, una guida pratica per le imprese e altro ancora.

Indice dei contenuti

Llama si riferisce a una collezione di modelli linguistici di grandi dimensioni fondamentali sviluppati da Meta. A differenza dei precedenti modelli accessibili solo tramite API, la serie Llama è rilasciata pubblicamente per uso di ricerca e commerciale. In effetti, è stata progettata una licenza personalizzata per prevenire gli abusi, che si applica in determinate condizioni di scalabilità. L’ultima versione è Llama 4.

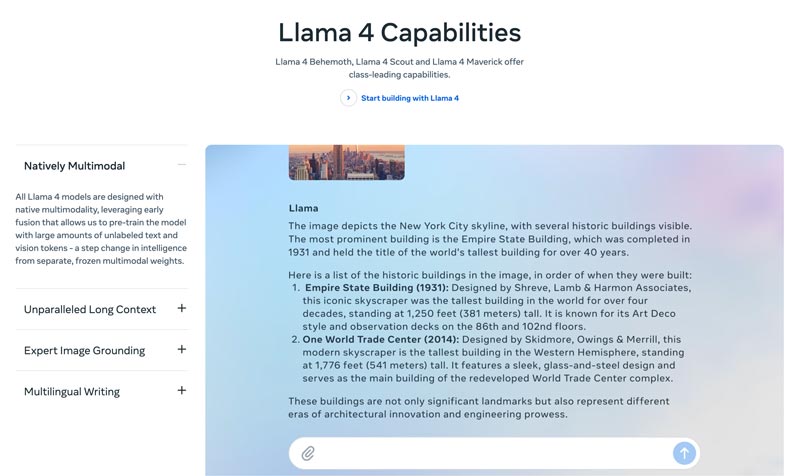

Llama 4 è l’ultima versione. Meta afferma che sia la versione più intelligente, scalabile e comoda. Con capacità più avanzate di ragionamento e pianificazione, funzionalità multimodali e funzioni di scrittura multilingue, Llama 4 può offrire una finestra di contesto leader del settore. Ti permette di distribuire facilmente le tue idee più straordinarie tramite la Llama API e lo stack Llama. L’attuale Llama 4 consente esperienze più personalizzate.

Llama 3 è stato rilasciato nell’aprile 2024. Rispetto a Llama 2, Llama 3 presenta diversi miglioramenti, tra cui un ragionamento e un coding potenziati, dati di training migliorati, una finestra di contesto più ampia e un tokenizer più efficiente.

Llama 1 & 2: Il Llama originale è stato rilasciato all’inizio del 2023 e Llama 2 nel luglio 2023. Hanno segnato l’ingresso diretto di Meta nell’arena dei chatbot. Con una variante ottimizzata, a partire da Llama 2 la serie offre un dialogo utile e sicuro. Llama 1/2 è stato sviluppato principalmente per sfidare direttamente ChatGPT di OpenAI e Bard di Google.

Sviluppato da Meta per rimodellare il panorama dell’IA, le alte prestazioni non saranno una tua preoccupazione. Llama viene messo a punto (fine-tuned) sui dati specifici della tua azienda per superare modelli generici più grandi su compiti specifici. Il potenziale di personalizzazione tramite fine-tuning lo rende adatto alla maggior parte degli sviluppatori e dei ricercatori.

L’unicità di Llama non risiede solo nelle sue prestazioni. L’ecosistema che Llama ha generato può rappresentare un vantaggio ancora maggiore. Il suo ecosistema su Hugging Face ha innescato un’esplosione di innovazione. Migliaia di derivati ottimizzati sono offerti per ogni tipo di compito concepibile.

Inoltre, Llama ha messo un LLM di livello top nelle mani di tutti. La democratizzazione dell’IA è un altro beneficio che rende Llama unico. I modelli Llama AI sono disponibili per tutti i ricercatori, sviluppatori e startup, che possono usarli, innovare e costruire senza pagare tariffe API o chiedere autorizzazioni.

Vantaggio strategico per le aziende. Llama ti permette di possedere in prima persona ciò che costruisci con l’IA. Non devi più essere legato ai prezzi, ai cambi di policy o alle deprecazioni di API di un fornitore. Questo evita in modo efficace il vendor lock-in.

Il business case di Llama non riguarda semplicemente l'utilizzo di un modello di intelligenza artificiale diverso. Può infatti rappresentare un cambiamento radicale nel modo in cui un'azienda gestisce l'intelligenza artificiale.

Nei primi tempi molte aziende hanno adottato servizi basati su API, come il GPT-4 di OpenAI. Questa può essere l’opzione più comoda, che consente sperimentazione a bassa soglia e prototipazione rapida. Tuttavia, questa strategia di IA è stata sostituita da un approccio più strategico e di lungo periodo, basato su modelli open source fondamentali come Llama di Meta. Il caso Llama poggia su tre fattori chiave: riduzione dei costi, controllo e personalizzazione, e sicurezza dei dati.

I costi delle API per molte aziende (che elaborano milioni di query al giorno) possono arrivare a milioni all'anno. L'implementazione di Llama rappresenta un passaggio dalle spese operative (OpEx) alle spese in conto capitale (CapEx). Questo rende evidente il ROI ad alti volumi.

Llama ti consente di creare un'intelligenza artificiale personalizzata, che si adatti al meglio alla tua attività o ai tuoi prodotti. Hai anche il controllo completo sugli input e sugli output del tuo modello. Diventa una risorsa fondamentale, non un servizio a noleggio.

La pubblica amministrazione e la finanza hanno rigorosi requisiti di governance dei dati. Llama può essere implementato completamente on-premise o in una VPC (Virtual Private Cloud) conforme. Questo è spesso l'unico modo legale per sfruttare la tecnologia LLM. Inoltre, l'implementazione di Llama all'interno di una VPC sicura garantisce che tutti i dati siano protetti e non escano mai dal firewall. Ciò elimina efficacemente il rischio di esposizione dei dati di terze parti.

In sintesi, il business case di Llama riguarda la proprietà. Ti viene restituita la proprietà del tuo vantaggio competitivo, della sicurezza dei tuoi dati e dei tuoi costi.

Llama di Meta offre alle aziende un nuovo modo di utilizzare l’IA. Questo potente modello di IA ha un’ampia gamma di applicazioni, tra cui IA conversazionale, generazione di immagini e testo, training linguistico, sintesi e altri compiti correlati. Sfruttando capacità di IA avanzate, Llama può aiutare le aziende a favorire il successo.

• Assistenza clienti e supporto

I chatbot avanzati o gli assistenti virtuali basati su Llama possono comprendere meglio le domande dei clienti, in particolare quelle complesse, e fornire risposte corrette e contestualizzate. È vantaggioso fornire assistenza clienti 24 ore su 24, 7 giorni su 7.

• Analisi dei dati e Business Intelligence

Llama può estrarre dati da diverse fonti e prendere decisioni che inizialmente richiedevano competenze tecniche. Permette a manager e analisti aziendali di ottenere una query SQL ponendo domande. Il modello può analizzare testo, immagini, grafici e altri contenuti per fornire un riepilogo narrativo. Ciò aiuta a identificare rapidamente tendenze emergenti, insight competitivi e reclami comuni.

• Marketing e automazione dei contenuti

Il processo di produzione di contenuti di alta qualità e ottimizzati per la SEO richiede molto tempo. Llama può generare rapidamente bozze o articoli completi con un argomento semplice e diverse parole chiave. I redattori possono quindi perfezionare questi risultati. Il modello può anche automatizzare la creazione di post sui social media. Inoltre, può aiutare a scrivere righe dell'oggetto accattivanti per email e annunci pubblicitari.

• Sviluppo software

Un modello Llama specifico per il codice può fungere da completamento automatico avanzato per mantenere la qualità del codice, gestire i sistemi legacy e accelerare i cicli di sviluppo. Può aiutare a rivedere il codice alla ricerca di potenziali bug. Inoltre, può generare e aggiornare automaticamente la documentazione del codice e i riferimenti API in base ai commenti del codice sorgente.

Questa sezione fornisce un confronto tra la serie Llama di Meta e altre alternative leader, in formato tabellare. Puoi confrontare questi fattori chiave per trovare la soluzione più adatta alle tue esigenze specifiche.

Dovrebbe essere chiaro che questi modelli di intelligenza artificiale hanno i loro punti di forza e di debolezza. La scelta non riguarda la ricerca di un'unica opzione.

| Modelli di intelligenza artificiale | Meta's LLaMA 4/3/2 | GPT-4 di OpenAI | Claude 3 di Anthropic | PaLM 2 di Google |

| Licenza | Licenza open source personalizzata | Proprietario | Proprietario | Proprietario |

| Accesso | Scarica e auto-ospita | Solo API Accesso tramite abbonamento | Solo API Accesso tramite prezzi basati sull'utilizzo | Solo API Accesso tramite Vertex AI di Google |

| Modelli di intelligenza artificiale | Meta's LLaMA 4/3/2 | GPT-4 di OpenAI | Claude 3 di Anthropic | PaLM 2 di Google |

| Prestazione | Di alto livello Competitivo con i migliori modelli di intelligenza artificiale Richiede una messa a punto per eguagliare le prestazioni GPT-4 su attività specifiche Scarso nel fornire contenuti creativi coinvolgenti e di alta qualità | leader del settore Gestire ragionamenti complessi, sfumature e risoluzione creativa dei problemi | Di alto livello Eccellente nell'analisi dei dati, nel dialogo sofisticato e nel ragionamento a lungo contesto | Di alto livello Eccellente nel ragionamento e nei compiti multilingue |

| Struttura dei costi | Alto CapEx, basso OpEx I costi variano in base alle dimensioni del modello e al volume di utilizzo | Nessun CapEx, alto OpEx No costo iniziale, ma pagamento per token per l'utilizzo | Nessun CapEx, alto OpEx Simile a OpenAI, pagamento per token | Nessun CapEx, alto OpEx Pagamento per token su Vertex AI, con sconti sul volume |

| Privacy e sicurezza dei dati | Controllo massimo I dati non lasceranno mai la tua infrastruttura. Ideale per settori altamente regolamentati. | I dati di input/output vengono elaborati sui server di OpenAI | Politica sulla privacy rigorosa, ma i dati vengono elaborati da Anthropic | Sicurezza di livello aziendale Dati elaborati su Google Cloud Offre controlli VPC e impegni di residenza dei dati |

| Personalizzazione e controllo | Controllo completo Può essere completamente ottimizzato su dati proprietari | Limitato La messa a punto è disponibile solo per i modelli più vecchi (non GPT-4) | Limitato Personalizzato tramite prompt engineering e contesto | Forte Buon supporto per la messa a punto e l'apprendimento per rinforzo |

| Scalabilità | Devi predisporre e gestire la tua infrastruttura | OpenAI gestisce tutta l'infrastruttura | Anthropic gestisce tutte le infrastrutture | Google Cloud gestisce l'infrastruttura |

In generale, Llama è ideale per le aziende che preferiscono avere controllo completo, riservatezza dei dati e personalizzazione. GPT-4 è più adatto alle aziende che richiedono le massime prestazioni e capacità di ragionamento. Può gestire meglio attività complesse, in particolare analisi creative e avanzate. Claude 3 è ideale per applicazioni in cui la sicurezza e la riduzione dei bias sono fondamentali. Raramente produce output dannosi. PaLM 2 è ideale per le aziende profondamente integrate nell'ecosistema Google Cloud. Garantisce un'integrazione perfetta con altri strumenti Google.

Prima di implementare Llama, dovresti prima definire le tue esigenze in base al caso d'uso specifico. Hai bisogno del modello a 70B per la massima qualità o solo del modello a 8B per le attività di base?

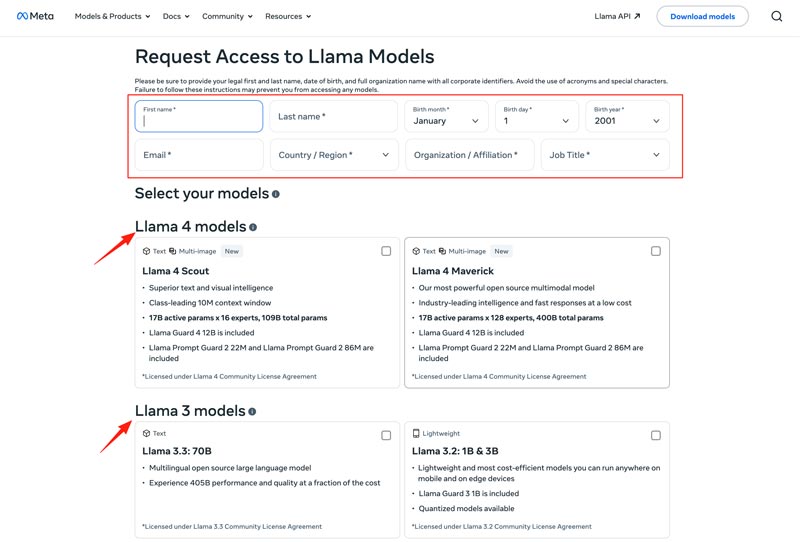

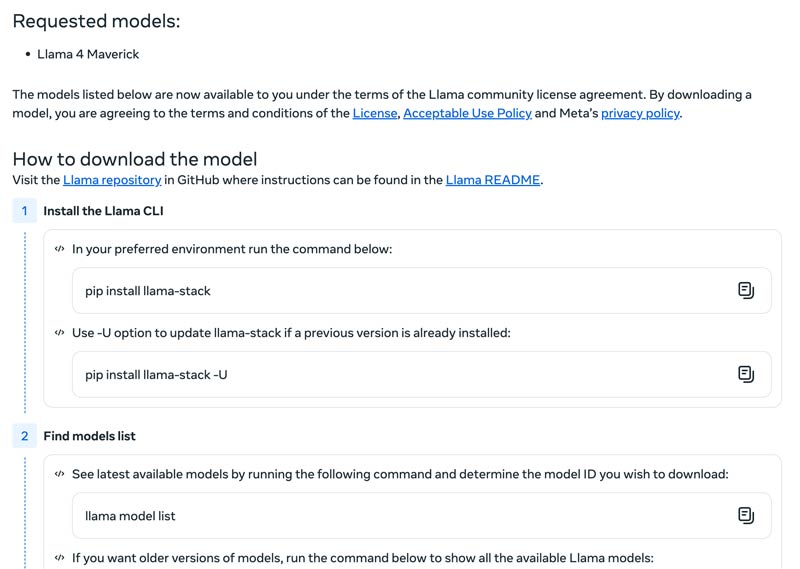

Dovresti scegliere il metodo di distribuzione, ad esempio una macchina locale, una VM cloud o un servizio gestito. L'esecuzione efficiente dei modelli Llama richiede spesso una GPU potente, soprattutto per i modelli più grandi. Dopodiché, puoi scaricare il modello corretto dal sito web Meta.

Fai clic sul pulsante Download Models per accedere alla pagina Request Access. Fornisci le informazioni richieste e scegli il modello Llama desiderato.

Fai clic sul pulsante Next per leggere i Termini e condizioni. Dovresti controllare attentamente il Community License Agreement e poi fare clic sul pulsante Accept and Continue. Segui le istruzioni sullo schermo per scaricare il modello selezionato.

Puoi usare un framework come Text Generation Inference per ottenere un server API ad alte prestazioni. Se ti serve un’interfaccia di chat, distribuisci una UI come Chatbot UI o NextChat. Successivamente, utilizza i tuoi dati proprietari con i framework per creare il tuo modello specializzato.

Per utilizzare in modo efficace i modelli di intelligenza artificiale, è necessario sapere come superare le sfide.

• Complessità della configurazione iniziale

È possibile utilizzare i suoi strumenti e contenitori predefiniti. Eseguire modelli localmente con un singolo comando. È anche possibile passare a piattaforme basate su cloud senza alcuna configurazione locale. Hugging Face consente di eseguire e creare demo utilizzando ambienti preconfigurati. Inoltre, è possibile iniziare con llama.cpp per eseguire una versione quantizzata di Llama.

• Gestione delle risorse e ottimizzazione dei costi

I modelli di grandi dimensioni richiedono GPU con molta memoria, spesso rare e costose.

La quantizzazione è la tecnica più efficace. È possibile utilizzare librerie per la quantizzazione a 4 bit durante l'inferenza o la messa a punto. Su hardware meno potente, utilizzare llama.cpp per eseguire i modelli. Entrambi i metodi possono ridurre efficacemente l'utilizzo di memoria. Inoltre, assicurarsi di selezionare il modello corretto per le proprie attività. Un modello più piccolo e messo a punto può essere più conveniente.

• Restare aggiornati con le nuove release

Ogni settimana vengono pubblicati molti nuovi modelli, tecniche e librerie. Rimanere aggiornati può essere difficile.

Dovresti iscriverti ai blog ufficiali come Meta AI, Hugging Face e vLLM. Inoltre, nuove tecniche di ottimizzazione, applicazioni, miglioramenti in termini di efficienza, esperienze, soluzioni e altro ancora vengono condivisi su piattaforme come GitHub e Hugging Face. Questo consente al tuo team di integrare i miglioramenti.

Potresti anche aver bisogno di:

Domanda 1. È consentito utilizzare l’output dei modelli Llama per addestrare altri LLM?

Sì, Meta consente di utilizzare le versioni più recenti (Llama 3.1 e successive) dell'output di Llama per addestrare altri modelli. Di certo, non è consentito utilizzarlo per creare un prodotto che compete con Meta. Inoltre, è necessario essere pienamente consapevoli dei limiti legali stabiliti dalla licenza di Meta.

Domanda 2. I modelli Llama hanno restrizioni? Quali sono i termini correlati?

Sì, i modelli Llama presentano restrizioni significative, definite dalla loro struttura di licenza. Questi modelli non sono realmente open source. Sono invece rilasciati con una licenza proprietaria da Meta. Questo per proteggere gli interessi di Meta e prevenire casi d'uso concorrenziali.

Domanda 3. Quali sono i casi d’uso più comuni di Llama?

Gli utilizzi quotidiani di Llama includono la comprensione di immagini e documenti, la risposta a domande, la generazione di immagini e testi, la generazione e la sintesi linguistica, la formazione linguistica, l'intelligenza artificiale per conversazioni e altro ancora. Llama può rispondere alle tue domande in base al contenuto dell'immagine o del documento che hai fornito. Inoltre, può essere utilizzato per creare un chatbot o un assistente visivo.

Domanda 4. Quali sono i requisiti hardware per l’uso dei modelli Llama?

I requisiti hardware per l'esecuzione dei modelli Llama sono determinati da tre fattori chiave: dimensione del modello, quantizzazione e caso d'uso. Per la maggior parte degli sviluppatori, una RTX 4070/4080/4090 o un Mac con 16-36 GB di memoria unificata rappresentano una scelta flessibile per i modelli Llama fino a 70B. Per il funzionamento basato su GPU, il fattore più cruciale è la VRAM della scheda grafica. Come accennato, seleziona la dimensione del modello corretta in base alle tue esigenze e quindi scegli il livello di quantizzazione supportato dall'hardware.

Domanda 5. Llama è buono quanto ChatGPT?

Puoi controllare la tabella sopra per confrontare i fattori chiave tra Llama e ChatGPT. Llama può essere eseguito in locale e offline. Offre una protezione dei dati più sicura. Inoltre, il modello Llama in sé è gratuito da usare. ChatGPT ha una versione gratuita, ma i suoi modelli e funzionalità avanzati richiedono un piano a pagamento.

Conclusione

Llama non è solo un altro modello. È spesso visto come un cambiamento strategico verso un futuro dell’IA più accessibile e personalizzabile. In questa recensione schietta puoi apprendere varie informazioni relative alla famiglia Llama AI e poi scoprire se è all’altezza dell’hype.

Hai trovato questo utile?

484 voti