In evidenza: chat AI , giochi come Retro , cambio di posizione , Roblox sbloccato

In evidenza: chat AI , giochi come Retro , cambio di posizione , Roblox sbloccato

Stanco degli infiniti strumenti di intelligenza artificiale per le immagini?

Stable Diffusion si presenta come una soluzione di “libertà” per la generazione di immagini tramite IA. Quando cerchi un potente modello testo‑immagine in grado di generare immagini di alta qualità a partire dalle tue descrizioni testuali, potresti imbatterti in esso o ricevere raccomandazioni correlate.

Tuttavia, in un settore in rapida espansione con modelli simili e concorrenti come Midjourney, Seedance e Veo 3, potresti chiederti: Stable Diffusion vale il tuo tempo o Stable Diffusion offre davvero risultati di livello professionale?

Questa recensione di Stable Diffusion fornisce tutte le informazioni necessarie su questo modello di generazione di immagini con IA e risponde proprio a questa domanda.

Indice dei contenuti

Stable Diffusion è un modello testo‑immagine flessibile di deep learning sviluppato da Stability AI. Si basa sulla tecnologia di diffusione (rilasciata nel 2022) che può trasformare descrizioni testuali in rappresentazioni visive. Il modello utilizza un text encoder CLIP ViT-L/14 per generare immagini di alta qualità in risposta ai prompt.

Rispetto ai precedenti modelli di diffusione, l'ultima versione di Stable Diffusion 3.5 riduce significativamente i requisiti di memoria. È progettata con una grande innovazione architetturale, implementando il processo di diffusione in uno spazio latente. I modelli precedenti operavano direttamente nello spazio immagine.

Grazie alla svolta tecnica e alla sua natura open source, Stable Diffusion ha presto attratto una base di utenti molto più ampia, tra cui sviluppatori, ricercatori, singoli creatori e utenti aziendali.

• Miglioramento costante con gli aggiornamenti di versione. Dalla sua prima uscita, questo modello di generazione testo‑immagine ha subito un’evoluzione significativa. Le versioni principali includono Stable Diffusion 1.5, 2.0, 2.1, 3.0 e la più recente serie 3.5. Hanno apportato miglioramenti sostanziali in vari aspetti, tra cui qualità dell’output, comprensione dei prompt e capacità di generazione, tra gli altri.

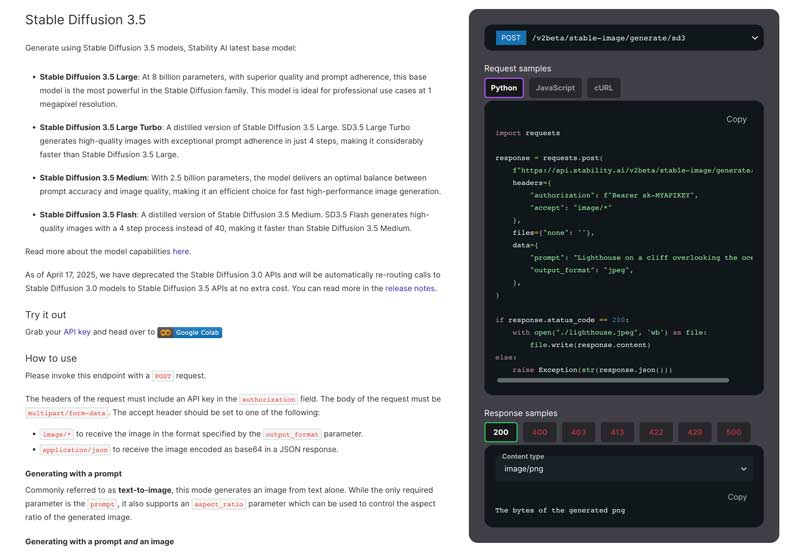

• Molteplici versioni del modello. Diversi modelli specializzati sono progettati per soddisfare differenti esigenze degli utenti. L’ultimo modello di base è Stable Diffusion 3.5. Offre miglioramenti significativi rispetto alle versioni precedenti. Attualmente ci sono quattro versioni principali nella famiglia Stable Diffusion: Stable Diffusion 3.5 Large, Large Turbo, Medium e Flash.

• Comprensione avanzata dei prompt. L’attuale Stable Diffusion 3.5 è dotato di una sofisticata architettura multi‑text encoder che gli permette di elaborare in modo più efficace prompt più complessi e dettagliati. Può elaborare descrizioni testuali fino a 10.000 caratteri. Ciò consente agli utenti di fornire descrizioni più dettagliate. Nel frattempo, Stable Diffusion può produrre risultati di qualità superiore e più accurati.

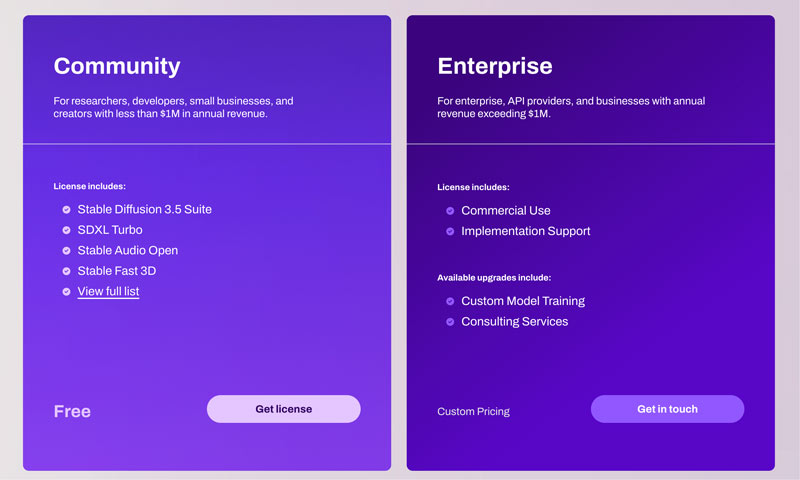

• Flessibilità commerciale e creativa. I modelli Stable Diffusion 3.5 sono rilasciati sotto la Stability AI Community License e la Enterprise License. Questo ne consente l’uso sia commerciale che non commerciale. Per la maggior parte degli utenti occasionali, come ricercatori, sviluppatori e piccole imprese con ricavi annui inferiori a $1M, è possibile utilizzare Stable Diffusion liberamente senza restrizioni. Gli utenti possono adattare liberamente l’IA alle proprie esigenze specifiche e ai propri stili artistici.

Come accennato in precedenza, la versatilità di Stable Diffusion lo rende adatto a quasi tutti gli utenti. Sviluppatori, ricercatori, designer, artisti digitali, appassionati di intelligenza artificiale e persino studenti possono trarre notevoli vantaggi dalle sue capacità.

L'ultimo modello Stable Diffusion 3.5 offre funzionalità avanzate per generare immagini con dettagli più accurati. Le foto generate presentano spesso illuminazione e soggetti accurati. Inoltre, può adattarsi meglio allo stile artistico specifico in base alle tue richieste.

Per la maggior parte dei modelli di generazione di immagini, aree come le mani e i tratti del viso possono essere particolarmente complesse. Con l'adozione di un VAE a 16 canali, questi artefatti e imperfezioni comuni possono essere efficacemente risolti. La diffusione stabile è efficace nel riprodurre effetti di illuminazione accurati.

Nonostante questi miglioramenti, Stable Diffusion presenta ancora alcuni punti deboli. Il modello continua a presentare alcune difficoltà, in particolare nei rendering a figura intera. Come altri modelli di generazione di immagini basati sull'intelligenza artificiale, Stable Diffusion produce spesso risultati inaspettati, in particolare quando si generano figure umane complete. L'attuale Stable Diffusion 3.5 offre buone prestazioni con primi piani, ritratti e vari soggetti non umani.

L'efficienza di Stable Diffusion varia a seconda della versione specifica del modello utilizzato, dell'hardware, delle impostazioni di output e dei prompt. In genere, con una potente GPU NVIDIA, è possibile generare facilmente un'immagine standard 1024x1024 in 5-15 secondi. Meglio di molte alternative, Stable Diffusion consente agli utenti di addestrare e perfezionare i modelli sui propri set di dati. Questo è particolarmente utile per gli utenti professionali.

Rispetto ai modelli precedenti, l'attuale Stable Diffusion 3.5 è molto più facile da usare. Tuttavia, la "semplicità" è strettamente legata alle competenze tecniche, al livello di esperienza e all'interfaccia scelta.

Sono disponibili diversi approcci per diversi livelli di familiarità tecnica. Vai al sito ufficiale di Stability AI, ottieni una licenza e quindi invia una richiesta POST come richiesto.

Relativamente parlando, grazie a diverse soluzioni integrate, il processo di configurazione di Stable Diffusion è stato notevolmente semplificato. Inoltre, Stable Diffusion dispone di un'interfaccia Web che include una dashboard completa per un migliore controllo del processo di generazione. Per un'efficace distribuzione locale, si consiglia inoltre di verificare i requisiti hardware consigliati. Per i principianti, consigliamo di utilizzare Stable Diffusion su Windows 10 o 11.

La maggior parte delle community e delle piattaforme attive, come Reddit, Discord e forum, raccolgono tecniche, creazioni e soluzioni per la risoluzione di problemi relativi alla diffusione stabile. Questo ecosistema di supporto guidato dalla community può condividere rapidamente nuovi modelli, funzionalità, soluzioni pratiche e altre risorse preziose.

| Caratteristica/Modello | Diffusione stabile | Midjourney | Danza dei semi | VEO 3 |

| Prezzi | Modello gratuito e open source (licenza comunitaria). Costi per hardware e cloud | Abbonamento: circa $10 – $$1.152/mese | API: $0.09 – $1.50 per video | API: Prezzi dell'API per sviluppatori Gemini |

| Requisiti hardware | Alto (richiede una GPU potente) | Basso (funziona su Discord, non è necessario alcun hardware locale) | Basato su cloud (non è richiesto alcun hardware utente) | Basato su cloud (non è richiesto alcun hardware utente) |

| Personalizzazione | Ampio (open source, supporta ControlNet, LoRA e addestramento di modelli personalizzati) | Limitato (tramite prompt e parametri di base) | Esteso (tramite prompt e controlli creativi) | Limitato (principalmente nei prompt) |

| Qualità immagine/video | Limite massimo elevato, dipende dai modelli e dalla messa a punto | Alta qualità predefinita, forte stile artistico | Video ad alta definizione 1080p | Video da 720p a 1080p da 8 secondi |

| Comprensione del testo | Bene, addestrati e potenziati con modelli personalizzati | Eccellente | Eccellente, comprende richieste complesse | Eccellente, comprende narrazioni complesse |

| Facilità d'uso | Curva di apprendimento più ripida | Facile | Basato su API, richiede integrazione | Facile, necessita di integrazione |

Stable Diffusion è una buona scelta per gruppi di utenti specifici, principalmente quelli con competenze tecniche e requisiti di personalizzazione. Offre funzionalità che giustificano la sua curva di apprendimento più ripida e i requisiti hardware. Tuttavia, per i principianti, molti concorrenti offrono un'esperienza di configurazione e utilizzo molto più semplice. Se si dispone di hardware compatibile e di sufficiente motivazione per imparare, Stable Diffusion è uno strumento flessibile e creativo per la generazione di immagini AI.

Domanda 1. Quanto costa Stable Diffusion?

Stability AI offre una Community License per permettere a sviluppatori, ricercatori, piccole imprese e creatori di utilizzare gratuitamente i Core Models (incluso Stable Diffusion 3), a meno che la tua attività non generi oltre $1M USD di fatturato annuo o tu non stia usando i modelli Stable Diffusion per uno scopo commerciale. In generale, i Core Models e le Opere Derivate sono gratuiti da usare. Inserisci le informazioni richieste e poi invia una richiesta per ottenere la Community License gratuita. Leggi questo articolo per scoprire altri generatori di immagini IA gratuiti!

Domanda 2. Esistono requisiti hardware per Stable Diffusion?

Quando si desidera eseguire Stable Diffusion sul proprio computer, l'esperienza utente dipende in larga misura dall'hardware, in particolare da GPU, RAM e CPU. È consigliabile disporre di una scheda grafica NVIDIA. La tecnologia CUDA di NVIDIA è progettata con tecnologie di accelerazione avanzate. Può essere l'opzione più compatibile per l'esecuzione di Stable Diffusion. Le schede grafiche AMD sono spesso sconsigliate a causa della mancanza di ottimizzazione.

Domanda 3. Stable Diffusion è adatto ai principianti?

Iniziare a usare Stable Diffusion è diventato molto più semplice grazie ai pacchetti di installazione con un clic e ai servizi cloud. Tuttavia, per i principianti, il processo richiede ancora un po' di apprendimento, per non parlare della necessità di padroneggiarne appieno il potenziale. Che si scelga l'installazione locale o il servizio cloud, dopo aver eseguito Stable Diffusion, è possibile interagire con il programma tramite un'interfaccia utente Web. L'interfaccia utente Web presenta un'interfaccia visiva per le funzioni di conversione da testo a immagine e da immagine a immagine. È possibile utilizzarle per generare e modificare immagini. Inoltre, spesso sarà necessario fornire descrizioni testuali dettagliate per produrre le immagini desiderate. La qualità finale dell'immagine generata dipende in larga misura dai prompt forniti.

Domanda 4. Quali tipi di immagini può produrre Stable Diffusion?

Stable Diffusion può generare immagini in un’ampissima gamma di tipologie. La maggior parte degli stili artistici è supportata, inclusi immagini realistiche, anime, pittura a olio, acquerello e altri ancora. I risultati dipendono principalmente dallo specifico modello di IA utilizzato e dai prompt forniti.

Per prima cosa, devi scegliere un modello Checkpoint. Il modello determina lo stile principale dell’immagine generata, ad esempio se sarà realistica o cartoon. Puoi cercare e scaricare i modelli correlati da piattaforme della community, come Hugging Face. Poi, rifinirlo con modelli più piccoli.

Domanda 5. Posso usare Stable Diffusion per scopi commerciali?

Sì, puoi utilizzare Stable Diffusion per scopi commerciali. Tuttavia, verifica i termini specifici della versione di Stable Diffusion che stai utilizzando sul sito web ufficiale. Le regole potrebbero essere cambiate a seconda delle diverse versioni del modello. Inoltre, assicurati che l'uso commerciale previsto non violi le attività vietate dalla licenza. Infine, tieni presente che le immagini generate potrebbero non essere protette dal copyright.

Conclusione

Questa recensione di Stable Diffusion ti offre un’introduzione dettagliata al modello di generazione testo‑immagine di Stability AI, in particolare all’ultimo modello Stable Diffusion 3.5. Attraverso la recensione dovresti avere una visione chiara delle sue capacità, prestazioni, punti di forza e debolezze. Al termine di questo articolo, dovresti sapere esattamente cosa Stable Diffusion può fare per te e se vale il tuo tempo.

Hai trovato questo utile?

477 voti

Aiseesoft AI Photo Editor è un'applicazione desktop avanzata progettata per migliorare, ingrandire e ritagliare le immagini.