スポットライト:AIチャット、Retro風ゲーム、位置情報変更ツール、ブロック解除されたRoblox

Llama 1 の画期的なリリース以来、クローズドで専有的だった API は取り返しのつかない形で民主化されました。Meta のオープンソース Llama(Large Language Model Meta AI)シリーズは、AI の状況を一変させました。高性能な Llama 3 と、最新の Llama 4 によって、このモデルファミリーはオープンソース AI イノベーションの基盤となっています。

無数の AI モデルに混乱しているなら、この包括的なLlama レビューを読んでください。Llama とは何か、Llama AI をユニークにしている点、その強力なビジネス上の意義、ChatGPT などの巨人との競争力、企業向けの実践的なガイドなどを学ぶことができます。

目次

Llama とは、Meta が開発した基盤的大規模言語モデル群を指します。API 経由でしかアクセスできなかった従来モデルと異なり、Llama シリーズは研究および商用利用のために一般公開されています。実際には、悪用を防ぐための独自ライセンスが用意されており、特定のスケール条件の下で適用されます。最新バージョンは Llama 4 です。

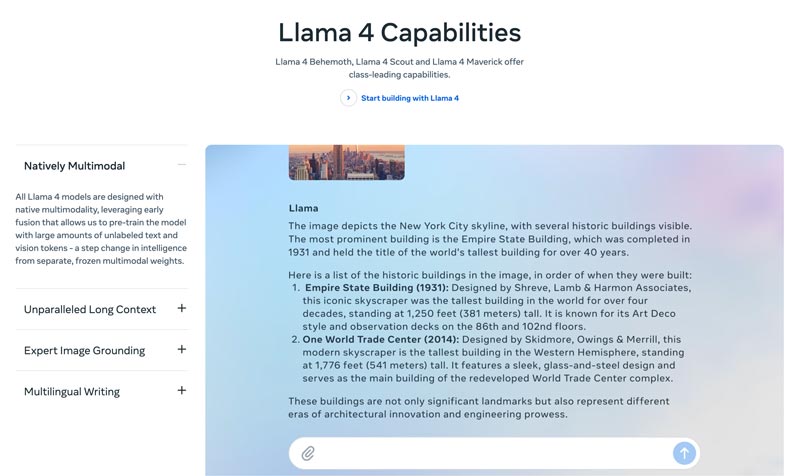

Llama 4 は最新バージョンです。Meta は、これが最もインテリジェントでスケーラブルかつ便利なバージョンだと主張しています。より高度な推論・計画能力、マルチモーダル機能、多言語での文章生成機能を備えた Llama 4 は、業界をリードするコンテキストウィンドウとなり得ます。Llama API と Llama Stack を使って、あなたの素晴らしいアイデアを簡単にデプロイできます。現在の Llama 4 は、よりパーソナライズされた体験を可能にします。

Llama 3 は 2024 年 4 月にリリースされました。Llama 2 と比較すると、Llama 3 は推論とコーディング能力の強化、学習データの改善、より大きなコンテキストウィンドウ、より効率的なトークナイザなど、いくつかの点で向上しています。

Llama 1 & 2: 初代 Llama は 2023 年初頭に、Llama 2 は 2023 年 7 月にリリースされました。これにより、Meta はチャットボット分野に本格参入しました。Llama 2 以降では、微調整バリアントにより有用で安全な対話が提供されます。Llama 1/2 は主に、OpenAI の ChatGPT や Google の Bard に真正面から挑むために開発されました。

AI の状況を再構築するために Meta によって開発されたため、その高い性能は心配無用です。Llama は、企業固有のデータで微調整することで、特定タスクにおいてより大規模な汎用モデルを上回ることができます。微調整しやすい特性により、多くの開発者や研究者に適したモデルとなっています。

Llama のユニークさは性能だけではありません。Llama が生み出したエコシステムこそ、より大きな強みとなり得ます。Hugging Face 上の Llama エコシステムは、イノベーションの爆発を引き起こしました。あらゆる想定可能なタスク向けに、何千もの微調整済み派生モデルが提供されています。

さらに、Llama はトップクラスの LLM を誰もが使えるものにしました。AI の民主化も、Llama を特徴づける利点の一つです。Llama AI モデルは、研究者、開発者、スタートアップなら誰でも、API 利用料や許可申請なしに、自由に使い、革新し、構築できるようになっています。

ビジネスにおける戦略的優位性。 Llama を使えば、自社の AI 構築物を自ら所有できます。ベンダーの料金体系、ポリシー変更、API 廃止などに縛られる必要はありません。これにより、ベンダーロックインを効果的に回避できます。

Llama のビジネス上の意義は、単に別の AI モデルを使うという話にとどまりません。実際には、企業が AI をどう扱うかを根本から変える可能性を秘めています。

初期段階では、多くの企業が OpenAI の GPT-4 のような API ベースのサービスを採用しました。これは最も便利な選択肢となり得るもので、低いハードルでの実験や迅速なプロトタイピングを可能にします。しかし、この AI 戦略は、Meta の Llama のようなオープンソース基盤モデルを用いる、より戦略的で長期的なアプローチに置き換えられつつあります。Llama を採用する理由は、コスト削減、制御とカスタマイズ性、そしてデータセキュリティという 3 つの主要因に集約されます。

膨大なクエリ(1 日に数百万件)を処理する多くの企業では、API コストが年間で数百万ドル規模に達することがあります。Llama を導入することは、運用費(OpEx)から設備投資(CapEx)へのシフトを意味します。大規模運用時には、ROI が明確になります。

Llama を使えば、自社の事業や製品に最適化された、独自に微調整された AI を構築できます。また、モデルへの入力と出力を完全に制御できます。レンタルサービスではなく、中核資産となるのです。

政府機関や金融業界は、厳格なデータガバナンス要件を持っています。Llama は、完全オンプレミス環境や、コンプライアンスに適合した VPC(仮想プライベートクラウド)内にデプロイできます。これは、多くの場合、LLM 技術を活用する唯一の合法的な方法です。さらに、Llama をセキュアな VPC 内にデプロイすれば、すべてのデータはファイアウォールの外に出ることがなく、安全に保護されます。これにより、第三者へのデータ漏えいリスクを実質的に排除できます。

要するに、Llama のビジネス上の価値は所有権にあります。競争優位性、データの安全性、そしてコストに対する主導権が、再びあなたの手に戻ってくるのです。

Meta の Llama は、企業が AI を活用する新しい方法を提供します。この強力な AI モデルは、会話 AI、画像およびテキスト生成、語学学習、要約など、幅広い用途に利用できます。高度な AI 機能を活用することで、Llama はビジネスの成功を後押しします。

・カスタマーサービスとサポート

Llama を搭載した高度なチャットボットやバーチャルアシスタントは、特に複雑な問い合わせに対して、ユーザーの質問をより的確に理解し、文脈を踏まえた正確な回答を提供できます。24 時間 365 日体制のカスタマーサポートの提供に大いに役立ちます。

・データ分析とビジネスインテリジェンス

Llama はさまざまなソースからデータを取得し、当初は専門スキルを要した意思決定を自動化できます。ビジネスマネージャーやアナリストは、質問を投げかけるだけで SQL クエリを生成させることができます。このモデルは、テキスト、画像、チャートなどのコンテンツを分析し、ナラティブな要約を提示できます。これにより、新たなトレンド、競合インサイト、よくある苦情を素早く把握できます。

・マーケティングとコンテンツ自動化

高品質で SEO 最適化されたコンテンツを制作するプロセスは時間がかかります。Llama は、簡単なトピックといくつかのキーワードから、素早くドラフトや記事全文を生成できます。その後、人間の編集者が結果をブラッシュアップします。また、このモデルはソーシャルメディア投稿の作成を自動化することもできます。さらに、メールや広告用の魅力的な件名作成を支援します。

・ソフトウェア開発

コード向けに特化した Llama モデルは、高度なオートコンプリートのように機能し、コード品質の維持、レガシーシステムの管理、開発サイクルの短縮に役立ちます。潜在的なバグを見つけるためのコードレビューも支援できます。さらに、ソースコードコメントに基づいて、コードドキュメントや API リファレンスを自動生成・更新することも可能です。

このセクションでは、Meta の Llama シリーズとその他の主要な代替モデルを、表形式で横並びに比較します。これらの重要な要素を比較し、自身のニーズに最も適したものを見つけることができます。

これらの AI モデルには、それぞれ強みと弱みがあることは明らかでしょう。単一の最適解を選ぶ話ではありません。

| AIモデル | Meta の LLaMA 4/3/2 | OpenAI の GPT-4 | Anthropic の Claude 3 | Google の PaLM 2 |

| ライセンス | オープンソース(独自ライセンス) | プロプライエタリ | プロプライエタリ | プロプライエタリ |

| アクセス方法 | ダウンロードしてセルフホスト | APIのみ サブスクリプション経由でアクセス | APIのみ 従量課金制でアクセス | APIのみ Google の Vertex AI 経由でアクセス |

| AIモデル | Meta の LLaMA 4/3/2 | OpenAI の GPT-4 | Anthropic の Claude 3 | Google の PaLM 2 |

| 性能 | トップクラス 最先端AIモデルと競合 特定タスクでGPT-4に匹敵させるにはファインチューニングが必要 魅力的で高品質なクリエイティブコンテンツの生成ではやや劣る | 業界リーダー 高度な推論・ニュアンス・創造的な問題解決をこなす | トップクラス データ分析、高度な対話、長文コンテキスト推論に優れる | トップクラス 推論と多言語タスクに優れる |

| コスト構造 | 高い設備投資(CapEx)、低い運用コスト(OpEx) コストはモデル規模と利用量に比例して増加 | 設備投資不要(No CapEx)、高い運用コスト(High OpEx) 初期費用は不要だが、利用量に応じてトークン単位で課金 設備投資不要(No CapEx)、高い運用コスト(High OpEx) | OpenAI と同様にトークン単位の従量課金 Similar to OpenAI, pay-per-token | OpenAI と同様にトークン単位の従量課金 Vertex AIのトークン単位課金(ボリュームディスカウントあり) |

| データプライバシーとセキュリティ | 最大限のコントロール データが自社インフラの外に出ることはありません 高度に規制された業界に最適 | 入出力データはOpenAIのサーバー上で処理されます | 強力なプライバシーポリシーがありますが、データはAnthropicによって処理されます | エンタープライズグレードのセキュリティ データはGoogle Cloud上で処理される VPC制御とデータ所在地(データレジデンシー)のコミットメントを提供 |

| カスタマイズとコントロール | 完全なコントロール 独自データでフルファインチューニング可能 | 制限あり ファインチューニングは旧世代モデル(GPT-4以外)でのみ利用可能 | 制限あり プロンプトエンジニアリングとコンテキストを通じてカスタマイズ | 強力 ファインチューニングと強化学習の優れたサポート |

| スケーラビリティ | 自前でインフラをプロビジョニングし、管理する必要があります | インフラはすべてOpenAIが管理します | インフラはすべてAnthropicが管理します | インフラはGoogle Cloudが管理します |

一般的に、Llama は完全な制御、データプライバシー、カスタマイズ性を重視する企業に最適です。GPT-4 は、最高レベルの生の性能と推論能力を必要とする企業に最も適しています。特に、創造的タスクや高度な分析などの複雑な作業により適しています。Claude 3 は、安全性とバイアスの少なさが最優先されるアプリケーションに理想的です。有害な出力をほとんど生成しません。PaLM 2 は、Google Cloud エコシステムに深く統合された企業に最も向いています。他の Google ツールとのシームレスな連携を実現します。

Llama をデプロイする前に、まず特定のユースケースに応じて自社のニーズを明確にすべきです。最高品質を求めて 70B パラメータモデルが必要なのか、それとも基本的なタスクには 8B モデルで十分なのかを検討してください。

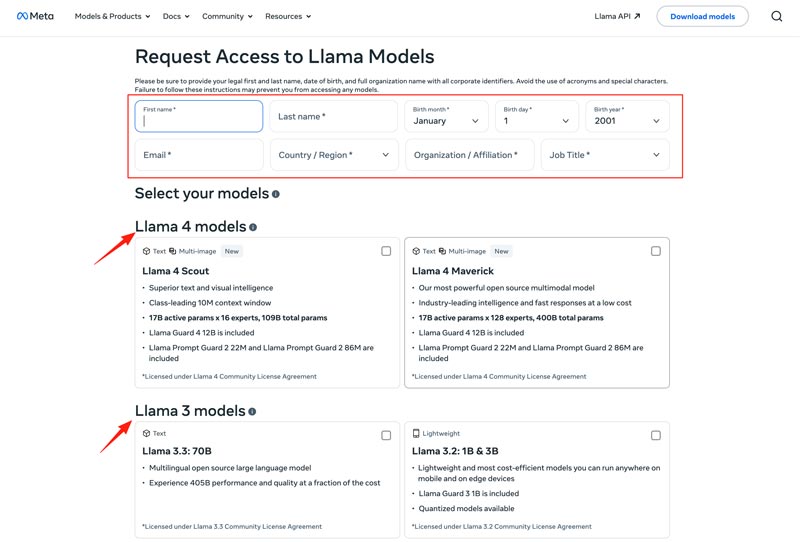

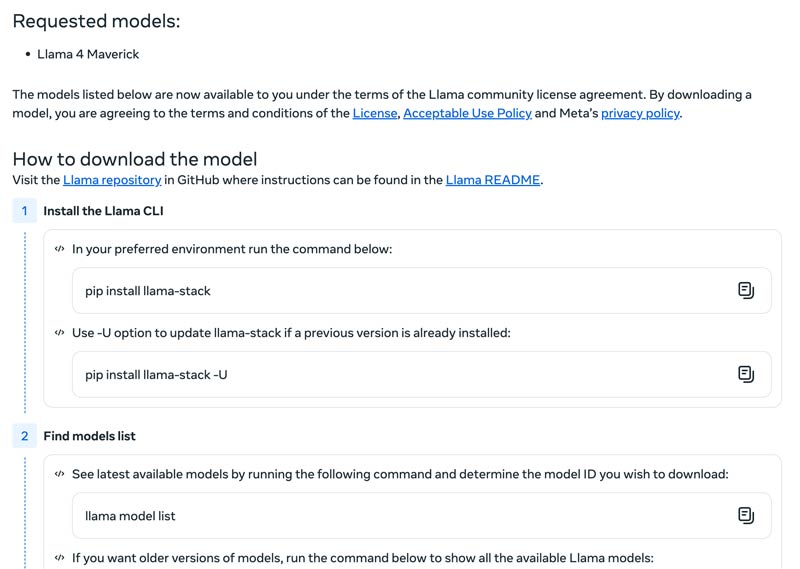

ローカルマシン、クラウド VM、マネージドサービスなど、どのデプロイ方法を選ぶかを決める必要があります。Llama モデルを効率的に動かすには、とくに大規模モデルの場合、強力な GPU が必要となることが多いです。そのうえで、Meta の Web サイトから適切なモデルをダウンロードします。

Download Models ボタンをクリックして、Request Access ページに進みます。必要事項を入力し、希望の Llama モデルを選択します。

Next ボタンをクリックして Terms and Conditions を読みます。コミュニティライセンス契約をよく確認し、Accept and Continue ボタンをクリックします。画面上の指示に従って、選択したモデルをダウンロードしてください。

Text Generation Inference のようなフレームワークを使えば、高性能な API サーバーを構築できます。チャットインターフェースが必要であれば、Chatbot UI や NextChat などの UI をデプロイします。その後、フレームワークと自社の専有データを組み合わせて、独自の特化モデルを構築できます。

AI モデルを効果的に活用するためには、直面する課題をどう克服するかを理解しておく必要があります。

・初期セットアップの複雑さ

あらかじめ用意されたツールやコンテナを利用できます。単一のコマンドでローカルにモデルを実行することも可能です。ローカル環境のセットアップを行わずに、クラウドベースのプラットフォームを利用することもできます。Hugging Face では、事前構成された環境を使ってモデルを実行したり、デモを作成したりできます。さらに、llama.cpp から始めて、量子化されたバージョンの Llama を動作させることもできます。

・リソース管理とコスト最適化

大規模モデルは大容量メモリの GPU を必要としますが、それらはしばしば不足しており高価です。

量子化は最も効果的な手法です。推論や微調整時に 4 ビット量子化を行うためのライブラリを利用できます。性能の低いハードウェアでは、llama.cpp を使ってモデルを実行します。どちらの方法もメモリ使用量を効果的に削減できます。加えて、タスクに適したモデルを選択しているか確認してください。小規模でも微調整されたモデルの方が、よりコスト効率に優れる場合があります。

・新しいリリースへのキャッチアップ

毎週、多くの新しいモデル、手法、ライブラリがリリースされています。最新情報を追い続けるのは困難になり得ます。

Meta AI、Hugging Face、vLLM などの公式ブログを購読するとよいでしょう。さらに、GitHub や Hugging Face などのプラットフォームでは、新しい微調整手法、アプリケーション、効率化手法、知見、ソリューションなどが共有されています。これにより、チームは改善点を取り入れることができます。

あわせて読みたい:

質問 1. Llama モデルの出力を、他の LLM の学習に使用することは認められていますか?

はい、Meta は Llama 3.1 以降の新しいバージョンによる Llama の出力を使用して他のモデルを訓練することを許可しています。ただし、Meta と競合する製品を作成するためにそれを使用することは認められていません。さらに、Meta のライセンスによって定められた法的な境界を十分に理解しておかなければなりません。

質問 2. Llama モデルには制限がありますか?関連する条件は何ですか?

はい、Llamaモデルには、そのライセンス構造によって定められた大きな制約があります。これらのモデルは真のオープンソースではありません。その代わり、Metaによる独自のプロプライエタリライセンスの下で公開されています。これは、Metaの利益を保護し、競合的なユースケースを防ぐためのものです。

質問 3. Llama の一般的なユースケースは何ですか?

Llama の日常的なユースケースには、画像や文書の理解、質問応答、画像およびテキスト生成、言語生成と要約、言語トレーニング、対話型 AI などが含まれます。Llama は、あなたが提供した画像や文書の内容に基づいて質問に答えることができます。さらに、チャットボットやビジュアルアシスタントを作成するためにも利用できます。

質問 4. Llama モデルを使用するためのハードウェア要件は何ですか?

Llamaモデルを実行するためのハードウェア要件は、モデルサイズ、量子化、およびユースケースという3つの重要な要素によって決まります。ほとんどの開発者にとって、RTX 4070/4080/4090、または16~36GBのユニファイドメモリを搭載したMacは、70BまでのLlamaモデルに対応できる柔軟な選択肢です。GPUベースで動作させる場合、最も重要な要素はグラフィックスカードのVRAMです。前述のとおり、自分のニーズに基づいて適切なモデルサイズを選択し、そのうえで自分のハードウェア上で動作可能な量子化レベルを選びましょう。

質問 5. Llama は ChatGPT と同等に優れていますか?

Llama と ChatGPT の主なポイントは、上の表を確認すれば比較できます。Llama はローカルかつオフラインで実行できます。より安全なデータ保護を提供します。さらに、Llama モデル自体は無料で利用できます。ChatGPT には無料版がありますが、高度なモデルや機能の利用には有料プランが必要です。

結論

Llama は単なる別のモデルではありません。よりアクセスしやすくカスタマイズ可能な AI の未来へ向けた戦略的転換とみなされることが多い存在です。この率直なレビューを通じて Llama AI ファミリーに関するさまざまな情報を学び、それが評判どおりの価値があるかどうかを判断できます。

役に立ちましたか?

484 票