W centrum uwagi: czat AI , gry takie jak Retro , zmiana lokalizacji , odblokowany Roblox

W centrum uwagi: czat AI , gry takie jak Retro , zmiana lokalizacji , odblokowany Roblox

Od przełomowego wydania Llama 1, zamknięte, zastrzeżone interfejsy API zostały nieodwołalnie zdemokratyzowane. Seria Llama (Large Language Model Meta AI) firmy Meta, oparta na otwartym kodzie źródłowym, zmieniła oblicze sztucznej inteligencji. Niezwykle wydajne Llama 3 i jej najnowsza wersja Llama 4 czynią tę rodzinę modeli fundamentem innowacji w dziedzinie otwartej sztucznej inteligencji.

Jeśli gubisz się w gąszczu niezliczonych modeli AI, przeczytaj tę kompleksową recenzję Llama. Dowiesz się, czym jest Llama, co wyróżnia Llama AI, jaki ma przekonujący biznesowy sens, jak wypada w konkurencji z gigantami takimi jak ChatGPT, poznasz praktyczny przewodnik dla firm i wiele więcej.

Spis treści

Llama to zbiór bazowych dużych modeli językowych opracowanych przez firmę Meta. W przeciwieństwie do wcześniejszych modeli, do których dostęp był możliwy wyłącznie przez API, seria Llama jest publicznie udostępniona do celów badawczych i komercyjnych. Opracowano specjalną licencję, która ma zapobiegać nadużyciom i obowiązuje przy określonej skali użycia. Najnowszą wersją jest Llama 4.

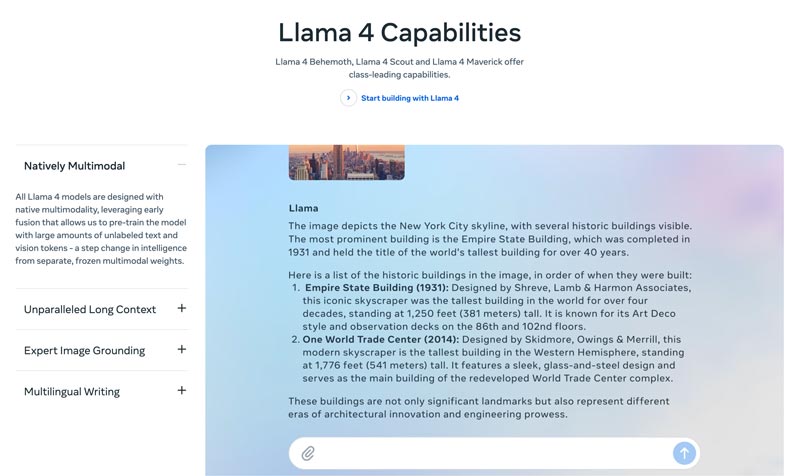

Llama 4 to najnowsza wersja. Meta twierdzi, że jest ona najbardziej inteligentna, skalowalna i wygodna. Dzięki bardziej zaawansowanym zdolnościom wnioskowania i planowania, możliwościom multimodalnym oraz funkcjom pisania w wielu językach, Llama 4 może oferować wiodące w branży okno kontekstu. Pozwala z łatwością wdrażać najbardziej niezwykłe pomysły za pomocą Llama API i Llama Stack. Obecna Llama 4 umożliwia bardziej spersonalizowane doświadczenia.

Llama 3 została wydana w kwietniu 2024 roku. W porównaniu z Llama 2, Llama 3 wprowadza szereg usprawnień, w tym lepsze wnioskowanie i kodowanie, ulepszony zbiór danych treningowych, większe okno kontekstu oraz bardziej wydajny tokenizer.

Llama 1 i 2: Oryginalna Llama została wydana na początku 2023 roku, a Llama 2 w lipcu 2023. Oznaczały bezpośrednie wejście firmy Meta na rynek chatbotów. Dzięki dopracowanej wersji, począwszy od Llama 2, seria zapewnia pomocny i bezpieczny dialog. Llama 1/2 została opracowana głównie po to, by bezpośrednio konkurować z ChatGPT firmy OpenAI oraz Bardem Google’a.

Stworzona przez Metę w celu przekształcenia krajobrazu AI, wysoka wydajność nie będzie Twoim zmartwieniem. Llama jest dostrajana na podstawie specyficznych danych Twojej firmy, aby przewyższać większe, ogólne modele w konkretnych zadaniach. Potencjał dostrajania sprawia, że jest odpowiednia dla większości deweloperów i badaczy.

Wyjątkowość Llama nie sprowadza się tylko do wydajności. Ekosystem, który wygenerowała Llama, może być jeszcze większą zaletą. Jej ekosystem na platformie Hugging Face wywołał eksplozję innowacji. Tysiące dostrojonych pochodnych modeli jest oferowanych do wszelkich wyobrażalnych zadań.

Ponadto Llama oddała topowy model LLM w ręce wszystkich. Demokratyzacja AI to kolejna korzyść, która wyróżnia Llama. Modele Llama AI są dostępne dla wszystkich badaczy, deweloperów i startupów, aby mogli je wykorzystywać, tworzyć innowacje i budować rozwiązania bez opłat za API i bez konieczności uzyskiwania zgody.

Strategiczna przewaga dla biznesu. Llama pozwala, aby budowana przez Ciebie AI była Twoją własnością. Nie musisz już być przywiązany do cen, zmian zasad czy wycofywania API przez konkretnego dostawcę. Skutecznie unikasz w ten sposób uzależnienia od jednego vendora.

Argument biznesowy za Llamą nie polega jedynie na zastosowaniu innego modelu sztucznej inteligencji. W rzeczywistości może to być fundamentalna zmiana w sposobie, w jaki firma traktuje sztuczną inteligencję.

We wczesnym etapie wiele firm korzystało z usług opartych na API, takich jak GPT-4 firmy OpenAI. Mogło to być najwygodniejsze rozwiązanie, umożliwiające eksperymenty przy niskiej barierze wejścia i szybkie prototypowanie. Jednak ta strategia AI została zastąpiona bardziej strategicznym, długoterminowym podejściem, opartym na otwartoźródłowych modelach bazowych, takich jak Llama firmy Meta. Przewaga Llama opiera się na trzech kluczowych czynnikach: oszczędnościach kosztów, kontroli i możliwości dostosowania oraz bezpieczeństwie danych.

Koszty API dla wielu firm (przetwarzających miliony zapytań dziennie) mogą sięgać milionów dolarów rocznie. Wdrożenie Llama oznacza przejście z wydatków operacyjnych (OpEx) na nakłady inwestycyjne (CapEx). Dzięki temu zwrot z inwestycji (ROI) jest wyraźnie widoczny przy dużej liczbie zapytań.

Dzięki Llama możesz stworzyć unikalnie dostrojoną sztuczną inteligencję, która najlepiej pasuje do Twojej firmy lub produktów. Masz również pełną kontrolę nad danymi wejściowymi i wyjściowymi swojego modelu. Staje się on podstawowym zasobem, a nie usługą na wynajem.

Rząd i sektor finansowy mają surowe wymogi dotyczące zarządzania danymi. Llama może być wdrożona w pełni lokalnie lub w zgodnej z przepisami wirtualnej chmurze prywatnej (VPC). Często jest to jedyny legalny sposób wykorzystania technologii LLM. Co więcej, wdrożenie Llama w bezpiecznej sieci VPC oznacza, że wszystkie Twoje dane są zabezpieczone i nigdy nie opuszczają zapory sieciowej. To skutecznie eliminuje ryzyko ujawnienia danych osobom trzecim.

Krótko mówiąc, biznesowy sens wykorzystania Llama sprowadza się do własności. Otrzymujesz z powrotem kontrolę nad swoją przewagą konkurencyjną, bezpieczeństwem danych oraz kosztami.

Llama firmy Meta zapewnia firmom nowy sposób korzystania ze sztucznej inteligencji. Ten potężny model AI ma szerokie zastosowanie, w tym w konwersacyjnej AI, generowaniu obrazów i tekstów, nauczaniu języków, podsumowywaniu oraz innych pokrewnych zadaniach. Dzięki wykorzystaniu zaawansowanych możliwości AI Llama może pomóc firmom osiągać sukces.

• Obsługa klienta i wsparcie

Zaawansowane chatboty lub wirtualni asystenci, korzystający z platformy Llama, mogą lepiej rozumieć pytania klientów, zwłaszcza te złożone, i udzielać poprawnych, kontekstowych odpowiedzi. Korzystne jest zapewnienie całodobowej obsługi klienta.

• Analiza danych i business intelligence

Llama może pobierać dane z różnych źródeł i podejmować decyzje, które początkowo wymagały umiejętności technicznych. Umożliwia menedżerom i analitykom uzyskanie zapytania SQL poprzez zadawanie pytań. Model analizuje tekst, obrazy, wykresy i inne treści, tworząc podsumowanie narracyjne. Pomaga to szybko identyfikować pojawiające się trendy, analizy konkurencji i typowe problemy.

• Marketing i automatyzacja treści

Proces tworzenia wysokiej jakości treści zoptymalizowanych pod kątem SEO jest czasochłonny. Llama może szybko generować wersje robocze lub całe artykuły o prostym temacie i kilku słowach kluczowych. Redaktorzy mogą następnie dopracować te wyniki. Model ten może również automatyzować tworzenie postów w mediach społecznościowych. Co więcej, pomaga w tworzeniu atrakcyjnych tematów e-maili i reklam.

• Tworzenie oprogramowania

Model Llama, specyficzny dla kodu źródłowego, może pełnić funkcję zaawansowanego autouzupełniania, pomagając w utrzymaniu jakości kodu, zarządzaniu starszymi systemami i przyspieszaniu cykli rozwoju. Może pomóc w przeglądaniu kodu pod kątem potencjalnych błędów. Ponadto, może automatycznie generować i aktualizować dokumentację kodu oraz referencje API na podstawie komentarzy w kodzie źródłowym.

W tej sekcji znajdziesz porównanie serii Llama firmy Meta z innymi wiodącymi alternatywami w formie tabeli. Możesz porównać te kluczowe czynniki, aby znaleźć rozwiązanie najlepiej odpowiadające Twoim potrzebom.

Powinno być jasne, że te modele sztucznej inteligencji mają swoje mocne i słabe strony. Wybór nie polega na znalezieniu jednej opcji.

| Modele AI | Meta LLaMA 4/3/2 | GPT-4 firmy OpenAI | Klaudia antropiczna 3 | PaLM 2 firmy Google |

| Licencja | Licencja open-source, niestandardowa | Prawnie zastrzeżony | Prawnie zastrzeżony | Prawnie zastrzeżony |

| Dostęp | Pobierz i hostuj samodzielnie | Tylko API Dostęp poprzez subskrypcję | Tylko API Dostęp poprzez cennik oparty na użytkowaniu | Tylko API Dostęp za pośrednictwem Vertex AI firmy Google |

| Modele AI | Meta LLaMA 4/3/2 | GPT-4 firmy OpenAI | Klaudia antropiczna 3 | PaLM 2 firmy Google |

| Wydajność | Najwyższej klasy Konkurencyjny w stosunku do najlepszych modeli AI Wymaga dostrojenia w celu dopasowania wydajności GPT-4 do określonych zadań Nie zapewnia angażujących, wysokiej jakości treści kreatywnych | Lider branży Radzenie sobie ze złożonym rozumowaniem, niuansami i kreatywnym rozwiązywaniem problemów | Najwyższej klasy Doskonała analiza danych, wyrafinowany dialog i rozumowanie długokontekstowe | Najwyższej klasy Doskonała umiejętność rozumowania i wykonywania zadań wielojęzycznych |

| Struktura kosztów | Wysokie nakłady inwestycyjne, niskie nakłady operacyjne Koszty zależą od rozmiaru modelu i wolumenu użytkowania | Brak CapEx, wysokie OpEx Brak koszt początkowy, ale płatność za token za użytkowanie | Brak nakładów inwestycyjnych, wysokie nakłady operacyjne Podobnie jak OpenAI, płatność za token | Brak nakładów inwestycyjnych, wysokie nakłady operacyjne Płatność za token w Vertex AI z rabatami ilościowymi |

| Prywatność i bezpieczeństwo danych | Maksymalna kontrola Dane nigdy nie opuszczą Twojej infrastruktury Idealne dla branż o wysokim stopniu regulacji | Dane wejściowe/wyjściowe przetwarzane są na serwerach OpenAI | Silna polityka prywatności, ale dane są przetwarzane przez Anthropic | Bezpieczeństwo klasy korporacyjnej Dane przetwarzane w Google Cloud Oferuje kontrolę VPC i zobowiązania dotyczące przechowywania danych |

| Personalizacja i kontrola | Pełna kontrola Można go w pełni dostroić na podstawie zastrzeżonych danych | Ograniczony Dokładne dostrajanie jest dostępne tylko w starszych modelach (nie GPT-4) | Ograniczony Dostosowane za pomocą szybkiej inżynierii i kontekstu | Mocny Dobre wsparcie dla dostrajania i uczenia się przez wzmacnianie |

| Skalowalność | Musisz zapewnić i zarządzać własną infrastrukturą | OpenAI zarządza całą infrastrukturą | Anthropic zarządza całą infrastrukturą | Google Cloud zarządza infrastrukturą |

Ogólnie rzecz biorąc, Llama jest idealna dla firm, które cenią sobie pełną kontrolę, prywatność danych i możliwość personalizacji. GPT-4 najlepiej sprawdza się w przedsiębiorstwach wymagających najwyższej wydajności i możliwości wnioskowania. Lepiej radzi sobie ze złożonymi zadaniami, zwłaszcza z kreatywną i zaawansowaną analizą. Claude 3 idealnie nadaje się do aplikacji, w których bezpieczeństwo i redukcja stronniczości są priorytetem. Rzadko generuje szkodliwe wyniki. PaLM 2 najlepiej sprawdza się w firmach, które są głęboko zintegrowane z ekosystemem Google Cloud. Zapewnia bezproblemową integrację z innymi narzędziami Google.

Przed wdrożeniem Llama należy najpierw określić swoje potrzeby w zależności od konkretnego przypadku użycia. Czy potrzebujesz modelu 70B dla maksymalnej jakości, czy tylko modelu 8B do podstawowych zadań?

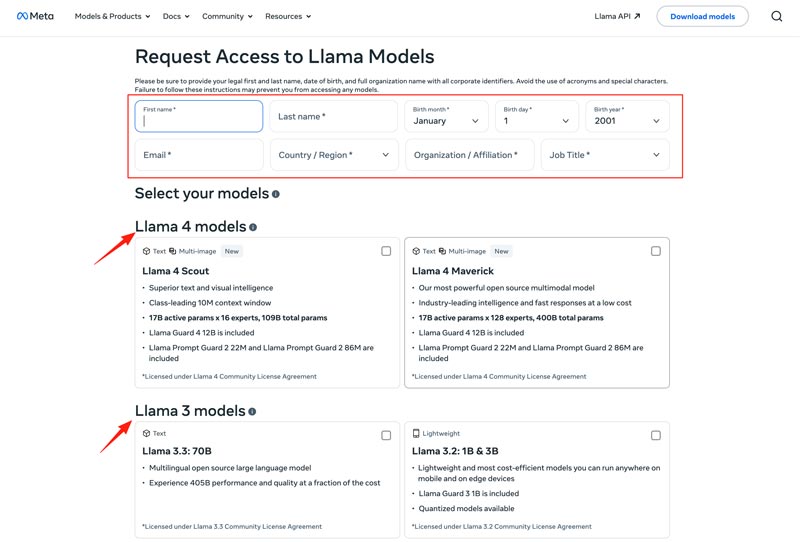

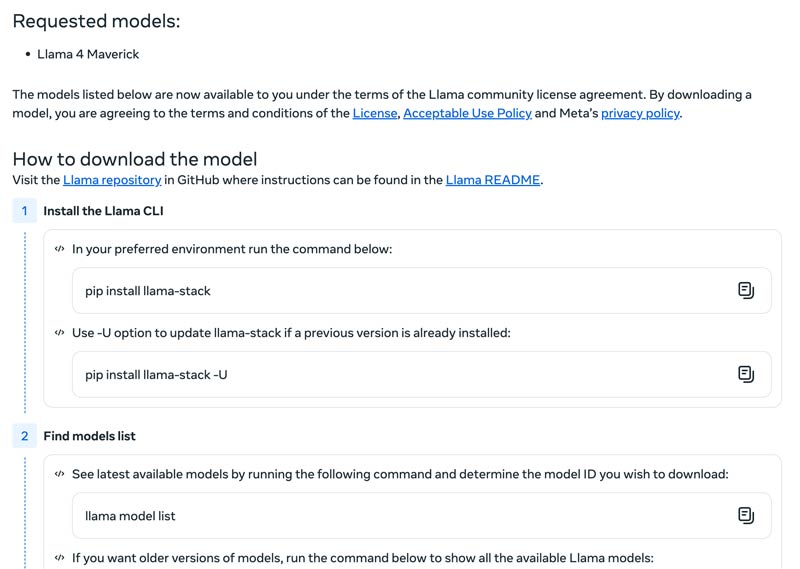

Należy wybrać metodę wdrożenia, taką jak maszyna lokalna, maszyna wirtualna w chmurze lub usługa zarządzana. Efektywne uruchamianie modeli Llama często wymaga wydajnego procesora graficznego (GPU), szczególnie w przypadku większych modeli. Następnie można pobrać odpowiedni model ze strony internetowej Meta.

Kliknij przycisk Download Models, aby przejść do strony Request Access. Podaj wymagane informacje i wybierz preferowany model Llama.

Kliknij przycisk Next, aby zapoznać się z Warunkami i zasadami. Należy dokładnie sprawdzić Community License Agreement, a następnie kliknąć przycisk Accept and Continue. Postępuj zgodnie z instrukcjami wyświetlanymi na ekranie, aby pobrać wybrany model.

Możesz użyć frameworka takiego jak Text Generation Inference, aby uzyskać wysokowydajny serwer API. Jeśli potrzebujesz interfejsu czatu, wdroż UI, np. Chatbot UI lub NextChat. Następnie wykorzystaj swoje zastrzeżone dane wraz z frameworkami, aby stworzyć własny, wyspecjalizowany model.

Powinieneś wiedzieć, jak pokonywać trudności, aby skutecznie korzystać z modeli sztucznej inteligencji.

• Złożoność początkowej konfiguracji

Możesz korzystać z gotowych narzędzi i kontenerów. Uruchamiaj modele lokalnie za pomocą jednego polecenia. Możesz również korzystać z platform chmurowych bez konieczności konfiguracji lokalnej. Hugging Face umożliwia uruchamianie i tworzenie wersji demonstracyjnych przy użyciu wstępnie skonfigurowanych środowisk. Co więcej, możesz zacząć od llama.cpp, aby uruchomić skwantyzowaną wersję Llama.

• Zarządzanie zasobami i optymalizacja kosztów

Większe modele wymagają procesorów graficznych o dużej pamięci, które są często trudno dostępne i kosztowne.

Kwantowanie to najskuteczniejsza technika. Możesz korzystać z bibliotek do kwantyzacji 4-bitowej podczas wnioskowania lub dostrajania. Na słabszym sprzęcie, do uruchamiania modeli użyj llama.cpp. Obie metody mogą skutecznie zmniejszyć zużycie pamięci. Ponadto upewnij się, że wybrałeś odpowiedni model do swoich zadań. Mniejszy, dostrojony model może być bardziej opłacalny.

• Nadążanie za nowymi wydaniami

Co tydzień publikowanych jest wiele nowych modeli, technik i bibliotek. Nadążanie za najnowszymi trendami może być trudne.

Warto subskrybować oficjalne blogi, takie jak Meta AI, Hugging Face i vLLM. Co więcej, na platformach takich jak GitHub i Hugging Face udostępniane są nowe techniki dostrajania, aplikacje, informacje o wzroście wydajności, doświadczenia, rozwiązania i wiele więcej. Dzięki temu Twój zespół może szybko wdrażać ulepszenia.

Możesz też potrzebować:

Pytanie 1. Czy dozwolone jest używanie wyników generowanych przez modele Llama do trenowania innych LLM?

Tak, Meta zezwala na używanie nowszych wersji (Llama 3.1 i nowszych) danych wyjściowych Llama do trenowania innych modeli. Oczywiście nie wolno używać ich do tworzenia produktu konkurującego z Meta. Ponadto należy dokładnie znać ograniczenia prawne określone w licencji Meta.

Pytanie 2. Czy modele Llama mają ograniczenia? Jakie są związane z nimi warunki?

Tak, modele Llama mają istotne ograniczenia, określone przez ich strukturę licencyjną. Modele te nie są w pełni open source. Zamiast tego są udostępniane na zastrzeżonej licencji Meta. Ma to na celu ochronę interesów Meta i zapobieganie przypadkom użycia w sposób konkurencyjny.

Pytanie 3. Jakie są typowe zastosowania Llama?

Do codziennych zastosowań Llama należą: rozumienie obrazów i dokumentów, odpowiadanie na pytania, generowanie obrazów i tekstu, generowanie i streszczanie języka, nauka języka, sztuczna inteligencja konwersacyjna i wiele innych. Llama może odpowiedzieć na Twoje pytanie na podstawie dostarczonego obrazu lub treści dokumentu. Co więcej, można jej użyć do stworzenia chatbota lub asystenta wizualnego.

Pytanie 4. Jakie są wymagania sprzętowe dotyczące korzystania z modeli Llama?

Wymagania sprzętowe do uruchomienia modeli Llama zależą od trzech kluczowych czynników: rozmiaru modelu, kwantyzacji i zastosowania. Dla większości deweloperów, karty graficzne RTX 4070/4080/4090 lub komputer Mac z 16–36 GB pamięci zunifikowanej (Unified Memory) to elastyczny wybór dla modeli Llama do 70 GB. W przypadku działania opartego na GPU, najważniejszym czynnikiem jest pamięć VRAM karty graficznej. Jak wspomniano, należy wybrać odpowiednią wielkość modelu w oparciu o potrzeby, a następnie poziom kwantyzacji, który będzie obsługiwany przez posiadany sprzęt.

Pytanie 5. Czy Llama jest tak dobra jak ChatGPT?

Możesz sprawdzić powyższą tabelę, aby porównać kluczowe czynniki Llama i ChatGPT. Llama może być uruchamiana lokalnie i offline. Oferuje bardziej bezpieczną ochronę danych. Co więcej, sam model Llama jest darmowy w użyciu. ChatGPT ma darmową wersję, ale jego zaawansowane modele i funkcje wymagają płatnego planu.

Wniosek

Llama to nie tylko kolejny model. Często postrzega się ją jako strategiczny zwrot w kierunku bardziej dostępnej i łatwiej dostosowywalnej przyszłości AI. W tej konkretnej, pozbawionej zbędnych upiększeń recenzji możesz poznać różne informacje o rodzinie Llama AI i sprawdzić, czy rzeczywiście jest warta tego rozgłosu.

Czy uznałeś to za pomocne?

484 Głosów