W centrum uwagi: czat AI , gry takie jak Retro , zmiana lokalizacji , odblokowany Roblox

W centrum uwagi: czat AI , gry takie jak Retro , zmiana lokalizacji , odblokowany Roblox

Znudziły Ci się niezliczone narzędzia do obróbki obrazów AI?

Stable Diffusion pozycjonuje się jako rozwiązanie zapewniające “wolność” w dziedzinie generowania obrazów przez AI. Gdy szukasz wydajnego modelu tekst‑na‑obraz, który potrafi tworzyć wysokiej jakości grafiki na podstawie opisów tekstowych, możesz natrafić na ten model lub otrzymać związane z nim rekomendacje.

Jednak w szybko rozwijającym się sektorze z podobnymi modelami i konkurentami, takimi jak Midjourney, Seedance i Veo 3, możesz się zastanawiać: czy Stable Diffusion jest wart twojego czasu i czy rzeczywiście zapewnia rezultaty na poziomie profesjonalnym?

Ta recenzja Stable Diffusion dostarcza wszystkich niezbędnych informacji o tym modelu generowania obrazów za pomocą AI i odpowiada na właśnie to pytanie.

Spis treści

Stable Diffusion to elastyczny model głębokiego uczenia typu tekst‑na‑obraz opracowany przez firmę Stability AI. Opiera się na technologii dyfuzji (wydanej w 2022 roku), która potrafi przekształcać opisy tekstowe w reprezentacje wizualne. Model wykorzystuje enkoder tekstu CLIP ViT-L/14 do generowania wysokiej jakości obrazów w odpowiedzi na podane prompty.

W porównaniu z wcześniejszymi modelami dyfuzji, najnowsza wersja Stable Diffusion 3.5 znacząco zmniejsza zapotrzebowanie na pamięć. Została zaprojektowana z dużą innowacją architektoniczną, implementując proces dyfuzji w przestrzeni utajonej. Wcześniejsze modele działają bezpośrednio w przestrzeni obrazu.

Dzięki przełomowi technicznemu i otwartemu kodowi źródłowemu Stable Diffusion szybko przyciągnął znacznie szerszą grupę użytkowników, w tym programistów, badaczy, twórców indywidualnych i użytkowników korporacyjnych.

• Stałe ulepszanie wraz z aktualizacjami wersji. Od czasu pierwszego wydania ten model generowania obrazów z tekstu przeszedł znaczącą ewolucję. Główne wersje to Stable Diffusion 1.5, 2.0, 2.1, 3.0 oraz najnowsza seria 3.5. Wprowadzono w nich istotne ulepszenia w różnych aspektach, w tym jakości wyników, rozumienia promptów i możliwości generowania.

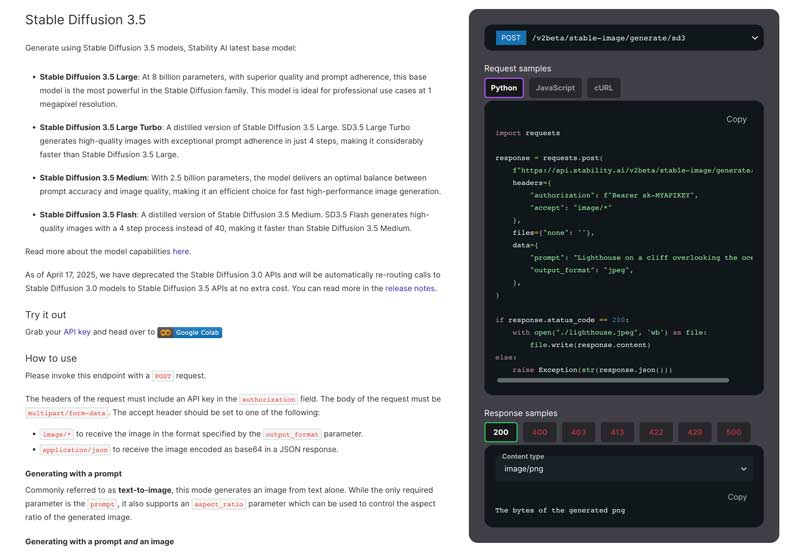

• Wiele wersji modeli. Opracowano kilka wyspecjalizowanych modeli, aby zaspokoić różne potrzeby użytkowników. Najnowszym modelem bazowym jest Stable Diffusion 3.5. Oferuje on znaczące ulepszenia względem poprzednich wersji. Obecnie w rodzinie Stable Diffusion wyróżnia się cztery główne wersje: Stable Diffusion 3.5 Large, Large Turbo, Medium i Flash.

• Zaawansowane rozumienie promptów. Obecny Stable Diffusion 3.5 wykorzystuje zaawansowaną architekturę z wieloma enkoderami tekstu, która pozwala mu skuteczniej przetwarzać bardziej złożone i szczegółowe prompty. Może obsłużyć opisy tekstowe o długości do 10 000 znaków. Umożliwia to użytkownikom podawanie bardziej szczegółowych opisów, a Stable Diffusion może w zamian generować wyniki wyższej jakości i bardziej precyzyjne.

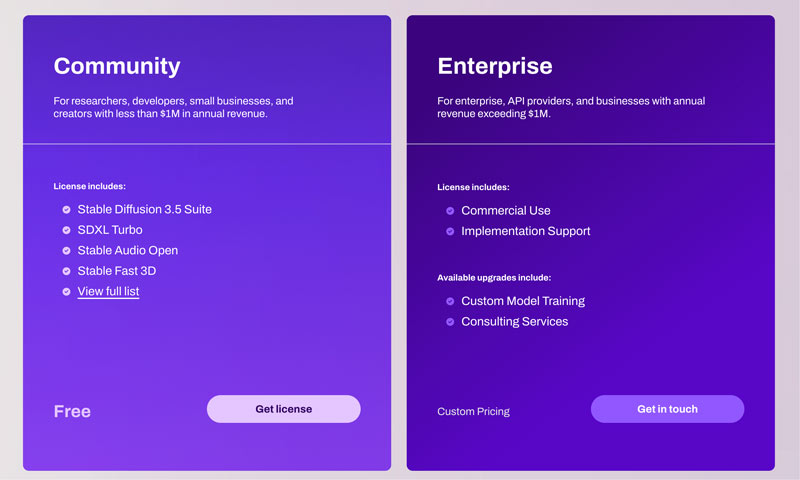

• Elastyczność komercyjna i kreatywna. Modele Stable Diffusion 3.5 są udostępniane na podstawie licencji Stability AI Community License oraz Enterprise License. Pozwala to na wykorzystywanie ich zarówno komercyjnie, jak i niekomercyjnie. Dla większości zwykłych użytkowników, takich jak badacze, deweloperzy i małe firmy o rocznych przychodach poniżej $1M, Stable Diffusion może być używany swobodnie, bez ograniczeń. Użytkownicy mogą dowolnie dostosowywać AI do swoich specyficznych potrzeb i stylów artystycznych.

Jak wspomniano powyżej, wszechstronność Stable Diffusion sprawia, że jest on odpowiedni dla niemal wszystkich użytkowników. Zarówno programiści, badacze, projektanci, artyści cyfrowi, hobbyści zajmujący się sztuczną inteligencją, jak i studenci, mogą czerpać znaczące korzyści z jego możliwości.

Najnowszy model Stable Diffusion 3.5 oferuje zaawansowane możliwości generowania drobniejszych szczegółów obrazu. Wygenerowane zdjęcia często charakteryzują się precyzyjnym oświetleniem i obiektami. Co więcej, może lepiej dopasować się do konkretnego stylu artystycznego w oparciu o Twoje sugestie.

W przypadku większości modeli generowania obrazu, obszary takie jak ludzkie dłonie i rysy twarzy mogą być szczególnie trudne do odwzorowania. Dzięki zastosowaniu 16-kanałowego przetwornika VAE te typowe artefakty i niedoskonałości można skutecznie wyeliminować. Stabilna dyfuzja dobrze sprawdza się w renderowaniu precyzyjnych efektów świetlnych.

Pomimo tych ulepszeń, Stable Diffusion wciąż ma swoje słabe strony. Model ten nadal napotyka pewne trudności, szczególnie w przypadku renderowania całych postaci. Podobnie jak inne modele AI do generowania obrazów, Stable Diffusion często generuje nieoczekiwane rezultaty, szczególnie podczas generowania całych postaci ludzkich. Obecna wersja Stable Diffusion 3.5 dobrze radzi sobie z ujęciami zbliżeniowymi, portretami i różnymi obiektami niebędącymi ludźmi.

Wydajność funkcji Stable Diffusion różni się w zależności od używanej wersji modelu, sprzętu, ustawień wyjściowych i komunikatów. Zazwyczaj, dzięki wydajnemu procesorowi graficznemu NVIDIA, można łatwo wygenerować standardowy obraz o rozdzielczości 1024x1024 w ciągu 5–15 sekund. Lepsza niż wiele alternatyw, funkcja Stable Diffusion pozwala użytkownikom trenować i dostrajać modele na własnych zbiorach danych. Jest to szczególnie cenne dla użytkowników profesjonalnych.

W porównaniu z poprzednimi modelami, obecny Stable Diffusion 3.5 jest znacznie łatwiejszy w obsłudze. Jednak określenie „łatwość” zależy w dużej mierze od umiejętności technicznych, poziomu doświadczenia i wybranego interfejsu.

Dostępnych jest wiele podejść, odpowiednich dla różnych poziomów zaawansowania technicznego. Przejdź na oficjalną stronę Stability AI, uzyskaj licencję, a następnie wyślij żądanie POST zgodnie z wymaganiami.

Relatywnie rzecz biorąc, dzięki różnorodnym zintegrowanym rozwiązaniom, proces konfiguracji Stable Diffusion został znacząco uproszczony. Co więcej, Stable Diffusion posiada interfejs WebUI z kompleksowym pulpitem nawigacyjnym, który umożliwia lepszą kontrolę procesu generowania. Aby zapewnić efektywne wdrożenie lokalne, zaleca się również sprawdzenie sugerowanych wymagań sprzętowych. Początkującym zalecamy korzystanie ze Stable Diffusion w systemie Windows 10 lub 11.

Większość aktywnych społeczności i platform, takich jak Reddit, Discord i fora, gromadzi powiązane techniki, dzieła i rozwiązania problemów dotyczące Stable Diffusion. Ten ekosystem wsparcia, oparty na społeczności, umożliwia szybkie udostępnianie nowych modeli, funkcji, praktycznych rozwiązań i innych cennych zasobów.

| Funkcja/Model | Stabilna dyfuzja | W połowie podróży | Seedance | VEO 3 |

| cennik | Bezpłatny model open source (Licencja Społecznościowa). Koszty sprzętu i chmury. | Subskrypcja: około $10 – $$1,152/miesiąc | API: $0.09 – $1.50 za film | API: Cennik API dla programistów Gemini |

| Wymagania sprzętowe | Wysoki (wymaga wydajnego procesora graficznego) | Niski (działa na Discordzie, nie wymaga lokalnego sprzętu) | Oparte na chmurze (nie wymaga sprzętu użytkownika) | Oparte na chmurze (nie wymaga sprzętu użytkownika) |

| Personalizacja | Obszerny (o otwartym kodzie źródłowym, obsługuje ControlNet, LoRA i szkolenie niestandardowych modeli) | Ograniczony (za pomocą monitów i podstawowych parametrów) | Obszerny (za pomocą monitów i kreatywnych elementów sterujących) | Ograniczone (głównie w komunikatach) |

| Jakość obrazu/wideo | Wysoka górna granica, zależy od modelu i strojenia | Wysoka jakość domyślna, silny styl artystyczny | Filmy w wysokiej rozdzielczości 1080p | 8-sekundowe filmy w rozdzielczości 720p–1080p |

| Rozumienie tekstu | Dobrze, można szkolić i ulepszać za pomocą niestandardowych modeli | Doskonały | Doskonale, rozumie złożone polecenia | Doskonale, rozumie złożone narracje |

| Łatwość użycia | Bardziej stroma krzywa uczenia się | Łatwo | Oparty na API, wymaga integracji | Łatwe, wymaga integracji |

Stable Diffusion to dobry wybór dla określonych grup użytkowników, głównie tych z umiejętnościami technicznymi i potrzebami personalizacji. Oferuje możliwości, które uzasadniają jego trudniejszą naukę i wymagania sprzętowe. Jednak dla początkujących, wielu konkurentów oferuje znacznie łatwiejszą konfigurację i obsługę. Jeśli posiadasz kompatybilny sprzęt i wystarczającą motywację do nauki, Stable Diffusion to elastyczne i kreatywne narzędzie do generowania obrazów AI.

Pytanie 1. Ile kosztuje Stable Diffusion?

Stability AI oferuje Community License dla deweloperów, badaczy, małych firm i twórców, aby mogli używać Core Models (w tym Stable Diffusion 3) za darmo, o ile ich firma nie osiąga więcej niż $1M USD rocznych przychodów lub nie wykorzystują modeli Stable Diffusion w celach komercyjnych. Ogólnie rzecz biorąc, Core Models i Derivative Works są dla ciebie bezpłatne w użyciu. Wprowadzasz wymagane informacje, a następnie składasz wniosek o darmową licencję Community License. Przeczytaj ten artykuł, aby poznać więcej darmowych generatorów obrazów AI!

Pytanie 2. Czy istnieją wymagania sprzętowe dla Stable Diffusion?

Jeśli chcesz uruchomić Stable Diffusion na swoim komputerze, wrażenia użytkownika w dużej mierze zależą od sprzętu, a zwłaszcza od karty graficznej, pamięci RAM i procesora. Powinieneś posiadać kartę graficzną NVIDIA. Technologia CUDA firmy NVIDIA została zaprojektowana z myślą o zaawansowanej akceleracji. Może to być najbardziej kompatybilna opcja do uruchomienia Stable Diffusion. Karty graficzne AMD często nie są zalecane ze względu na brak optymalizacji.

Pytanie 3. Czy Stable Diffusion jest odpowiedni dla początkujących?

Rozpoczęcie korzystania ze Stable Diffusion stało się znacznie łatwiejsze dzięki pakietom instalacyjnym obsługiwanym jednym kliknięciem i usługom w chmurze. Jednak dla początkujących proces ten nadal wiąże się z nauką, nie mówiąc już o pełnym wykorzystaniu jego potencjału. Niezależnie od tego, czy wybierzesz instalację lokalną, czy usługę w chmurze, po uruchomieniu Stable Diffusion możesz z nim współpracować za pośrednictwem interfejsu WebUI. Interfejs użytkownika Web oferuje wizualny interfejs do funkcji przekształcania tekstu na obraz i obrazu na obraz. Można ich używać do generowania i modyfikowania obrazów. Ponadto, często konieczne będzie podanie szczegółowych opisów tekstowych, aby uzyskać pożądane obrazy. Ostateczna jakość wygenerowanego obrazu w dużej mierze zależy od wyświetlanych komunikatów.

Pytanie 4. Jakiego rodzaju obrazy może generować Stable Diffusion?

Stable Diffusion może generować obrazy w bardzo szerokiej gamie typów. Obsługiwanych jest większość stylów artystycznych, w tym realistyczne zdjęcia, anime, olej, akwarela i wiele innych. Wyniki są przede wszystkim determinowane przez konkretny użyty model AI oraz podane prompty.

Najpierw musisz wybrać model Checkpoint. Model określa podstawowy styl generowanego obrazu, na przykład to, czy będzie on realistyczny, czy kreskówkowy. Możesz wyszukiwać i pobierać odpowiednie modele z platform społecznościowych, takich jak Hugging Face, a następnie dopracować je mniejszymi modelami.

Pytanie 5. Czy mogę używać Stable Diffusion do celów komercyjnych?

Tak, możesz używać Stable Diffusion do celów komercyjnych. Prosimy jednak o sprawdzenie szczegółowych warunków korzystania z wersji Stable Diffusion na oficjalnej stronie internetowej. Zasady mogły się różnić w zależności od wersji modelu. Ponadto należy upewnić się, że planowane wykorzystanie komercyjne nie narusza zakazanych działań określonych w licencji. Należy również pamiętać o potencjalnym braku ochrony praw autorskich dla generowanych obrazów.

Wniosek

Ta recenzja Stable Diffusion daje ci szczegółowe wprowadzenie do modelu generowania obrazów z tekstu firmy Stability AI, ze szczególnym uwzględnieniem najnowszego modelu Stable Diffusion 3.5. Dzięki recenzji powinieneś mieć jasny obraz jego możliwości, wydajności, mocnych i słabych stron. Po przeczytaniu tego wpisu powinieneś dokładnie wiedzieć, co Stable Diffusion może dla ciebie zrobić i czy jest warte twojego czasu.

Czy uznałeś to za pomocne?

477 głosów

Aiseesoft AI Photo Editor to zaawansowana aplikacja komputerowa przeznaczona do ulepszania, skalowania i wycinania zdjęć.