自從開創性的 Llama 1 發布以來,封閉的專有 API 已不可逆轉地走向大眾化。 Meta 的開源 Llama(大型語言模型 Meta AI)系列重塑了 AI 格局。功能強大的 Llama 3 及其最新發布的 Llama 4 使該模型系列成為開源 AI 創新的基礎。

如果你正被無數 AI 模型搞得一頭霧水,不妨閱讀這篇全面的Llama 評測。你可以了解 Llama 是什麼、Llama AI 有何獨特之處、它在商業上的強大價值、與 ChatGPT 等巨頭相比的競爭地位、企業實戰指南等內容。

目錄

Llama 指的是一系列由 Meta 開發的基礎大型語言模型。與以往只能透過 API 存取的模型不同,Llama 系列是以公開方式釋出,可用於研究與商業用途。確實,Meta 設計了自訂授權條款,用來防止濫用,並在特定規模條件下適用。目前的最新版本是 Llama 4。

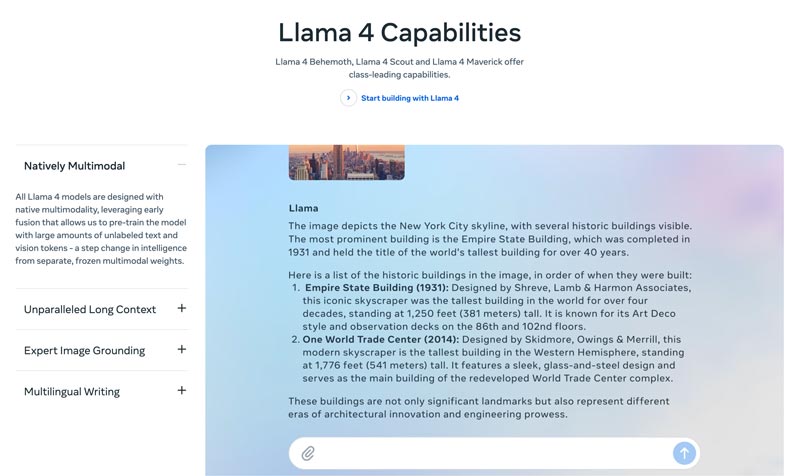

Llama 4 是最新版本。Meta 聲稱這是最智慧、最具延展性、也最方便使用的一版。憑藉更先進的推理與規劃能力、多模態功能,以及多語言寫作能力,Llama 4 可以成為業界領先的上下文視窗方案。它讓你可以透過 Llama API 和 Llama Stack 輕鬆部署你最具創意的點子。目前的 Llama 4 能帶來更個人化的體驗。

Llama 3 於 2024 年 4 月發佈。與 Llama 2 相比,Llama 3 在多方面有所提升,包括更強的推理與程式碼能力、更佳的訓練資料、更大的上下文視窗,以及更高效率的分詞器。

Llama 1 & 2:最初版的 Llama 於 2023 年初推出,而 Llama 2 則於 2023 年 7 月發佈。這兩個版本標誌著 Meta 正式進軍聊天機器人領域。從 Llama 2 開始,透過微調變體,該系列能提供有用且安全的對話體驗。Llama 1/2 主要是為了正面挑戰 OpenAI 的 ChatGPT 和 Google 的 Bard 而開發。

Llama 由 Meta 開發,旨在重塑 AI 版圖,因此高效能並不會成為你的顧慮。Llama 可以基於你公司特定資料進行微調,在特定任務上優於體量更大的通用模型。這種易於微調的特性,使其非常適合多數開發者與研究人員。

Llama 的獨特之處不僅在於效能。由 Llama 催生出的生態系統更可能成為巨大優勢。其在 Hugging Face 上的生態系統引發了創新的爆炸成長。數以千計的微調衍生模型被用於各種可想像的任務。

此外,Llama 讓人人都能掌握頂尖的 LLM。這種AI 的民主化也是讓 Llama 與眾不同的另一個優點。Llama AI 模型對所有研究人員、開發者與新創公司開放使用與創新,無需支付 API 費用或事先取得許可。

企業的策略優勢。Llama 讓你能掌握自家 AI 建設的所有權。你不再需要被供應商的定價策略、政策變動或 API 停用所綁架,從而有效避免廠商鎖定。

Llama 的商業案例不僅僅是使用不同的 AI 模型。事實上,它可以徹底改變一家公司對待 AI 的方式。

在早期,許多企業採用的是以 API 為基礎的服務,例如 OpenAI 的 GPT-4。這樣做是最方便的選擇之一,能夠支持低門檻試驗以及快速原型開發。不過,這種 AI 策略已逐漸被更具戰略性、長期性的做法取代,也就是以 Meta 的 Llama 等開源基礎模型為核心。Llama 的論點主要建立在三個關鍵因素之上:成本節省、控制與客製化,以及資料安全。

許多公司(每天處理數百萬個查詢)的 API 成本每年可能高達數百萬美元。部署 Llama 意味著從營運支出 (OpEx) 轉向資本支出 (CapEx)。這使得高流量情況下的投資報酬率 (ROI) 更加清晰。

Llama 讓您能夠創建最適合您的業務或產品的獨特 AI。您也可以完全控制模型的輸入和輸出。它將成為您的核心資產,而非一項租賃服務。

政府和金融機構對資料治理有嚴格的要求。 Llama 可以完全部署在本地,也可以部署在合規的 VPC(虛擬私有雲)中。這通常是利用 LLM 技術的唯一合法途徑。此外,在安全的 VPC 中部署 Llama 意味著您的所有資料都受到保護,並且永遠不會離開防火牆。這有效地消除了第三方資料外洩的風險。

總而言之,Llama 的商業價值關鍵在於所有權。你得以重新掌控自身競爭優勢、資料安全,以及成本。

Meta 的 Llama 為企業運用 AI 提供了一條新路。這款強大的 AI 模型擁有廣泛的應用場景,包括對話式 AI、影像與文字生成、語言訓練、摘要整理,以及其他相關任務。透過先進的 AI 能力,Llama 能幫助企業推動成功。

• 客戶服務與支援

由 Llama 提供支援的高級聊天機器人或虛擬助理可以更好地理解客戶的問題,尤其是複雜的查詢,並提供正確的、符合情境的答案。這對於提供全天候客戶支援大有裨益。

• 資料分析與商業智慧

Llama 可以從各種來源提取數據,並做出最初需要技術技能才能做出的決策。它允許業務經理和分析師透過提問來獲取 SQL 查詢。該模型可以分析文字、圖像、圖表和其他內容,並給出敘述性摘要。這有助於快速識別新興趨勢、競爭洞察和常見投訴。

• 行銷與內容自動化

製作高品質且經過 SEO 優化的內容非常耗時。 Llama 可以快速產生包含簡單主題和多個關鍵字的草稿或完整文章。之後,人工編輯可以對這些結果進行最佳化。該模型還可以自動建立社交媒體貼文。此外,它還可以幫助撰寫引人入勝的電子郵件和廣告主題。

• 軟體開發

特定於程式碼的 Llama 模型可以充當進階自動完成功能,以維護程式碼品質、管理舊系統並加快開發週期。它可以幫助審查程式碼中的潛在錯誤。此外,它還可以根據原始程式碼註釋自動產生和更新程式碼文件和 API 參考。

本節以表格並列比較了 Meta 的 Llama 系列與其他領先替代產品。您可以比較這些關鍵因素,找到最符合您特定需求的產品。

需要明確的是,這些AI模型各有優缺點。選擇並非在於找到單一的選項。

| 人工智慧模型 | Meta 的 LLaMA 4/3/2 | OpenAI 的 GPT-4 | Anthropic 的《克勞德 3》 | 谷歌的PaLM 2 |

| 執照 | 開源、自訂許可證 | 所有權 | 所有權 | 所有權 |

| 使用權 | 下載並自行託管 | 僅限 API 透過訂閱訪問 | 僅限 API 透過基於使用情況的定價訪問 | 僅限 API 透過 Google 的 Vertex AI 訪問 |

| 人工智慧模型 | Meta 的 LLaMA 4/3/2 | OpenAI 的 GPT-4 | Anthropic 的《克勞德 3》 | 谷歌的PaLM 2 |

| 表現 | 頂級 與頂級 AI 模型競爭 需要微調才能匹配 GPT-4 在特定任務上的表現 無法提供引人入勝的高品質創意內容 | 產業領導者 處理複雜的推理、細微差別和創意解決問題 | 頂級 擅長數據分析、複雜對話和長上下文推理 | 頂級 擅長推理和多語言任務 |

| 成本結構 | 高資本支出,低營運支出 成本隨模型大小和使用量而變化 | 無資本支出,高營運支出 初始成本,但使用時按代幣付費 | 無資本支出,高營運支出 與 OpenAI 類似,按代幣付費 | 無資本支出,高營運支出 Vertex AI 按代幣付費,並提供批量折扣 |

| 資料隱私和安全 | 最大控制 數據永遠不會離開您的基礎設施,非常適合嚴格監管的行業 | 輸入/輸出資料在 OpenAI 的伺服器上處理 | 強大的隱私權政策,但資料由 Anthropic 處理 | 企業級安全性 在 Google Cloud 上處理的資料 提供 VPC 控制和資料駐留承諾 |

| 客製化與控制 | 完全控制 可根據專有資料進行完全微調 | 有限的 微調僅適用於較舊的型號(不適用於 GPT-4) | 有限的 透過快速工程和上下文進行定制 | 強的 對微調和強化學習有良好的支持 |

| 可擴展性 | 您需要配置和管理自己的基礎設施 | OpenAI 管理所有基礎設施 | Anthropic 管理所有基礎設施 | Google Cloud 管理基礎架構 |

總體而言,Llama 非常適合那些希望擁有完全控制權、資料隱私和可自訂性的公司。 GPT-4 最適合那些需要最高原始效能和推理能力的企業。它能夠更好地處理複雜任務,尤其是創造性和高階分析。 Claude 3 非常適合那些安全性和減少偏見至關重要的應用。它很少產生有害的輸出。 PaLM 2 最適合那些深度融入 Google Cloud 生態系統的企業。它確保與其他 Google 工具無縫整合。

在部署 Llama 之前,您應該先根據具體用例明確您的需求。您需要 70B 參數模型來實現最高品質的效果,還是只需要 8B 模型來完成基本任務?

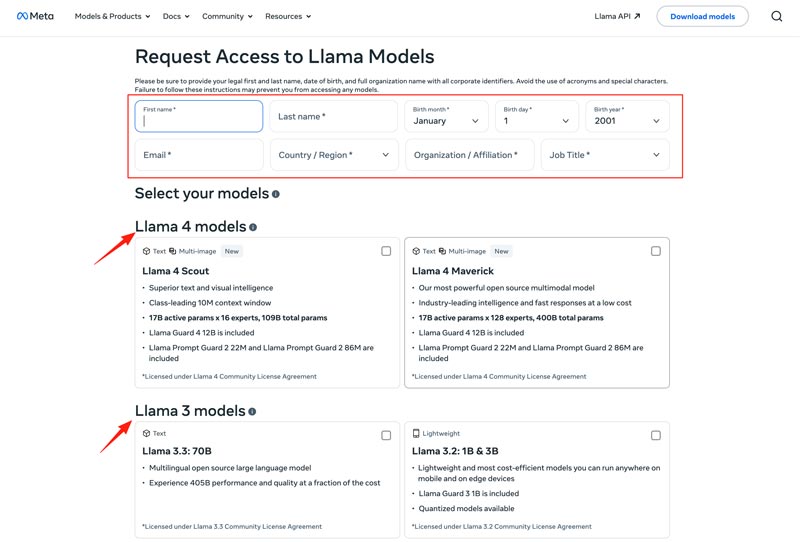

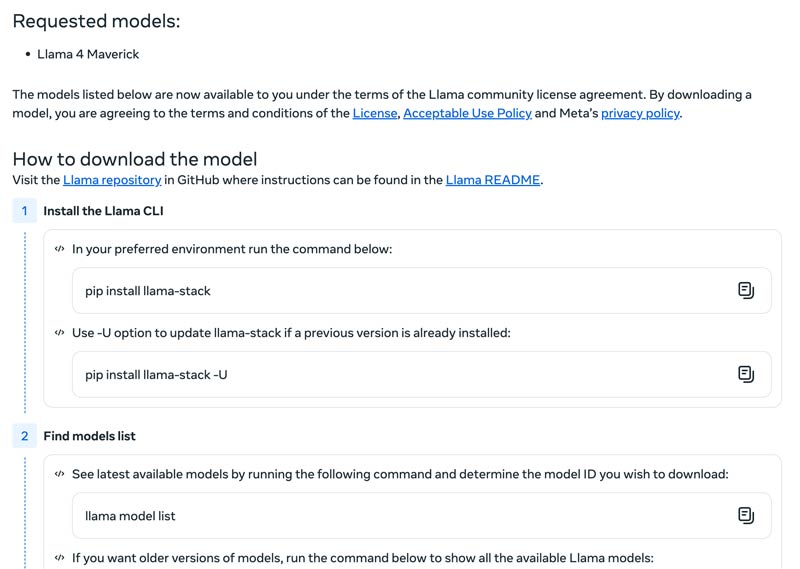

您應該選擇部署方式,例如本機、雲端虛擬機器或託管服務。高效運行 Llama 模型通常需要強大的 GPU,尤其是較大的型號。之後,您可以從 Meta 網站下載正確的模型。

點擊Download Models(下載模型)按鈕,進入Request Access(申請存取)頁面。提供所需資訊並選擇想要的 Llama 模型。

點擊Next(下一步)按鈕閱讀Terms and Conditions(條款與細則)。你應仔細查看《社群授權協議》,然後點擊Accept and Continue(接受並繼續)按鈕。接著依照畫面指示下載你選擇的模型。

你可以使用像 Text Generation Inference 這樣的框架來建立高效能 API 伺服器。如果你需要聊天介面,可以部署像 Chatbot UI 或 NextChat 之類的前端。之後,再結合你的專有資料與這些框架,打造你自己的專用模型。

您應該知道如何克服挑戰以有效地使用 AI 模型。

• 初始設定複雜度

您可以使用其預先建置的工具和容器。只需一個命令即可在本地運行模型。您也可以無需任何本地設定即可使用基於雲端的平台。 Hugging Face 讓您可以使用預先配置的環境來運作和建立簡報。此外,您也可以從 llama.cpp 開始執行量化版本的 Llama。

• 資源管理與成本最佳化

大型模型需要高記憶體 GPU,而這些 GPU 通常稀少且昂貴。

量化是最有效的技術。您可以在推理或微調期間使用 4 位元量化庫。在效能較弱的硬體上,可以使用 llama.cpp 運行模型。這兩種方法都可以有效減少記憶體使用量。此外,請確保為您的任務選擇正確的模型。較小的、經過微調的模型可能更具成本效益。

• 跟進最新版本更新

每週都會發布許多新的模型、技術和函式庫。保持最新狀態可能很難。

你應該訂閱 Meta AI、Hugging Face 和 vLLM 等官方部落格。此外,GitHub 和 Hugging Face 等平台上分享了新的微調技術、應用、效率提升、經驗、解決方案等。這有助於你的團隊整合改進。

你可能也需要:

問題 1:是否允許使用 Llama 模型的輸出來訓練其他 LLM?

是的,Meta 允許使用 Llama 的較新版本(Llama 3.1 及更高版本)的輸出來訓練其他模型。當然,您不得使用它來創建與 Meta 競爭的產品。此外,您必須清楚了解 Meta 許可證所設定的法律界限。

問題 2:Llama 模型是否有使用限制?相關條款是什麼?

是的,Llama 模型受到其許可結構所定義的嚴格限制。這些模型並非真正開源。相反,它們是根據 Meta 的專有許可發布的。這是為了保護 Meta 的利益並防止競爭性用例。

問題 3:Llama 的常見應用場景有哪些?

Llama 的日常用例包括圖像和文件理解、問答、圖像和文字生成、語言生成和摘要、語言訓練、對話 AI 等等。 Llama 可以根據您提供的圖像或文件內容回答您的問題。此外,它還可以用來創建聊天機器人或視覺助理。

問題 4:使用 Llama 模型需要什麼樣的硬體條件?

運行 Llama 模型的硬體需求由三個關鍵因素決定:模型大小、量化和使用案例。對於大多數開發者來說,RTX 4070/4080/4090 或配備 16-36GB 統一記憶體的 Mac 是運行高達 70B 的 Llama 模型的靈活選擇。對於基於 GPU 的操作,最關鍵的因素是顯示卡的 VRAM。如上所述,請根據您的需求選擇正確的模型大小,然後選擇能夠在您的硬體上運行的量化等級。

問題 5:Llama 和 ChatGPT 一樣好嗎?

你可以查看上方的表格,對比 Llama 與 ChatGPT 的關鍵因素。Llama 可在本機離線執行,能提供更安全的資料保護。此外,Llama 模型本身可免費使用。ChatGPT 雖然有免費版本,但其進階模型與功能需要付費方案。

結論

Llama 不只是另一個模型,它常被視為邁向更易取得、可高度客製化之 AI 未來的一次策略轉向。你可以在這篇直截了當的評測中,學到各種與 Llama AI 家族相關的資訊,進而判斷它是否名副其實。

你覺得這有用嗎?

484 票