Pleins feux sur : Chat IA , jeux comme Retro , changement de localisation , Roblox débloqué

Pleins feux sur : Chat IA , jeux comme Retro , changement de localisation , Roblox débloqué

Depuis la sortie révolutionnaire de Llama 1, les API propriétaires fermées ont été irrévocablement démocratisées. La série open source Llama (Large Language Model Meta AI) de Meta a révolutionné le paysage de l'IA. Les très performants Llama 3 et Llama 4, dernière version de Meta, font de cette famille de modèles le fondement de l'innovation en IA open source.

Si vous êtes perdu parmi d’innombrables modèles d’IA, lisez ce test complet de Llama. Vous y découvrirez ce qu’est Llama, ce qui rend Llama AI unique, son argumentaire commercial convaincant, sa position face aux géants comme ChatGPT, un guide pratique pour les entreprises, et bien plus encore.

Table des matières

Llama désigne une collection de grands modèles de langage fondamentaux développés par Meta. Contrairement aux modèles précédents qui ne sont accessibles que via une API, la série Llama est publiée publiquement pour la recherche et un usage commercial. En effet, une licence personnalisée a été conçue pour prévenir les abus, et elle s’applique sous certaines conditions de mise à l’échelle. La dernière version est Llama 4.

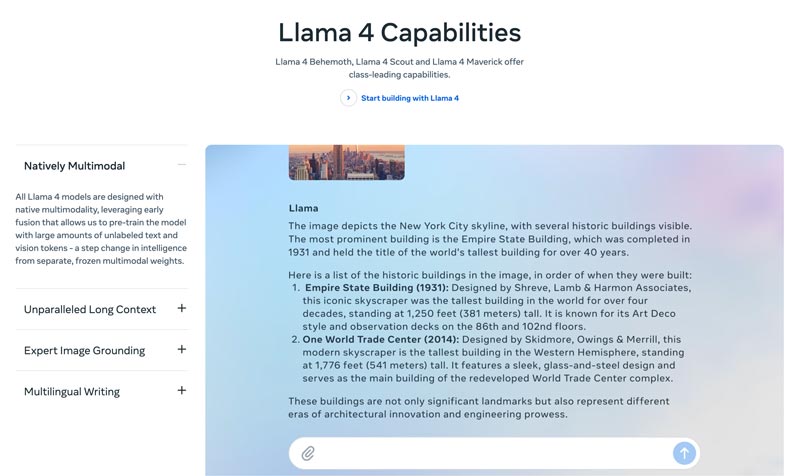

Llama 4 est la dernière version. Meta affirme qu’il s’agit de la version la plus intelligente, la plus extensible et la plus pratique. Grâce à des capacités de raisonnement et de planification plus avancées, des fonctionnalités multimodales et des fonctions de rédaction multilingues, Llama 4 peut offrir une fenêtre de contexte de pointe dans l’industrie. Il vous permet de déployer facilement vos idées les plus ambitieuses avec l’API Llama et la pile Llama (Llama Stack). Le Llama 4 actuel permet des expériences plus personnalisées.

Llama 3 est sorti en avril 2024. Par rapport à Llama 2, Llama 3 apporte plusieurs améliorations, notamment un meilleur raisonnement et de meilleures capacités de programmation, des données d’entraînement améliorées, une fenêtre de contexte plus large et un tokenizer plus efficace.

Llama 1 & 2 : Le Llama original est sorti début 2023, et Llama 2 en juillet 2023. Ils ont marqué l’entrée directe de Meta dans l’arène des chatbots. Avec une variante ajustée (fine-tuned), à partir de Llama 2, la série offre un dialogue utile et sûr. Llama 1/2 est principalement développé pour concurrencer directement ChatGPT d’OpenAI et Bard de Google.

Développé par Meta pour remodeler le paysage de l’IA, la haute performance ne sera pas votre principale préoccupation. Llama est affiné (fine-tuned) sur les données spécifiques de votre entreprise afin de surpasser de plus grands modèles génériques sur des tâches précises. Son potentiel de personnalisation par affinage le rend adapté à la plupart des développeurs et des chercheurs.

Ce qui distingue Llama ne se limite pas à ses performances. L’écosystème engendré par Llama peut être un atout encore plus grand. Son écosystème sur Hugging Face a déclenché une explosion d’innovations. Des milliers de dérivés ajustés sont proposés pour toutes sortes de tâches imaginables.

De plus, Llama a mis un LLM de tout premier plan entre toutes les mains. La démocratisation de l’IA est un autre avantage qui rend Llama unique. Les modèles Llama AI sont disponibles pour tous les chercheurs, développeurs et startups afin qu’ils puissent les utiliser, innover et construire dessus sans payer de frais d’API ni demander d’autorisation.

Avantage stratégique pour les entreprises. Llama vous permet de garder la maîtrise de vos solutions d’IA. Vous n’avez plus besoin de dépendre des tarifs d’un fournisseur, de ses changements de politique ou de la suppression de ses API. Cela permet d’éviter efficacement l’enfermement propriétaire (vendor lock-in).

L'argument commercial de Llama ne se limite pas à l'adoption d'un modèle d'IA différent. Il peut même s'agir d'un changement fondamental dans la façon dont une entreprise aborde l'IA.

Au début, de nombreuses entreprises ont adopté des services basés sur API, comme GPT‑4 d’OpenAI. Cela peut être l’option la plus pratique, permettant une expérimentation à faible barrière d’entrée et un prototypage rapide. Cependant, cette stratégie d’IA a été remplacée par une approche plus stratégique à long terme, reposant sur des modèles de base open source comme Llama de Meta. Le cas Llama repose sur trois facteurs clés : réduction des coûts, contrôle et personnalisation, et sécurité des données.

Pour de nombreuses entreprises (traitant des millions de requêtes par jour), les coûts des API peuvent atteindre des millions par an. Le déploiement de Llama représente une transition des dépenses opérationnelles (OpEx) vers des dépenses d'investissement (CapEx). Le retour sur investissement est ainsi clairement visible à haut volume.

Llama vous permet de créer une IA optimisée et unique, parfaitement adaptée à votre entreprise ou à vos produits. Vous avez également un contrôle total sur les entrées et les sorties de votre modèle. Il devient un atout essentiel, et non un service loué.

Les administrations publiques et financières ont des exigences strictes en matière de gouvernance des données. Llama peut être déployé entièrement sur site ou dans un VPC (Cloud Privé Virtuel) conforme. C'est souvent le seul moyen légal d'exploiter la technologie LLM. De plus, déployer Llama dans un VPC sécurisé garantit la sécurité de toutes vos données et leur intégrité est assurée par votre pare-feu. Cela élimine efficacement le risque d'exposition de données à des tiers.

En un mot, l’argument commercial en faveur de Llama tient à la propriété. On vous rend la maîtrise de votre avantage concurrentiel, la sécurité de vos données et la maîtrise de vos coûts.

Llama de Meta offre une nouvelle façon pour les entreprises d’utiliser l’IA. Ce puissant modèle d’IA couvre un large éventail d’applications, notamment l’IA conversationnelle, la génération d’images et de textes, l’apprentissage des langues, le résumé de contenu et d’autres tâches connexes. En tirant parti de capacités avancées d’IA, Llama peut aider les entreprises à favoriser leur réussite.

• Service client & support

Les chatbots avancés ou assistants virtuels optimisés par Llama peuvent mieux comprendre les questions des clients, notamment les plus complexes, et fournir des réponses pertinentes et contextuelles. Un support client 24h/24 et 7j/7 est un atout.

• Analyse de données & business intelligence

Llama peut extraire des données de diverses sources et prendre des décisions qui nécessitaient initialement des compétences techniques. Il permet aux responsables commerciaux et aux analystes d'obtenir une requête SQL en posant des questions. Le modèle peut analyser du texte, des images, des graphiques et d'autres contenus pour fournir une synthèse narrative. Cela permet d'identifier rapidement les tendances émergentes, les perspectives concurrentielles et les plaintes courantes.

• Marketing & automatisation de contenu

La production de contenu de qualité et optimisé pour le référencement (SEO) est un processus chronophage. Llama peut générer rapidement des brouillons ou des articles complets sur un sujet simple et plusieurs mots-clés. Les rédacteurs peuvent ensuite affiner ces résultats. Le modèle peut également automatiser la création de publications sur les réseaux sociaux. Il peut également contribuer à la rédaction d'objets percutants pour les e-mails et les publicités.

• Développement logiciel

Un modèle Llama spécifique au code peut servir de saisie semi-automatique avancée pour maintenir la qualité du code, gérer les systèmes existants et accélérer les cycles de développement. Il peut faciliter la vérification du code pour détecter d'éventuels bugs. De plus, il peut générer et mettre à jour automatiquement la documentation du code et les références d'API en fonction des commentaires du code source.

Cette section propose une comparaison, sous forme de tableau, de la série Llama de Meta avec d'autres alternatives de premier plan. Vous pouvez comparer ces facteurs clés pour trouver la solution la mieux adaptée à vos besoins spécifiques.

Il est clair que ces modèles d'IA ont leurs propres forces et faiblesses. Le choix ne se résume pas à une seule option.

| Modèles d'IA | LLaMA de Meta 4/3/2 | GPT-4 d'OpenAI | Claude 3 d'Anthropic | PaLM 2 de Google |

| Licence | Licence open source personnalisée | Propriétaire | Propriétaire | Propriétaire |

| Accéder | Télécharger et auto-héberger | API uniquement Accès par abonnement | API uniquement Accès via une tarification basée sur l'utilisation | API uniquement Accès via Vertex AI de Google |

| Modèles d'IA | LLaMA de Meta 4/3/2 | GPT-4 d'OpenAI | Claude 3 d'Anthropic | PaLM 2 de Google |

| Performance | Haut de gamme Concurrentiel avec les meilleurs modèles d'IA Nécessite un réglage précis pour correspondre aux performances de GPT-4 sur des tâches spécifiques Manque de contenu créatif engageant et de haute qualité | Leader de l'industrie Gérer le raisonnement complexe, les nuances et la résolution créative de problèmes | Haut de gamme Excellent en analyse de données, dialogue sophistiqué et raisonnement à long terme | Haut de gamme Excellent en raisonnement et dans les tâches multilingues |

| Structure des coûts | CapEx élevé, OpEx faible Échelles de coûts en fonction de la taille du modèle et du volume d'utilisation | Pas de CapEx, pas de OpEx élevé coût initial, mais paiement par jeton pour l'utilisation | Pas de CapEx, OpEx élevé Similaire à OpenAI, paiement par jeton | Pas de CapEx, OpEx élevé Paiement par jeton sur Vertex AI, avec remises sur volume |

| Confidentialité et sécurité des données | Contrôle maximal Les données ne quitteront jamais votre infrastructure Idéal pour les industries hautement réglementées | Les données d'entrée/sortie sont traitées sur les serveurs d'OpenAI | Politique de confidentialité stricte, mais les données sont traitées par Anthropic | Sécurité de niveau entreprise Données traitées sur Google Cloud Offre des contrôles VPC et des engagements de résidence des données |

| Personnalisation et contrôle | Contrôle complet Peut être entièrement affiné sur des données propriétaires | Limité Le réglage fin n'est disponible que pour les modèles plus anciens (pas GPT-4) | Limité Personnalisé via une ingénierie rapide et un contexte | Fort Bon support pour le réglage fin et l'apprentissage par renforcement |

| Évolutivité | Vous devez provisionner et gérer votre propre infrastructure | OpenAI gère toute l'infrastructure | Anthropic gère toutes les infrastructures | Google Cloud gère l'infrastructure |

De manière générale, Llama est idéal pour les entreprises qui privilégient un contrôle total, la confidentialité des données et la personnalisation. GPT-4 est particulièrement adapté aux entreprises qui exigent des performances brutes et des capacités de raisonnement optimales. Il permet de mieux gérer les tâches complexes, notamment les analyses créatives et avancées. Claude 3 est idéal pour les applications où la sécurité et la réduction des biais sont primordiales. Il produit rarement des résultats nuisibles. PaLM 2 est idéal pour les entreprises profondément intégrées à l'écosystème Google Cloud. Il garantit une intégration transparente avec les autres outils Google.

Avant de déployer Llama, vous devez d'abord déterminer vos besoins en fonction du cas d'utilisation spécifique. Avez-vous besoin du modèle à 70 B paramètres pour une qualité optimale ou simplement du modèle à 8 B pour les tâches de base ?

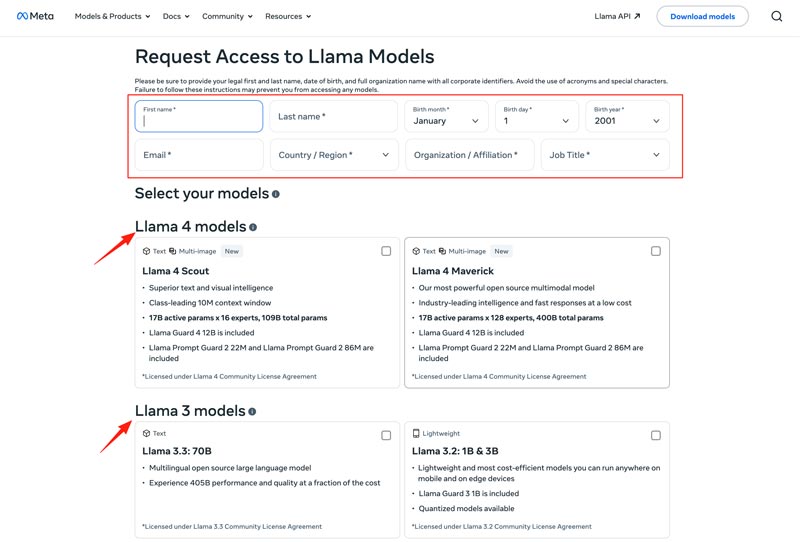

Vous devez choisir votre méthode de déploiement : machine locale, machine virtuelle cloud ou service géré. L'exécution efficace des modèles Llama nécessite souvent un GPU puissant, surtout pour les modèles les plus volumineux. Vous pouvez ensuite télécharger le modèle approprié sur le site web de Meta.

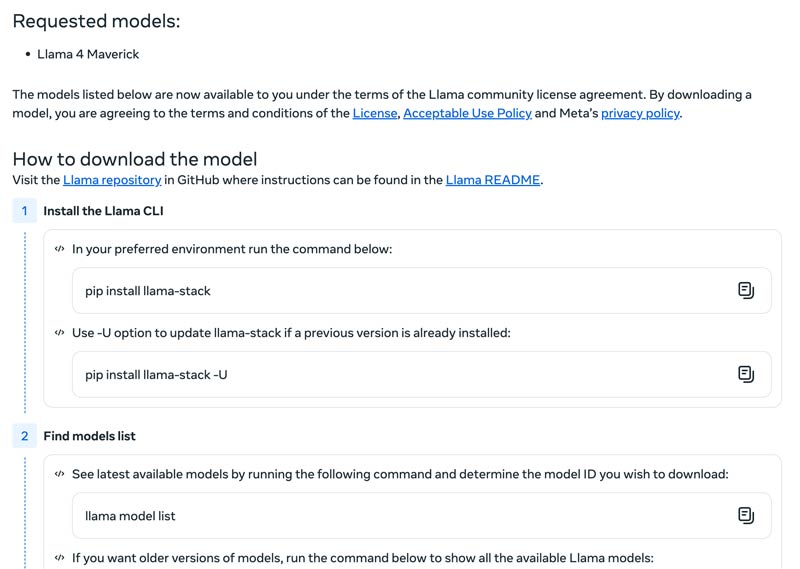

Cliquez sur le bouton Download Models pour accéder à la page Request Access. Fournissez les informations requises et choisissez le modèle Llama souhaité.

Cliquez sur le bouton Next pour lire les Conditions générales. Vous devez vérifier attentivement le Community License Agreement, puis cliquer sur le bouton Accept and Continue. Suivez les instructions à l’écran pour télécharger le modèle que vous avez sélectionné.

Vous pouvez utiliser un framework comme Text Generation Inference pour obtenir un serveur d’API haute performance. Si vous avez besoin d’une interface de chat, déployez une interface comme l’UI Chatbot ou NextChat. Ensuite, utilisez vos données propriétaires avec des frameworks pour créer votre propre modèle spécialisé.

Vous devez savoir comment surmonter les défis pour utiliser efficacement les modèles d’IA.

• Complexité de la configuration initiale

Vous pouvez utiliser ses outils et conteneurs préconfigurés. Exécutez des modèles localement avec une seule commande. Vous pouvez également opter pour des plateformes cloud sans configuration locale. Hugging Face vous permet d'exécuter et de créer des démonstrations dans des environnements préconfigurés. De plus, vous pouvez démarrer avec llama.cpp pour exécuter une version quantifiée de Llama.

• Gestion des ressources & optimisation des coûts

Les grands modèles nécessitent des GPU à haute mémoire, qui sont souvent rares et coûteux.

La quantification est la technique la plus efficace. Vous pouvez utiliser des bibliothèques pour la quantification 4 bits lors de l'inférence ou du réglage fin. Sur un matériel moins puissant, utilisez llama.cpp pour exécuter les modèles. Ces deux méthodes permettent de réduire efficacement l'utilisation de la mémoire. De plus, veillez à sélectionner le modèle adapté à vos tâches. Un modèle plus petit et optimisé peut être plus rentable.

• Rester à jour avec les nouvelles versions

De nombreux nouveaux modèles, techniques et bibliothèques sont publiés chaque semaine. Il peut être difficile de rester à jour.

Abonnez-vous aux blogs officiels comme Meta AI, Hugging Face et vLLM. De plus, de nouvelles techniques d'optimisation, applications, gains d'efficacité, expériences, solutions et bien plus encore sont partagés sur des plateformes comme GitHub et Hugging Face. Cela permet à votre équipe d'intégrer les améliorations.

Vous pourriez aussi avoir besoin de :

Question 1. Est-il permis d’utiliser la sortie des modèles Llama pour entraîner d’autres LLM ?

Oui, Meta autorise l'utilisation des versions plus récentes (Llama 3.1 et ultérieures) des résultats de Llama pour entraîner d'autres modèles. Il est formellement interdit de les utiliser pour créer un produit concurrent de Meta. De plus, vous devez être parfaitement conscient des limites légales imposées par la licence de Meta.

Question 2. Les modèles Llama ont-ils des restrictions ? Quels sont les termes associés ?

Oui, les modèles Llama sont soumis à des restrictions importantes, définies par leur structure de licence. Ces modèles ne sont pas véritablement open source. Ils sont publiés sous une licence propriétaire de Meta. Cette licence vise à protéger les intérêts de Meta et à prévenir les utilisations concurrentes.

Question 3. Quels sont les cas d’usage courants de Llama ?

Les utilisations courantes de Llama incluent la compréhension d'images et de documents, la réponse aux questions, la génération d'images et de textes, la génération et la synthèse de langage, l'apprentissage linguistique, l'IA conversationnelle, et bien plus encore. Llama peut répondre à vos questions en fonction du contenu de l'image ou du document que vous avez fourni. Il peut également être utilisé pour créer un chatbot ou un assistant visuel.

Question 4. Quelles sont les exigences matérielles pour utiliser les modèles Llama ?

La configuration matérielle requise pour exécuter les modèles Llama est déterminée par trois facteurs clés : la taille du modèle, la quantification et le cas d'utilisation. Pour la plupart des développeurs, une carte graphique RTX 4070/4080/4090 ou un Mac avec 16 à 36 Go de mémoire unifiée constitue un choix flexible pour les modèles Llama jusqu'à 70 Go. Pour un fonctionnement basé sur GPU, le facteur le plus crucial est la VRAM de votre carte graphique. Comme indiqué précédemment, sélectionnez la taille du modèle adaptée à vos besoins, puis choisissez le niveau de quantification compatible avec votre matériel.

Question 5. Llama est-il aussi bon que ChatGPT ?

Vous pouvez consulter le tableau ci-dessus pour comparer les facteurs clés entre Llama et ChatGPT. Llama peut être exécuté localement et hors ligne. Il offre une protection des données plus sécurisée. De plus, le modèle Llama lui-même est gratuit. ChatGPT propose une version gratuite, mais ses modèles et fonctionnalités avancés nécessitent un abonnement payant.

Conclusion

Llama n’est pas juste un autre modèle. Il est souvent considéré comme un changement stratégique vers un futur de l’IA plus accessible et plus personnalisable. Vous pouvez découvrir diverses informations liées à la famille Llama AI dans ce test sans fioritures, puis déterminer si elle mérite l’engouement qu’elle suscite.

Avez-vous trouvé ceci utile?

484 votes