Søkelys: AI-chat , spill som Retro , stedsbytter , Roblox opphevet blokkering

Søkelys: AI-chat , spill som Retro , stedsbytter , Roblox opphevet blokkering

Siden den banebrytende lanseringen av Llama 1 har de lukkede, proprietære API-ene blitt ugjenkallelig demokratisert. Metas åpen kildekode-serie Llama (Large Language Model Meta AI) har omformet AI-landskapet. Den svært kapable Llama 3 og den nyeste Llama 4 gjør denne modellfamilien til grunnlaget for åpen kildekode-innovasjon innen AI.

Hvis du er forvirret av utallige KI‑modeller, kan du lese denne omfattende Llama‑omtalen. Du kan lære hva Llama er, hva som gjør Llama KI unik, dens overbevisende forretningscase, den konkurransemessige posisjonen mot giganter som ChatGPT, en praktisk veiledning for virksomheter og mer.

Innholdsfortegnelse

Llama viser til en samling grunnleggende store språkmodeller utviklet av Meta. I motsetning til tidligere modeller som bare kan nås via API, er Llama‑serien offentliggjort for forskning og kommersiell bruk. En egen lisens er utformet for å forhindre misbruk, og den gjelder under spesifikke skaleringsvilkår. Den nyeste versjonen er Llama 4.

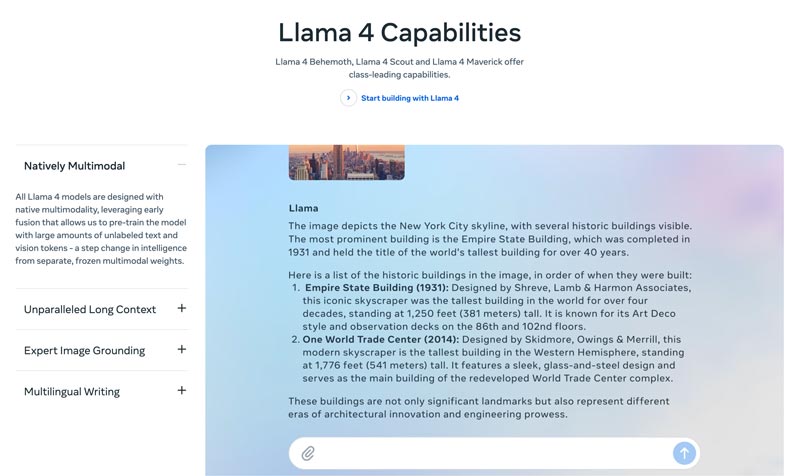

Llama 4 er den nyeste versjonen. Meta hevder at det er den mest intelligente, skalerbare og brukervennlige versjonen. Med mer avanserte resonnement‑ og planleggingsevner, multimodale funksjoner og flerspråklige skrivefunksjoner kan Llama 4 være bransjeledende når det gjelder kontekstvindu. Den lar deg enkelt distribuere dine mest fantastiske ideer med Llama API og Llama Stack. Dagens Llama 4 muliggjør mer personlige opplevelser.

Llama 3 ble lansert i april 2024. Sammenlignet med Llama 2 har Llama 3 flere forbedringer, blant annet forbedret resonnement og koding, bedre treningsdata, et større kontekstvindu og en mer effektiv tokeniser.

Llama 1 og 2: Den opprinnelige Llama ble lansert tidlig i 2023, og Llama 2 ble lansert i juli 2023. De markerte Metas direkte inntreden i chatbot‑arenaen. Med en fintunet variant har serien siden Llama 2 levert en hjelpsom og trygg dialog. Llama 1/2 er hovedsakelig utviklet for å utfordre OpenAIs ChatGPT og Googles Bard direkte.

Utviklet av Meta for å omforme KI‑landskapet, vil høy ytelse ikke være et problem for deg. Llama finjusteres på din bedrifts spesifikke data for å overgå større generiske modeller for bestemte oppgaver. Det store potensialet for finjustering gjør den egnet for de fleste utviklere og forskere.

Llamas egenart ligger ikke bare i ytelsen. Økosystemet som Llama har skapt kan være en enda større fordel. Økosystemet på Hugging Face har utløst en eksplosjon av innovasjon. Tusenvis av fintunede avledede modeller tilbys for alle tenkelige oppgaver.

Dessuten har Llama lagt et toppnivå LLM i alles hender. Demokratiseringen av KI er en annen fordel som gjør Llama unik. Llama KI‑modeller er tilgjengelige for alle forskere, utviklere og oppstartsbedrifter til å bruke, innovere og bygge på uten å betale API‑avgifter eller be om tillatelse.

Strategisk fordel for virksomheter. Med Llama eier du selv din KI‑utvikling. Du trenger ikke lenger å være bundet til en leverandørs priser, retningslinjeendringer eller utfasete API‑er. Det unngår effektivt leverandørlåsing.

Forretningsargumentet for Llama handler ikke bare om å bruke en annen AI-modell. Faktisk kan det være en fundamental endring i hvordan et selskap håndterer AI.

I begynnelsen tok mange virksomheter i bruk API‑baserte tjenester som OpenAIs GPT‑4. Det kan være det mest praktiske alternativet, som muliggjør eksperimentering med lav terskel og rask prototyping. Denne KI‑strategien er imidlertid blitt erstattet av en mer strategisk, langsiktig tilnærming: åpne grunnmodeller som Metas Llama. Llama‑caset hviler på tre nøkkelfaktorer: kostnadsbesparelser, kontroll og tilpasning, og datasikkerhet.

API-kostnadene for mange selskaper (som behandler millioner av spørringer per dag) kan beløpe seg til millioner årlig. Implementering av Llama er et skifte fra driftsutgifter (OpEx) til kapitalutgifter (CapEx). Det gir tydelig avkastning på investeringen ved høye volum.

Med Llama kan du lage en unik, finjustert AI som passer best til bedriften eller produktene dine. Du har også full kontroll over modellens input og output. Den blir en kjerneressurs, ikke en leid tjeneste.

Myndigheter og finans har strenge krav til datastyring. Llama kan distribueres fullt ut lokalt eller i en kompatibel VPC (Virtual Private Cloud). Det er ofte den eneste lovlige måten å utnytte LLM-teknologi på. Dessuten betyr det å distribuere Llama i en sikker VPC at alle dataene dine er sikret og aldri forlater brannmuren din. Det eliminerer effektivt risikoen for dataeksponering fra tredjeparter.

Kort sagt handler forretningscaset for Llama om eierskap. Du får tilbake eierskapet til din konkurransefordel, sikkerheten til dataene dine og kostnadene dine.

Metas Llama gir virksomheter en ny måte å bruke KI på. Denne kraftige KI‑modellen har et bredt spekter av bruksområder, inkludert konversasjons‑KI, bilde‑ og tekstgenerering, språkopplæring, oppsummering og andre relaterte oppgaver. Ved å bruke avanserte KI‑muligheter kan Llama hjelpe virksomheter å skape suksess.

• Kundeservice og brukerstøtte

Avanserte chatboter eller virtuelle assistenter drevet av Llama kan bedre forstå kundenes spørsmål, spesielt komplekse forespørsler, og gi korrekte, kontekstbevisste svar. Det er fordelaktig å tilby kundestøtte døgnet rundt.

• Dataanalyse og forretningsinnsikt

Llama kan hente data fra ulike kilder og ta beslutninger som i utgangspunktet krevde tekniske ferdigheter. Det lar forretningsledere og analytikere få en SQL-spørring ved å stille spørsmål. Modellen kan analysere tekst, bilder, diagrammer og annet innhold for å gi et narrativt sammendrag. Det bidrar til å raskt identifisere nye trender, konkurranseinnsikt og vanlige klager.

• Markedsføring og innholdsautomatisering

Prosessen med å produsere innhold av høy kvalitet og SEO-optimalisert er tidkrevende. Llama kan raskt generere utkast eller hele artikler med et enkelt emne og flere nøkkelord. Menneskelige redaktører kan deretter forbedre disse resultatene. Modellen kan også automatisere opprettelsen av innlegg på sosiale medier. Dessuten kan den bidra til å skrive overbevisende emnelinjer for e-poster og annonser.

• Programvareutvikling

En kodespesifikk Llama-modell kan fungere som en avansert autofullføringsmetode for å opprettholde kodekvalitet, administrere eldre systemer og akselerere utviklingssykluser. Den kan bidra til å gjennomgå kode for potensielle feil. Dessuten kan den automatisk generere og oppdatere kodedokumentasjon og API-referanser basert på kildekodekommentarer.

Denne delen gir en side-ved-side-sammenligning av Metas Llama-serie med andre ledende alternativer i tabellformat. Du kan sammenligne disse nøkkelfaktorene for å finne den som passer best til dine spesifikke behov.

Det bør være tydelig at disse AI-modellene har sine egne styrker og svakheter. Valget handler ikke om å finne ett enkelt alternativ.

| AI-modeller | Metas LLaMA 4/3/2 | OpenAIs GPT-4 | Antropisk Claude 3 | Googles PaLM 2 |

| Tillatelse | Åpen kildekode, tilpasset lisens | Proprietær | Proprietær | Proprietær |

| Adgang | Last ned og lag din egen hosting | Kun API Tilgang via abonnement | Kun API Tilgang via bruksbasert prising | Kun API Tilgang via Googles Vertex AI |

| AI-modeller | Metas LLaMA 4/3/2 | OpenAIs GPT-4 | Antropisk Claude 3 | Googles PaLM 2 |

| Opptreden | Toppnivå Konkurransedyktig med topp AI-modeller Krever finjustering for å matche GPT-4-ytelsen på spesifikke oppgaver Mangler å levere engasjerende kreativt innhold av høy kvalitet | Bransjeleder Håndtere kompleks resonnering, nyanser og kreativ problemløsning | Toppnivå Utmerket på dataanalyse, sofistikert dialog og lang kontekstbasert resonnering | Toppnivå Utmerket i resonnering og flerspråklige oppgaver |

| Kostnadsstruktur | Høye investeringskostnader, lave driftskostnader Kostnadsskalaer med modellstørrelse og bruksvolum | Ingen investeringskostnader, høy driftskostnader startkostnad, men betaling per token for bruk | Ingen investeringskostnader, høy driftskostnader I likhet med OpenAI, betal-per-token | Ingen investeringskostnader, høy driftskostnader Betal per token på Vertex AI, med volumrabatter |

| Datavern og sikkerhet | Maksimal kontroll Data vil aldri forlate infrastrukturen din. Ideelt for strengt regulerte bransjer. | Input/output-data behandles på OpenAIs servere | Strenge retningslinjer for personvern, men dataene behandles av Anthropic | Sikkerhet i bedriftsklassen Data behandlet på Google Cloud Tilbyr VPC-kontroller og forpliktelser til datalagring |

| Tilpasning og kontroll | Full kontroll Kan finjusteres fullstendig på proprietære data | Begrenset Finjustering er bare tilgjengelig for eldre modeller (ikke GPT-4) | Begrenset Tilpasset via rask konstruksjon og kontekst | Sterk God støtte for finjustering og forsterkende læring |

| Skalerbarhet | Du må klargjøre og administrere din egen infrastruktur | OpenAI administrerer all infrastruktur | Anthropic administrerer all infrastruktur | Google Cloud administrerer infrastrukturen |

Generelt sett er Llama ideelt for bedrifter som foretrekker full kontroll, databeskyttelse og tilpasningsmuligheter. GPT-4 passer best for bedrifter som krever høyest mulig rå ytelse og resonneringsevner. Den kan bedre håndtere komplekse oppgaver, spesielt kreativ og avansert analyse. Claude 3 er ideelt for applikasjoner der sikkerhet og redusert skjevhet er avgjørende. Den produserer sjelden skadelige resultater. PaLM 2 passer best for bedrifter som er dypt integrert i Google Cloud-økosystemet. Den sikrer en sømløs integrasjon med andre Google-verktøy.

Før du distribuerer Llama, bør du først finne ut hva du trenger i henhold til det spesifikke brukstilfellet. Trenger du 70B-parametermodellen for maksimal kvalitet eller bare 8B-modellen for grunnleggende oppgaver?

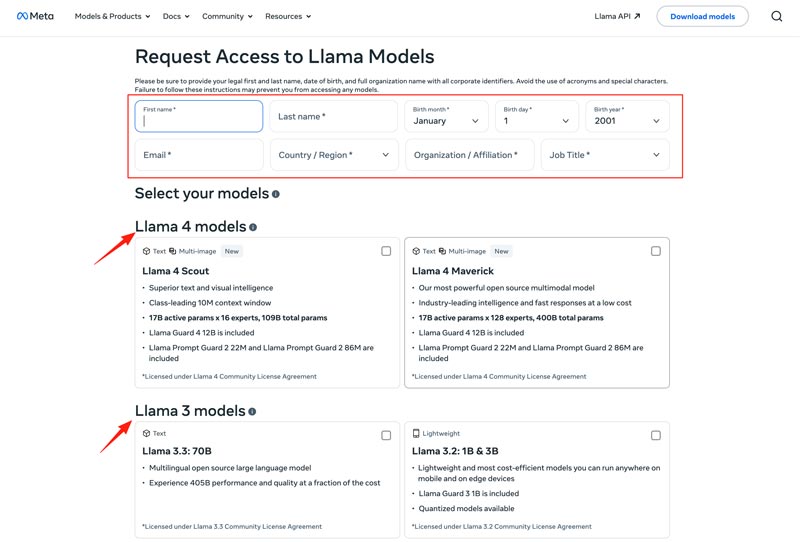

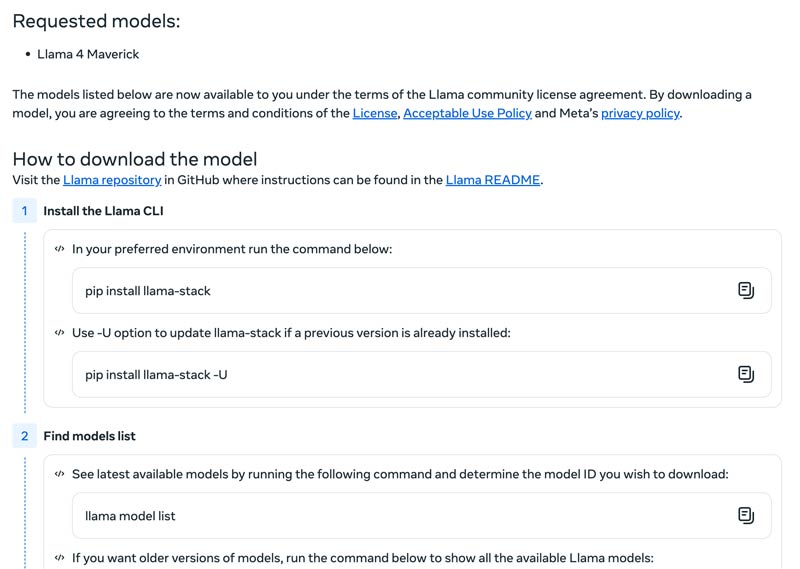

Du bør velge distribusjonsmetode, for eksempel en lokal maskin, skybasert virtuell maskin eller administrert tjeneste. Å kjøre Llama-modeller effektivt krever ofte en kraftig GPU, spesielt for de større modellene. Etter det kan du laste ned riktig modell fra Meta-nettstedet.

Klikk på knappen Download Models for å gå til siden Request Access. Oppgi nødvendig informasjon og velg ønsket Llama‑modell.

Klikk på knappen Next for å lese Terms and Conditions. Du bør lese Community License Agreement nøye og deretter klikke på knappen Accept and Continue. Følg instruksjonene på skjermen for å laste ned den valgte modellen.

Du kan bruke et rammeverk som Text Generation Inference for å få en høyytelses API‑server. Hvis du trenger et chatgrensesnitt, kan du distribuere et brukergrensesnitt som Chatbot UI eller NextChat. Deretter bruker du dine egne data sammen med rammeverkene for å skape din egen spesialiserte modell.

Du bør vite hvordan du overvinner utfordringer for å bruke AI-modeller effektivt.

• Innledende oppsettkompleksitet

Du kan bruke de forhåndsbygde verktøyene og containerne. Kjør modeller lokalt med én kommando. Du kan også bruke skybaserte plattformer uten lokal oppsett. Med Hugging Face kan du kjøre og lage demoer ved hjelp av forhåndskonfigurerte miljøer. Dessuten kan du starte med llama.cpp for å kjøre en kvantisert versjon av Llama.

• Ressursstyring og kostnadsoptimalisering

Store modeller krever GPU-er med mye minne, som ofte er knappe og kostbare.

Kvantisering er den mest effektive teknikken. Du kan bruke biblioteker for 4-bit kvantisering under inferens eller finjustering. På mindre kraftig maskinvare kan du bruke llama.cpp til å kjøre modeller. Begge metodene kan effektivt redusere minnebruken. Sørg i tillegg for at du velger riktig modell for oppgavene dine. En mindre, finjustert modell kan være mer kostnadseffektiv.

• Å holde seg oppdatert på nye utgivelser

Mange nye modeller, teknikker og biblioteker lanseres ukentlig. Det kan være vanskelig å holde seg oppdatert.

Du bør abonnere på offisielle blogger som Meta AI, Hugging Face og vLLM. I tillegg deles nye finjusteringsteknikker, applikasjoner, effektivitetsgevinster, erfaringer, løsninger og mer på plattformer som GitHub og Hugging Face. Det lar teamet ditt integrere forbedringer.

Du kan også trenge:

Spørsmål 1. Er det tillatt å bruke utdata fra Llama‑modellene til å trene andre LLM‑er?

Ja, Meta har tillatelse til å bruke nyere versjoner (Llama 3.1 og senere) av Llamas output til å trene andre modeller. Du har selvsagt ikke lov til å bruke det til å lage et produkt som konkurrerer med Meta. Dessuten må du være svært klar over de juridiske grensene som er satt av Metas lisens.

Spørsmål 2. Har Llama‑modellene begrensninger? Hva er de tilhørende vilkårene?

Ja, Llama-modeller har betydelige restriksjoner, definert av lisensstrukturen deres. Disse modellene er ikke helt åpen kildekode. I stedet er de utgitt under en proprietær lisens fra Meta. Dette er for å beskytte Metas interesser og forhindre konkurransepregede brukstilfeller.

Spørsmål 3. Hva er vanlige bruksområder for Llama?

Daglige bruksområder for Llama inkluderer forståelse av bilder og dokumenter, svar på spørsmål, generering av bilder og tekst, språkgenerering og -oppsummering, språkopplæring, samtale-AI og mer. Llama kan svare på spørsmålet ditt basert på bilde- eller dokumentinnholdet du har oppgitt. Dessuten kan den brukes til å lage en chatbot eller en visuell assistent.

Spørsmål 4. Hva er maskinvarekravene for å bruke Llama‑modeller?

Maskinvarekravene for å kjøre Llama-modeller bestemmes av tre nøkkelfaktorer: modellstørrelse, kvantisering og brukstilfelle. For de fleste utviklere er en RTX 4070/4080/4090 eller en Mac med 16–36 GB Unified Memory et fleksibelt valg for Llama-modeller opptil 70 MB. For GPU-basert drift er den viktigste faktoren VRAM-en til grafikkortet ditt. Som nevnt, velg riktig modellstørrelse basert på dine behov, og velg deretter kvantiseringsnivået som kan kjøre på maskinvaren din.

Spørsmål 5. Er Llama like bra som ChatGPT?

Du kan se i tabellen ovenfor for å sammenligne nøkkelfaktorene mellom Llama og ChatGPT. Llama kan kjøres lokalt og offline. Den tilbyr mer sikker databeskyttelse. Dessuten er selve Llama‑modellen gratis å bruke. ChatGPT har en gratisversjon, men de avanserte modellene og funksjonene krever et betalt abonnement.

Konklusjon

Llama er ikke bare en annen modell. Den blir ofte sett på som et strategisk skifte mot en mer tilgjengelig og tilpassbar KI‑fremtid. Du kan lære forskjellig relatert informasjon om Llama KI‑familien i denne rett‑på‑sak‑omtalen og deretter finne ut om den er verdt oppstyret.

Synes du dette var nyttig?

484 stemmer