Søkelys: AI-chat , spill som Retro , stedsbytter , Roblox opphevet blokkering

Søkelys: AI-chat , spill som Retro , stedsbytter , Roblox opphevet blokkering

Lei av endeløse AI-bildeverktøy?

Stable Diffusion posisjonerer seg som en “frihets”-løsning for AI-basert bildeskaping. Når du søker etter en kraftig tekst-til-bilde‑modell som kan generere bilder av høy kvalitet basert på tekstbeskrivelsene dine, kan du komme over den eller få relaterte anbefalinger.

Men i et raskt voksende felt med lignende modeller og konkurrenter som Midjourney, Seedance og Veo 3, lurer du kanskje på: Er Stable Diffusion verdt tiden din, eller leverer Stable Diffusion virkelig resultater på profesjonell nivå?

Denne omtalen av Stable Diffusion gir all nødvendig informasjon om denne AI‑bildemodellen og besvarer nettopp det spørsmålet.

Innholdsfortegnelse

Stable Diffusion er en fleksibel deep learning‑basert tekst‑til‑bilde‑modell utviklet av Stability AI. Den er basert på diffusjonsteknologi (lansert i 2022) som kan omdanne tekstbeskrivelser til visuelle framstillinger. Modellen bruker en CLIP ViT-L/14‑tekstkoder for å generere bilder av høy kvalitet som svar på forespørsler (prompter).

Sammenlignet med tidligere diffusjonsmodeller reduserer den nyeste Stable Diffusion 3.5 minnekravene betydelig. Den er designet med en flott arkitektonisk innovasjon ved å implementere diffusjonsprosessen i et latent rom. Tidligere modeller opererer direkte i bilderommet.

Takket være det tekniske gjennombruddet og dens åpen kildekode-natur har Stable Diffusion snart tiltrukket seg en mye bredere brukerbase, inkludert utviklere, forskere, individuelle skapere og bedriftsbrukere.

• Kontinuerlig forbedring med versjonsoppdateringer. Siden den første utgaven har denne tekst‑til‑bilde‑modellen gjennomgått en betydelig utvikling. Hovedversjonene inkluderer Stable Diffusion 1.5, 2.0, 2.1, 3.0 og den nyeste 3.5‑serien. De har gitt betydelige forbedringer på flere områder, inkludert bildekvalitet, forståelse av promper og genereringsevner, blant annet.

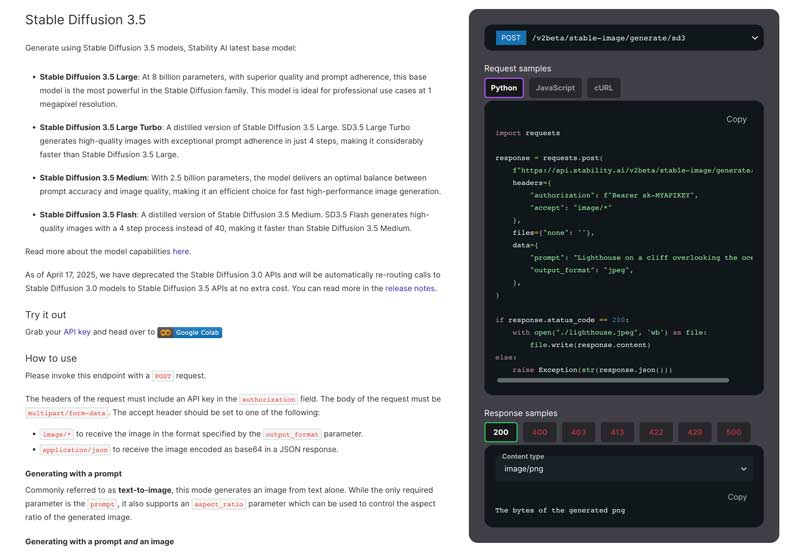

• Flere modellversjoner. Flere spesialiserte modeller er utviklet for å dekke ulike brukerbehov. Den nyeste basismodellen er Stable Diffusion 3.5. Den tilbyr vesentlige forbedringer sammenlignet med tidligere versjoner. Det finnes for tiden fire hovedversjoner i Stable Diffusion‑familien: Stable Diffusion 3.5 Large, Large Turbo, Medium og Flash.

• Avansert forståelse av promper. Dagens Stable Diffusion 3.5 har en sofistikert arkitektur med flere tekstkodere som gjør det mulig å behandle mer komplekse og detaljerte promper mer effektivt. Den kan behandle tekstbeskrivelser på opptil 10 000 tegn. Dette gjør at brukere kan gi mer detaljerte beskrivelser. Samtidig kan Stable Diffusion produsere resultater av høyere kvalitet og større nøyaktighet.

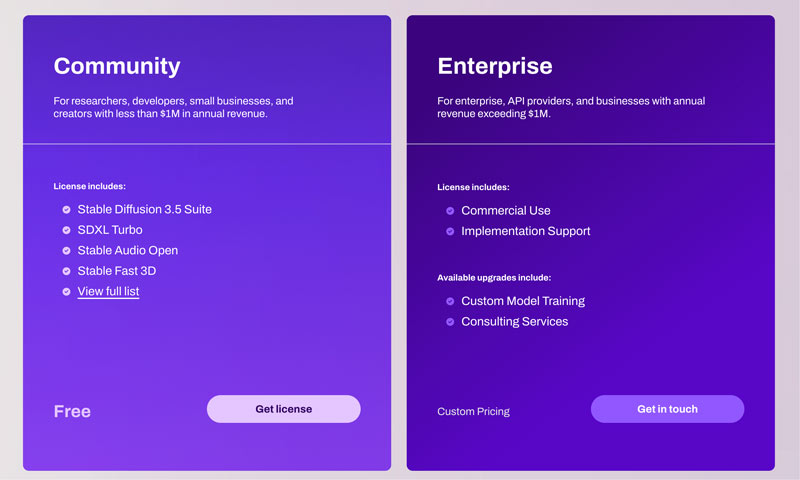

• Kommersiell og kreativ fleksibilitet. Stable Diffusion 3.5‑modellene er utgitt under Stability AI Community License og Enterprise License. Det tillater både kommersiell og ikke‑kommersiell bruk. For de fleste vanlige brukere, som forskere, utviklere og små bedrifter med en årlig omsetning på mindre enn $1M, kan Stable Diffusion brukes fritt uten begrensninger. Brukere kan fritt tilpasse KI‑en til sine spesifikke behov og kunstneriske stiler.

Som nevnt ovenfor, gjør Stable Diffusions allsidighet den egnet for nesten alle brukere. Både utviklere, forskere, designere, digitale kunstnere, AI-hobbyister og til og med studenter kan få betydelige fordeler av funksjonene.

Den nyeste Stable Diffusion 3.5-modellen har avanserte funksjoner for å generere finere bildedetaljer. Genererte bilder har ofte nøyaktig belysning og motivvalg. Dessuten kan den bedre passe til den spesifikke kunststilen basert på dine instruksjoner.

For de fleste bildegenereringsmodeller kan områder som menneskehender og ansiktstrekk være spesielt utfordrende. Med bruk av en 16-kanals VAE kan disse vanlige artefaktene og ufullkommenhetene effektivt håndteres. Stabil diffusjon er god til å gjengi nøyaktige lyseffekter.

Til tross for disse forbedringene har Stable Diffusion fortsatt sine svakheter. Modellen møter fortsatt visse utfordringer, spesielt i fullkroppsgjengivelser. I likhet med andre AI-bildegenereringsmodeller produserer Stable Diffusion ofte uventede resultater, spesielt når man genererer komplette menneskefigurer. Den nåværende Stable Diffusion 3.5 fungerer bra med nærbilder, portretter og diverse ikke-menneskelige motiver.

Effektiviteten til Stable Diffusion varierer avhengig av den spesifikke modellversjonen som brukes, maskinvare, utdatainnstillinger og ledetekster. Vanligvis kan du med et kraftig NVIDIA GPU enkelt generere et standard 1024x1024-bilde på 5–15 sekunder. Stable Diffusion er bedre enn mange alternativer, og lar brukere trene og finjustere modeller på sine egne datasett. Dette er spesielt verdifullt for profesjonelle brukere.

Sammenlignet med de tidligere modellene er den nåværende Stable Diffusion 3.5 mye enklere å bruke. Men «enkel»-verdien er sterkt relatert til dine tekniske ferdigheter, erfaringsnivå og valgte grensesnitt.

Flere tilnærminger er tilgjengelige for ulike tekniske komfortnivåer. Gå til det offisielle nettstedet til Stability AI, skaff deg en lisens og send deretter en POST-forespørsel som angitt.

Relativt sett, takket være ulike integrerte løsninger, har oppsettprosessen for Stable Diffusion blitt dramatisk forenklet. Dessuten har Stable Diffusion et webgrensesnitt med et omfattende dashbord for bedre kontroll av genereringsprosessen. For en effektiv lokal distribusjon anbefales det også å bekrefte de foreslåtte maskinvarekravene. For nybegynnere anbefaler vi å bruke Stable Diffusion på Windows 10 eller 11.

De fleste aktive fellesskap og plattformer, som Reddit, Discord og forum, samler relaterte teknikker, kreasjoner og problemløsningsløsninger om Stable Diffusion. Dette fellesskapsdrevne støtteøkosystemet kan raskt dele nye modeller, funksjoner, praktiske løsninger og andre verdifulle ressurser.

| Funksjon/modell | Stabil diffusjon | Midjourney | Frødannelse | VEO 3 |

| Prissetting | Gratis modell med åpen kildekode (fellesskapslisens). Kostnader for maskinvare og skytjenester | Abonnement: Rundt $10 – $$1 152/måned | API: $0.09 – $1.50 per video | API: Gemini Developer API-priser |

| Maskinvarekrav | Høy (krever en kraftig GPU) | Lav (kjører på Discord, ingen lokal maskinvare nødvendig) | Skybasert (ingen brukermaskinvare kreves) | Skybasert (ingen brukermaskinvare kreves) |

| Tilpasning | Omfattende (åpen kildekode, støtter ControlNet, LoRA og tilpasset modelltrening) | Begrenset (gjennom ledetekster og grunnleggende parametere) | Omfattende (gjennom ledetekster og kreative kontroller) | Begrenset (hovedsakelig i spørsmål) |

| Bilde-/videokvalitet | Høy øvre grense, avhenger av modeller og tuning | Høy standardkvalitet, sterk kunstnerisk stil | HD-videoer (1080p) | 8-sekunders 720p til 1080p-videoer |

| Tekstforståelse | Bra, bli trent og forbedret med tilpassede modeller | Utmerket | Utmerket, forstår komplekse spørsmål | Utmerket, forstår komplekse fortellinger |

| Brukervennlighet | Brattere læringskurve | Lett | API-basert, krever integrasjon | Enkelt, trenger integrering |

Stable Diffusion er et godt valg for spesifikke brukergrupper, hovedsakelig de med tekniske ferdigheter og tilpasningskrav. Den tilbyr funksjoner som rettferdiggjør den brattere læringskurven og maskinvarekravene. For nybegynnere tilbyr imidlertid mange konkurrenter en mye enklere oppsett- og brukeropplevelse. Hvis du har kompatibel maskinvare og tilstrekkelig motivasjon til å lære, er Stable Diffusion et fleksibelt og kreativt verktøy for generering av AI-bilder.

Spørsmål 1. Hvor mye koster Stable Diffusion?

Stability AI tilbyr en Community License for utviklere, forskere, små bedrifter og skapere slik at de kan bruke Core Models (inkludert Stable Diffusion 3) gratis, med mindre virksomheten din har mer enn $1M USD i årlig omsetning eller du bruker Stable Diffusion‑modellene i kommersiell hensikt. Generelt er Core Models og Derivative Works gratis for deg å bruke. Du fyller inn nødvendig informasjon og sender deretter inn en forespørsel om gratis Community License. Les denne artikkelen for å få flere gratis KI‑bildetjenester!

Spørsmål 2. Finnes det maskinvarekrav for Stable Diffusion?

Når du vil kjøre Stable Diffusion på datamaskinen din, avhenger brukeropplevelsen i stor grad av maskinvaren, spesielt GPU, RAM og CPU. Du bør ha et NVIDIA-grafikkort. NVIDIAs CUDA-teknologi er utviklet med avansert akselerasjonsteknologi. Det kan være det mest kompatible alternativet for å kjøre Stable Diffusion. AMD-grafikkort anbefales ofte ikke på grunn av manglende optimalisering.

Spørsmål 3. Er Stable Diffusion ideelt for nybegynnere?

Det har blitt mye enklere å komme i gang med Stable Diffusion takket være ettklikksinstallasjonspakker og skytjenester. For nybegynnere innebærer imidlertid prosessen fortsatt en læringskurve, for ikke å snakke om å mestre det fulle potensialet. Enten du velger lokal installasjon eller skytjenesten, kan du etter å ha kjørt Stable Diffusion samhandle med den via et webgrensesnitt. Webgrensesnittet har et visuelt grensesnitt for tekst-til-bilde- og bilde-til-bilde-funksjoner. Du kan bruke dem til å generere og endre bilder. Dessuten må du ofte gi detaljerte tekstbeskrivelser for å produsere ønskede bilder. Den endelige kvaliteten på det genererte bildet avhenger i stor grad av instruksjonene du gir.

Spørsmål 4. Hvilke typer bilder kan Stable Diffusion lage?

Stable Diffusion kan generere bilder i et svært bredt spekter av typer. De fleste kunststiler støttes, inkludert realistiske bilder, anime, oljemaleri, akvarell og andre. Resultatene bestemmes hovedsakelig av den spesifikke KI‑modellen som brukes og promperne som gis.

Først må du velge en Checkpoint‑modell. Modellen bestemmer den grunnleggende stilen til det genererte bildet, for eksempel om det skal være realistisk eller tegneserieaktig. Du kan søke etter og laste ned relevante modeller fra plattformer i fellesskapet, som Hugging Face. Deretter kan du finjustere den med mindre modeller.

Spørsmål 5. Kan jeg bruke Stable Diffusion til kommersielle formål?

Ja, du kan bruke Stable Diffusion til kommersielle formål. Vennligst sjekk imidlertid de spesifikke vilkårene for Stable Diffusion-versjonen du bruker på det offisielle nettstedet. Reglene kan ha endret seg på tvers av ulike modellversjoner. Videre bør du sørge for at din planlagte kommersielle bruk ikke bryter med lisensens forbudte aktiviteter. Vær i tillegg oppmerksom på den potensielle mangelen på opphavsrettsbeskyttelse for bildene du genererer.

Konklusjon

Denne omtalen av Stable Diffusion gir deg en detaljert introduksjon til Stability AIs tekst‑til‑bilde‑modell, spesielt den nyeste Stable Diffusion 3.5‑modellen. Du bør nå ha et klart bilde av dens kapasitet, ytelse, styrker og svakheter gjennom denne omtalen. Når du har lest ferdig denne artikkelen, bør du vite nøyaktig hva Stable Diffusion kan gjøre for deg og om det er verdt tiden din.

Synes du dette var nyttig?

477 stemmer

Aiseesoft AI Photo Editor er et avansert skrivebordsprogram som er utviklet for å forbedre, oppskalere og klippe ut bilder.