De la lansarea revoluționară a Llama 1, API-urile proprietare, închise, au fost democratizate irevocabil. Seria open-source Llama (Large Language Model Meta AI) de la Meta a remodelat peisajul inteligenței artificiale. Llama 3, cu performanțe ridicate, și cea mai recentă versiune a sa, Llama 4, fac din această familie de modele fundamentul inovației în domeniul inteligenței artificiale open-source.

Dacă ești derutat de nenumăratele modele de inteligență artificială, citește această recenzie cuprinzătoare Llama. Poți afla ce este Llama, ce face ca Llama AI să fie unic, cazul său de utilizare convingător pentru afaceri, poziționarea competitivă față de giganți precum ChatGPT, un ghid practic pentru companii și multe altele.

Cuprins

Llama se referă la o colecție de modele fundamentale de limbaj de mari dimensiuni dezvoltate de Meta. Spre deosebire de modelele anterioare, care pot fi accesate doar prin API, seria Llama este publicată în mod deschis pentru cercetare și utilizare comercială. Într-adevăr, o licență personalizată este concepută pentru a preveni utilizarea abuzivă și se aplică în anumite condiții de scalare. Cea mai recentă versiune este Llama 4.

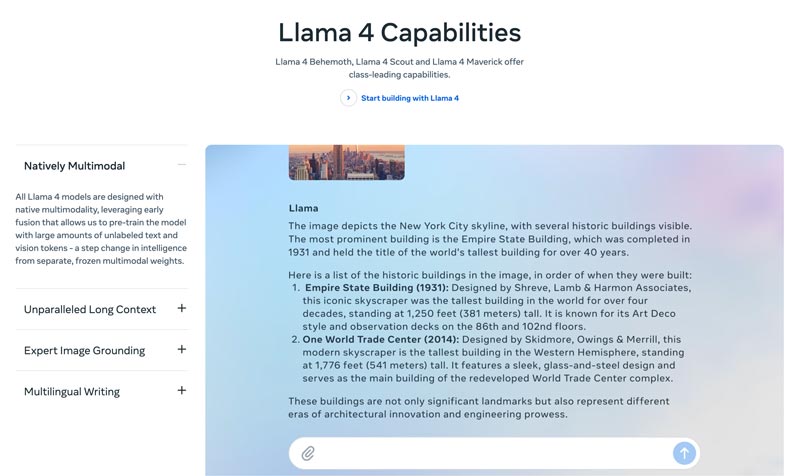

Llama 4 este cea mai nouă versiune. Meta susține că este versiunea cea mai inteligentă, scalabilă și convenabilă. Cu abilități mai avansate de raționament și planificare, capacități multimodale și funcții de scriere multilingvă, Llama 4 poate reprezenta fereastra de context de top din industrie. Îți permite să îți implementezi cu ușurință cele mai incredibile idei cu ajutorul Llama API și Llama Stack. Actuala versiune Llama 4 permite experiențe mai personalizate.

Llama 3 a fost lansat în aprilie 2024. Comparativ cu Llama 2, Llama 3 aduce mai multe îmbunătățiri, inclusiv raționament și programare avansate, date de antrenament îmbunătățite, o fereastră de context mai mare și un tokenizer mai eficient.

Llama 1 & 2: Llama original a fost lansat la începutul anului 2023, iar Llama 2 a fost lansat în iulie 2023. Ele au marcat intrarea directă a Meta în domeniul chatbot-urilor. Cu o variantă ajustată fin, începând cu Llama 2, seria oferă un dialog util și sigur. Llama 1/2 este dezvoltată în principal pentru a concura direct cu ChatGPT de la OpenAI și Bard de la Google.

Dezvoltat de Meta pentru a remodela peisajul AI, performanța ridicată nu va fi o problemă pentru tine. Llama este ajustat fin pe datele specifice ale companiei tale pentru a depăși modelele generice mai mari pe sarcini specifice. Potențialul său de fine-tuning îl face potrivit pentru majoritatea dezvoltatorilor și cercetătorilor.

Unicitatea Llama nu ține doar de performanță. Ecosistemul pe care Llama l-a generat poate fi un avantaj și mai mare. Ecosistemul său de pe Hugging Face a declanșat o explozie de inovație. Mii de derivate ajustate fin sunt oferite pentru diferite sarcini posibile.

Mai mult, Llama a pus un LLM de top în mâinile tuturor. Democratizarea AI este un alt beneficiu care face Llama unic. Modelele Llama AI sunt disponibile tuturor cercetătorilor, dezvoltatorilor și startup-urilor pentru a fi folosite, pentru a inova și a construi fără a plăti taxe de API sau a cere permisiune.

Avantaj strategic pentru afaceri. Llama îți permite ca dezvoltarea soluțiilor tale AI să îți aparțină. Nu mai trebuie să fii legat de prețurile unui furnizor, de schimbările de politică sau de întreruperea API-urilor. Astfel se evită în mod eficient dependența de un singur furnizor.

Argumentul de afaceri pentru Llama nu se rezumă doar la utilizarea unui model diferit de inteligență artificială. De fapt, poate reprezenta o schimbare fundamentală în modul în care o companie tratează inteligența artificială.

La început, multe companii au adoptat servicii bazate pe API, precum GPT-4 de la OpenAI. Aceasta poate fi opțiunea cea mai convenabilă, permițând experimentare cu bariere reduse și prototipare rapidă. Totuși, această strategie AI a fost înlocuită de o abordare mai strategică și pe termen lung, bazată pe modele open-source fundamentale precum Llama de la Meta. Cazul Llama se sprijină pe trei factori cheie: reducerea costurilor, control și personalizare, precum și securitatea datelor.

Costurile API pentru multe companii (care procesează milioane de interogări pe zi) pot ajunge la milioane anual. Implementarea Llama reprezintă o trecere de la cheltuieli operaționale (OpEx) la cheltuieli de capital (CapEx). Acest lucru face ca rentabilitatea investiției să fie evidentă la volum mare.

Llama vă permite să creați o inteligență artificială unică, fin reglată, care se potrivește cel mai bine afacerii sau produselor dvs. De asemenea, aveți control complet asupra intrărilor și ieșirilor modelului dvs. Acesta devine un activ esențial, nu un serviciu închiriat.

Guvernul și finanțele au cerințe stricte de guvernanță a datelor. Llama poate fi implementat complet local sau într-un VPC (Virtual Private Cloud) compatibil. Aceasta este adesea singura modalitate legală de a valorifica tehnologia LLM. Mai mult, implementarea Llama într-un VPC securizat înseamnă că toate datele dvs. sunt securizate și nu părăsesc niciodată firewall-ul. Acest lucru elimină efectiv riscul expunerii datelor de către terți.

Pe scurt, argumentul de business pentru Llama ține de proprietate. Ți se restituie controlul asupra avantajului tău competitiv, asupra securității datelor și asupra costurilor.

Llama de la Meta oferă o nouă modalitate pentru companii de a utiliza AI. Acest model AI puternic are o gamă largă de aplicații, inclusiv AI conversațional, generare de imagini și text, formare lingvistică, rezumare și alte sarcini conexe. Prin utilizarea unor capabilități AI avansate, Llama poate ajuta companiile să obțină succes.

• Servicii și suport pentru clienți

Chatboții avansați sau asistenții virtuali cu tehnologie Llama pot înțelege mai bine întrebările clienților, în special cele complexe, și pot oferi răspunsuri corecte, contextuale. Este benefic să se ofere asistență clienți 24/7.

• Analiză de date și Business Intelligence

Llama poate extrage date din diverse surse și poate lua decizii care inițial necesitau abilități tehnice. Permite managerilor de afaceri și analiștilor să obțină o interogare SQL punând întrebări. Modelul poate analiza text, imagini, diagrame și alt conținut pentru a oferi un rezumat narativ. Acest lucru ajută la identificarea rapidă a tendințelor emergente, a informațiilor despre concurență și a reclamațiilor comune.

• Marketing și automatizare de conținut

Procesul de producere a conținutului de înaltă calitate și optimizat pentru SEO necesită mult timp. Llama poate genera rapid schițe sau articole întregi cu un subiect simplu și câteva cuvinte cheie. Editorii umani pot apoi rafina aceste rezultate. Modelul poate automatiza, de asemenea, crearea de postări pe rețelele sociale. Mai mult, poate ajuta la scrierea unor subiecte convingătoare pentru e-mailuri și reclame.

• Dezvoltare software

Un model Llama specific codului poate acționa ca o funcție avansată de completare automată pentru a menține calitatea codului, a gestiona sistemele vechi și a accelera ciclurile de dezvoltare. Poate ajuta la revizuirea codului pentru potențiale erori. Mai mult, poate genera și actualiza automat documentația codului și referințele API pe baza comentariilor codului sursă.

Această secțiune oferă o comparație directă a seriei Llama de la Meta cu alte alternative importante, sub formă de tabel. Puteți compara acești factori cheie pentru a găsi cea mai potrivită opțiune pentru nevoile dumneavoastră specifice.

Ar trebui să fie clar că aceste modele de inteligență artificială au propriile puncte forte și puncte slabe. Alegerea nu constă în găsirea unei singure opțiuni.

| Modele AI | LLaMA-ul lui Meta 4/3/2 | GPT-4 al OpenAI | Claude 3 de la Anthropic | PaLM 2 de la Google |

| Licenţă | Licență personalizată, open-source | Proprietate | Proprietate | Proprietate |

| Acces | Descărcare și auto-găzduire | Numai pentru API Acces prin abonament | Numai pentru API Acces prin intermediul prețurilor bazate pe utilizare | Numai pentru API Acces prin intermediul Vertex AI de la Google |

| Modele AI | LLaMA-ul lui Meta 4/3/2 | GPT-4 al OpenAI | Claude 3 de la Anthropic | PaLM 2 de la Google |

| Performanţă | Nivel superior Competitiv cu modelele de IA de top Necesită reglaje fine pentru a egala performanța GPT-4 în sarcini specifice Deficit în furnizarea de conținut creativ captivant și de înaltă calitate | Lider în industrie Gestionarea raționamentului complex, a nuanțelor și a rezolvării creative a problemelor | Nivel superior Excelent la analiza datelor, dialog sofisticat și raționament în context lung | Nivel superior Excelent la raționament și sarcini multilingve |

| Structura costurilor | Experiențe de capital ridicate, experiențe operaționale reduse Scale de costuri în funcție de dimensiunea modelului și volumul de utilizare | Fără cheltuieli de capital, cheltuieli operaționale ridicate Nu cost inițial, dar plată per token pentru utilizare | Fără cheltuieli de capital, cheltuieli operaționale ridicate Similar cu OpenAI, plată pe token | Fără cheltuieli de capital, cheltuieli operaționale ridicate Plată per token pe Vertex AI, cu reduceri de volum |

| Confidențialitatea și securitatea datelor | Control maxim Datele nu vor părăsi niciodată infrastructura dvs. Ideal pentru industrii extrem de reglementate | Datele de intrare/ieșire sunt procesate pe serverele OpenAI | Politică de confidențialitate strictă, dar datele sunt procesate de Anthropic | Securitate la nivel de întreprindere Date procesate pe Google Cloud Oferă controale VPC și angajamente de rezidență a datelor |

| Personalizare și control | Control complet Poate fi complet ajustat pe baza datelor proprietare | Limitat Reglajul fin este disponibil doar pentru modelele mai vechi (nu GPT-4) | Limitat Personalizat prin inginerie promptă și context | Puternic Suport bun pentru reglarea fină și învățarea prin consolidare |

| Scalabilitate | Trebuie să vă furnizați și să vă gestionați propria infrastructură | OpenAI gestionează toată infrastructura | Anthropic gestionează toată infrastructura | Google Cloud gestionează infrastructura |

În general, Llama este ideal pentru companiile care preferă să aibă control complet, confidențialitatea datelor și personalizare. GPT-4 este cel mai potrivit pentru întreprinderile care necesită cea mai înaltă performanță brută și capacități de raționament. Poate gestiona mai bine sarcini complexe, în special analize creative și avansate. Claude 3 este ideal pentru aplicații în care siguranța și reducerea prejudecăților sunt primordiale. Rareori produce rezultate dăunătoare. PaLM 2 este cel mai potrivit pentru companiile care sunt profund integrate în ecosistemul Google Cloud. Acesta asigură o integrare perfectă cu alte instrumente Google.

Înainte de a implementa Llama, ar trebui să vă stabiliți nevoile în funcție de cazul de utilizare specific. Aveți nevoie de modelul de parametri 70B pentru calitate maximă sau doar de modelul 8B pentru sarcini de bază?

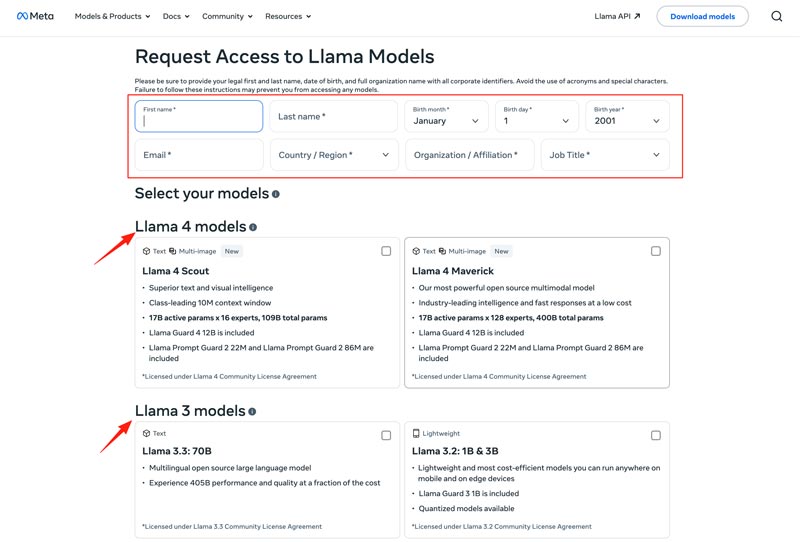

Ar trebui să alegeți metoda de implementare, cum ar fi o mașină locală, o mașină virtuală în cloud sau un serviciu gestionat. Rularea eficientă a modelelor Llama necesită adesea o GPU puternică, în special pentru modelele mai mari. După aceea, puteți descărca modelul corect de pe site-ul Meta.

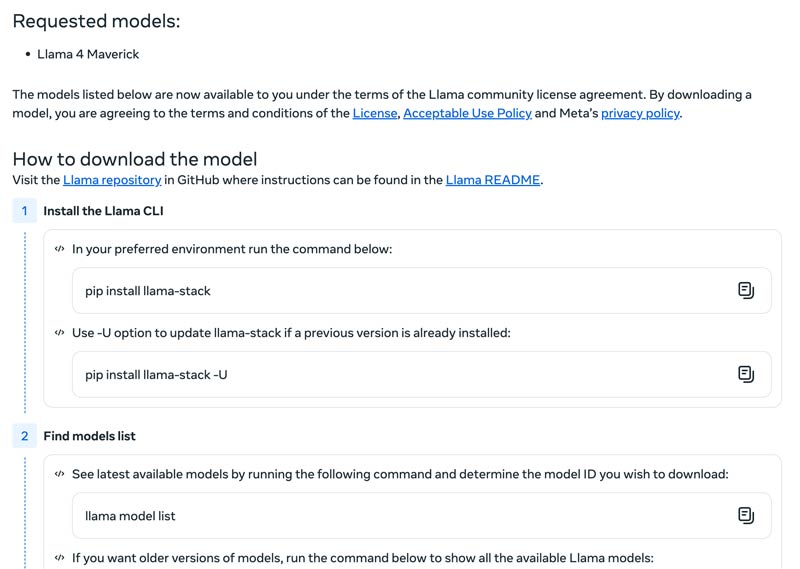

Apasă butonul Download Models pentru a intra în pagina Request Access. Furnizează informațiile necesare și alege modelul Llama dorit.

Apasă butonul Next pentru a citi Termenii și condițiile. Ar trebui să verifici cu atenție Community License Agreement și apoi să dai clic pe butonul Accept and Continue. Urmează instrucțiunile de pe ecran pentru a descărca modelul selectat.

Poți folosi un framework precum Text Generation Inference pentru a obține un server API de înaltă performanță. Dacă ai nevoie de o interfață de chat, implementează o interfață precum Chatbot UI sau NextChat. După aceea, folosește-ți datele proprietare împreună cu framework-uri pentru a crea propriul tău model specializat.

Ar trebui să știi cum să depășești provocările pentru a utiliza eficient modelele de inteligență artificială.

• Complexitatea configurării inițiale

Poți utiliza instrumentele și containerele sale predefinite. Rulați modele local cu o singură comandă. De asemenea, poți apela la platforme bazate pe cloud fără nicio configurare locală. Hugging Face îți permite să rulezi și să creezi demonstrații folosind medii preconfigurate. În plus, poți începe cu llama.cpp pentru a rula o versiune cuantizată a Llama.

• Gestionarea resurselor și optimizarea costurilor

Modelele mari necesită GPU-uri cu memorie mare, care sunt adesea rare și costisitoare.

Cuantizarea este cea mai eficientă tehnică. Puteți utiliza biblioteci pentru cuantizare pe 4 biți în timpul inferenței sau al reglării fine. Pe hardware mai puțin puternic, utilizați llama.cpp pentru a rula modele. Ambele metode pot reduce eficient utilizarea memoriei. În plus, asigurați-vă că selectați modelul corect pentru sarcinile dvs. Un model mai mic și reglat fin poate fi mai rentabil.

• Menținerea la zi cu noile versiuni

Multe modele, tehnici și biblioteci noi sunt lansate săptămânal. Poate fi dificil să fii la curent.

Ar trebui să te abonezi la blogurile oficiale precum Meta AI, Hugging Face și vLLM. Mai mult, noi tehnici de optimizare, aplicații, creșteri ale eficienței, experiențe, soluții și multe altele sunt partajate pe platforme precum GitHub și Hugging Face. Acest lucru permite echipei tale să integreze îmbunătățiri.

S-ar putea să ai nevoie și de:

Întrebarea 1. Este permisă utilizarea rezultatelor generate de modelele Llama pentru a antrena alte LLM-uri?

Da, Meta permite utilizarea versiunilor mai noi (Llama 3.1 și versiuni ulterioare) ale rezultatelor Llama pentru a antrena alte modele. Cu siguranță, nu aveți voie să le utilizați pentru a crea un produs care concurează cu Meta. Mai mult, trebuie să fiți conștienți de limitele legale stabilite de licența Meta.

Întrebarea 2. Modelele Llama au restricții? Care sunt termenii aferenți?

Da, modelele Llama au restricții semnificative, definite de structura lor de licențiere. Aceste modele nu sunt cu adevărat open-source. În schimb, sunt lansate sub o licență proprie de la Meta. Aceasta este pentru a proteja interesele Meta și a preveni cazurile de utilizare competitive.

Întrebarea 3. Care sunt cazurile de utilizare frecvente ale Llama?

Printre cazurile de utilizare zilnică a Llama se numără înțelegerea imaginilor și documentelor, răspunsul la întrebări, generarea de imagini și text, generarea și rezumarea limbajului, instruirea lingvistică, utilizarea inteligenței artificiale pentru conversații și multe altele. Llama poate răspunde la întrebarea dvs. pe baza conținutului imaginii sau documentului furnizat. Mai mult, poate fi folosit pentru a crea un chatbot sau un asistent vizual.

Întrebarea 4. Care sunt cerințele hardware pentru utilizarea modelelor Llama?

Cerințele hardware pentru rularea modelelor Llama sunt determinate de trei factori cheie: dimensiunea modelului, cuantizarea și cazul de utilizare. Pentru majoritatea dezvoltatorilor, o placă video RTX 4070/4080/4090 sau un Mac cu memorie unificată de 16-36 GB este o alegere flexibilă pentru modelele Llama de până la 70 GB. Pentru funcționarea bazată pe GPU, cel mai important factor este VRAM-ul plăcii grafice. După cum am menționat, selectați dimensiunea corectă a modelului în funcție de nevoile dvs., apoi alegeți nivelul de cuantizare care poate rula pe hardware-ul dvs.

Întrebarea 5. Este Llama la fel de bun ca ChatGPT?

Poți verifica tabelul de mai sus pentru a compara principalii factori între Llama și ChatGPT. Llama poate fi rulat local și offline. Oferă o protecție a datelor mai sigură. În plus, modelul Llama în sine este gratuit de utilizat. ChatGPT are o versiune gratuită, dar modelele și funcțiile sale avansate necesită un abonament plătit.

Concluzie

Llama nu este doar încă un model. Este adesea privit ca o schimbare strategică spre un viitor AI mai accesibil și mai personalizabil. Poți afla diverse informații legate de familia Llama AI în această recenzie directă și apoi poți decide dacă merită sau nu entuziasmul creat.

Ți s-a părut de ajutor?

484 Voturi