In de schijnwerpers: AI-chat , games zoals Retro , locatiewisselaar , Roblox gedeblokkeerd

In de schijnwerpers: AI-chat , games zoals Retro , locatiewisselaar , Roblox gedeblokkeerd

Sinds de baanbrekende release van Llama 1 zijn de gesloten, propriëtaire API's onherroepelijk gedemocratiseerd. Meta's open-source Llama (Large Language Model Meta AI)-serie heeft het AI-landschap radicaal veranderd. De uiterst capabele Llama 3 en de recent uitgebrachte Llama 4 maken deze familie van modellen tot de basis voor open-source AI-innovatie.

If you are confused by countless AI models, read this comprehensive Llama review. You can learn what Llama is, what makes Llama AI unique, its compelling business case, the competitive standing against giants like ChatGPT, a practical guide for enterprises, and more.

Table of contents

Llama refers to a collection of foundational large language models developed by Meta. Unlike previous models that can only be accessed via API, the Llama series is released publicly for research and commercial use. Indeed, a custom license is designed to prevent misuse, and it applies under specific scaling conditions. The latest version is Llama 4.

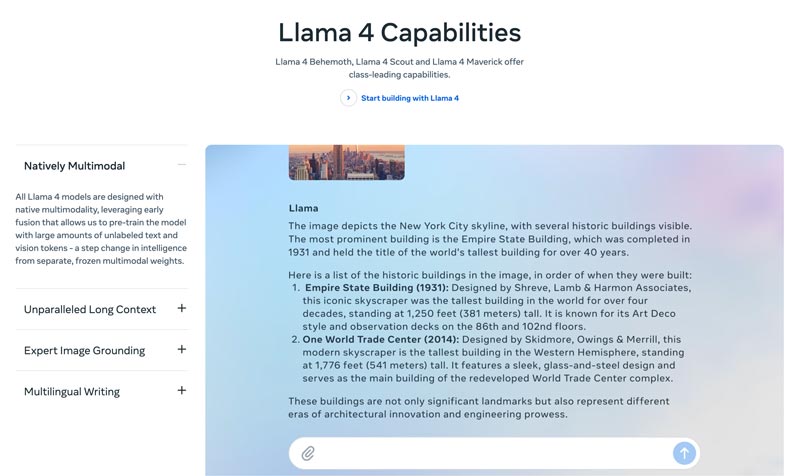

Llama 4 is the latest version. Meta claims that it is the most intelligent, scalable, and convenient version. With more advanced reasoning and planning abilities, multimodal capabilities, and multilingual writing functions, Llama 4 can be the industry-leading context window. It allows you to easily deploy your most incredible ideas with the Llama API and the Llama Stack. The current Llama 4 allows more personalized experiences.

Llama 3 was released in April 2024. Compared to Llama 2, Llama 3 has several improvements, including enhanced reasoning and coding, improved training data, a larger context window, and a more efficient tokenizer.

Llama 1 & 2: The original Llama was released in early 2023, and Llama 2 was released in July 2023. They marked Meta’s direct entry into the chatbot arena. With a fine-tuned variant, since Llama 2, the series delivers a helpful and safe dialogue. Llama 1/2 is mainly developed for challenging OpenAI’s ChatGPT and Google’s Bard head-on.

Developed by Meta for reshaping the AI landscape, the high performance won’t be your concern. Llama is fine-tuned on your company’s specific data to outperform larger generic models for specific tasks. The potential for fine-tuning nature makes it suitable for most developers and researchers.

Llama’s uniqueness is not just its performance. The ecosystem Llama has spawned can be a greater advantage. Its Hugging Face ecosystem has sparked an explosion of innovation. Thousands of fine-tuned derivatives are offered for different conceivable tasks.

Moreover, Llama has put a top-tier LLM into everyone’s hands. The democratization of AI is another benefit that makes Llama unique. Llama AI models are available for all researchers, developers, and startups to use, innovate, and build without paying API fees or asking for permission.

Strategic advantage for businesses. Llama lets your AI building be owned by yourself. You don’t need to tie to a vendor’s pricing, policy changes, or API deprecations anymore. That avoids vendor lock-in effectively.

De businesscase voor Llama gaat niet alleen over het gebruik van een ander AI-model. Het kan zelfs een fundamentele verandering betekenen in de manier waarop een bedrijf met AI omgaat.

In the early days, many businesses adopted API-based services, such as OpenAI’s GPT-4. That can be the most convenient option, allowing for low-barrier experimentation and rapid prototyping. However, this AI strategy has been replaced by a more strategic, long-term approach, open-source foundation models like Meta’s Llama.The Llama case rests on three key factors: cost savings, control and customization, and data security.

De API-kosten voor veel bedrijven (die miljoenen query's per dag verwerken) kunnen jaarlijks in de miljoenen lopen. De implementatie van Llama betekent een verschuiving van operationele uitgaven (OpEx) naar kapitaaluitgaven (CapEx). Dat maakt de ROI bij hoge volumes duidelijk.

Met Llama creëert u een uniek, verfijnde AI die het beste bij uw bedrijf of producten past. U behoudt bovendien volledige controle over de input en output van uw model. Het wordt een kernactiviteit, geen gehuurde dienst.

Overheid en financiële instellingen hanteren strenge eisen voor data governance. Llama kan volledig on-premise of in een compatibele VPC (Virtual Private Cloud) worden geïmplementeerd. Dat is vaak de enige legale manier om LLM-technologie te gebruiken. Bovendien betekent de implementatie van Llama in een beveiligde VPC dat al uw gegevens veilig zijn en nooit uw firewall verlaten. Dit elimineert effectief het risico op gegevenslekken van derden.

In a word, the business case for Llama is about ownership. You are given back the ownership of your competitive advantage, the security of your data, and your costs.

Meta’s Llama provides a new way for businesses to use AI. This powerful AI model has a wide range of applications, including conversational AI, image and text generation, language training, summarization, and other related tasks. By using advanced AI capabilities, Llama can help businesses drive success.

• Customer Service & Support

Geavanceerde chatbots of virtuele assistenten van Llama kunnen de vragen van klanten, met name complexe vragen, beter begrijpen en correcte, contextbewuste antwoorden geven. Het is daarom belangrijk om 24/7 klantondersteuning te bieden.

• Data Analysis & Business Intelligence

Llama kan data uit verschillende bronnen halen en beslissingen nemen die in eerste instantie technische vaardigheden vereisten. Het stelt bedrijfsmanagers en analisten in staat om een SQL-query te krijgen door vragen te stellen. Het model kan tekst, afbeeldingen, grafieken en andere content analyseren om een verhalende samenvatting te geven. Dit helpt om snel opkomende trends, inzichten in de concurrentie en veelvoorkomende klachten te identificeren.

• Marketing & Content Automation

Het produceren van hoogwaardige en SEO-geoptimaliseerde content is tijdrovend. Llama kan snel concepten of complete artikelen genereren met een eenvoudig onderwerp en meerdere trefwoorden. Menselijke redacteuren kunnen deze resultaten vervolgens verfijnen. Het model kan ook het maken van berichten op sociale media automatiseren. Bovendien kan het helpen bij het schrijven van pakkende onderwerpregels voor e-mails en advertenties.

• Software Development

Een codespecifiek Llama-model kan fungeren als een geavanceerde autocomplete om de codekwaliteit te behouden, legacysystemen te beheren en ontwikkelcycli te versnellen. Het kan helpen bij het controleren van code op potentiële bugs. Bovendien kan het automatisch codedocumentatie en API-referenties genereren en bijwerken op basis van de opmerkingen in de broncode.

In deze sectie wordt de Llama-serie van Meta naast andere toonaangevende alternatieven in tabelvorm vergeleken. U kunt deze belangrijke factoren vergelijken om de beste oplossing voor uw specifieke behoeften te vinden.

Het moet duidelijk zijn dat deze AI-modellen hun eigen sterke en zwakke punten hebben. De keuze gaat niet om het vinden van één optie.

| AI-modellen | Meta's LLaMA 4/3/2 | GPT-4 van OpenAI | Claude 3 van Anthropic | Google's PaLM 2 |

| Licentie | Open-source, aangepaste licentie | Eigendom | Eigendom | Eigendom |

| Toegang | Downloaden en zelf hosten | Alleen API Toegang via abonnement | Alleen API Toegang via op gebruik gebaseerde prijzen | Alleen API Toegang via Google's Vertex AI |

| AI-modellen | Meta's LLaMA 4/3/2 | GPT-4 van OpenAI | Claude 3 van Anthropic | Google's PaLM 2 |

| Prestatie | Topklasse Concurrerend met top AI-modellen Vereist fine-tuning om de GPT-4-prestaties op specifieke taken te evenaren Beperkt in het leveren van boeiende, hoogwaardige creatieve content | Marktleider Omgaan met complexe redeneringen, nuances en creatieve probleemoplossing | Topklasse Uitstekend in data-analyse, geavanceerde dialogen en redeneren in lange contexten | Topklasse Uitstekend in redeneren en meertalige taken |

| Kostenstructuur | Hoge CapEx, lage OpEx Kostenschalen met modelgrootte en gebruiksvolume | Geen CapEx, Hoge OpEx Nee initiële kosten, maar betaal per token voor gebruik | Geen CapEx, hoge OpEx Vergelijkbaar met OpenAI, pay-per-token | Geen CapEx, hoge OpEx Betalen per token op Vertex AI, met volumekortingen |

| Gegevensbescherming en -beveiliging | Maximale controle Gegevens verlaten uw infrastructuur nooit. Ideaal voor sterk gereguleerde sectoren. | Input-/outputgegevens worden verwerkt op de servers van OpenAI | Sterk privacybeleid, maar gegevens worden verwerkt door Anthropic | Beveiliging op ondernemingsniveau Gegevens verwerkt op Google Cloud Biedt VPC-controles en dataresidentieverplichtingen |

| Aanpassing en controle | Volledige controle Kan volledig worden verfijnd op basis van eigen gegevens | Beperkt Fijnafstemming is alleen beschikbaar voor oudere modellen (niet GPT-4) | Beperkt Op maat gemaakt via snelle engineering en context | Sterk Goede ondersteuning voor finetuning en reinforcement learning |

| Schaalbaarheid | U moet uw eigen infrastructuur inrichten en beheren | OpenAI beheert alle infrastructuur | Anthropic beheert alle infrastructuur | Google Cloud beheert de infrastructuur |

Over het algemeen is Llama ideaal voor bedrijven die de voorkeur geven aan volledige controle, dataprivacy en aanpasbaarheid. GPT-4 is het meest geschikt voor bedrijven die de hoogste ruwe prestatie- en redeneercapaciteiten nodig hebben. Het kan complexe taken, met name creatieve en geavanceerde analyses, beter aan. Claude 3 is ideaal voor toepassingen waarbij veiligheid en verminderde bias van cruciaal belang zijn. Het produceert zelden schadelijke output. PaLM 2 is het meest geschikt voor bedrijven die diep geïntegreerd zijn in het Google Cloud-ecosysteem. Het zorgt voor een naadloze integratie met andere Google-tools.

Voordat u Llama implementeert, moet u eerst uw behoeften bepalen op basis van de specifieke use case. Heeft u het 70B-parametermodel nodig voor maximale kwaliteit of alleen het 8B-model voor basistaken?

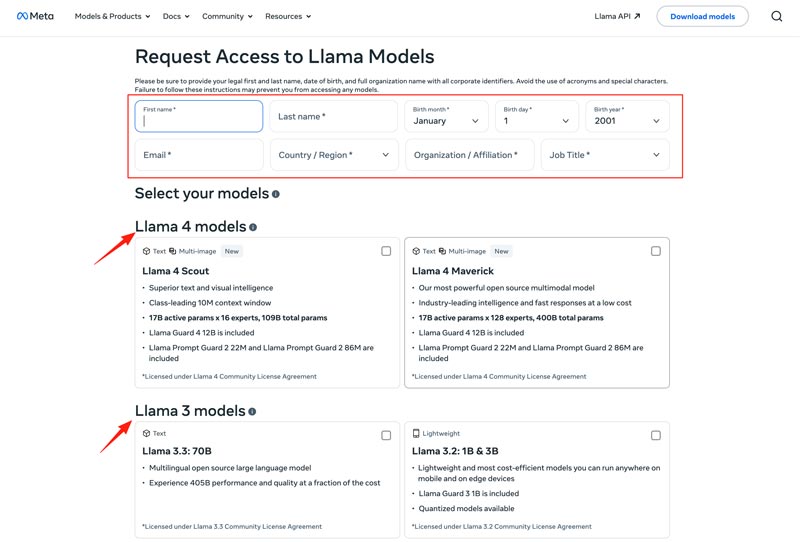

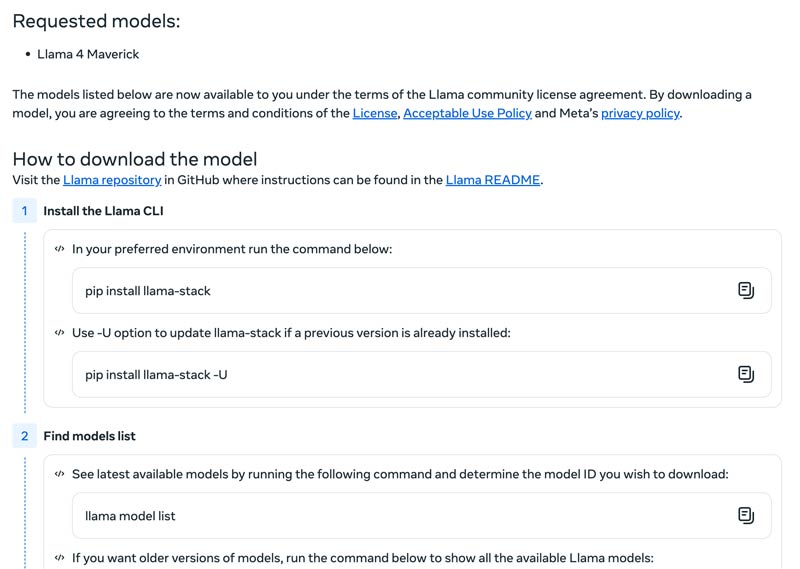

U moet uw implementatiemethode kiezen, zoals een lokale machine, een virtuele machine in de cloud of een beheerde service. Om Llama-modellen efficiënt te laten werken, is vaak een krachtige GPU vereist, vooral voor de grotere modellen. Daarna kunt u het juiste model downloaden van de Meta-website.

Click the Download Models button to enter the Request Access page. Provide the required information and choose a desired Llama model.

Click the Next button to read Terms and Conditions. You should check the Community License Agreement carefully and then click the Accept and Continue button. Follow the on-screen instructions to download your selected model.

You can use a framework like Text Generation Inference to get a high-performance API server. If you need a chat interface, deploy a UI like Chatbot UI or NextChat. After that, use your proprietary data with frameworks to create your own specialized model.

U moet weten hoe u uitdagingen kunt overwinnen om AI-modellen effectief te gebruiken.

• Initial Setup Complexity

U kunt de vooraf gebouwde tools en containers gebruiken. Voer modellen lokaal uit met één opdracht. U kunt ook overstappen op cloudgebaseerde platforms zonder lokale configuratie. Met Hugging Face kunt u demo's uitvoeren en maken met behulp van vooraf geconfigureerde omgevingen. Bovendien kunt u beginnen met llama.cpp om een gekwantiseerde versie van Llama uit te voeren.

• Resource Management & Cost Optimization

Grote modellen vereisen GPU's met veel geheugen, maar die zijn vaak schaars en duur.

Kwantisering is de meest effectieve techniek. U kunt bibliotheken gebruiken voor 4-bits kwantisering tijdens inferentie of fine-tuning. Op minder krachtige hardware kunt u llama.cpp gebruiken om modellen uit te voeren. Beide methoden kunnen het geheugengebruik effectief verminderen. Zorg er bovendien voor dat u het juiste model voor uw taken selecteert. Een kleiner, fine-tuned model kan kosteneffectiever zijn.

• Staying Up-to-Date with New Releases

Er verschijnen wekelijks veel nieuwe modellen, technieken en bibliotheken. Het kan lastig zijn om op de hoogte te blijven.

Abonneer je op officiële blogs zoals Meta AI, Hugging Face en vLLM. Bovendien worden nieuwe finetuningtechnieken, toepassingen, efficiëntieverbeteringen, ervaringen, oplossingen en meer gedeeld op platforms zoals GitHub en Hugging Face. Zo kan je team verbeteringen integreren.

You May Also Need:

Question 1. Is it permitted to use the output of the Llama models to train other LLMs?

Ja, Meta staat het toe om nieuwere versies (Llama 3.1 en later) van Llama's output te gebruiken om andere modellen te trainen. Je mag het toch zeker niet gebruiken om een product te creëren dat concurreert met Meta? Bovendien moet je je terdege bewust zijn van de juridische grenzen die de licentie van Meta stelt.

Question 2. Do Llama models have restrictions? What are the related terms?

Ja, Llama-modellen hebben aanzienlijke beperkingen, die worden bepaald door hun licentiestructuur. Deze modellen zijn niet echt open source. In plaats daarvan worden ze vrijgegeven onder een propriëtaire licentie van Meta. Dit is bedoeld om de belangen van Meta te beschermen en concurrerende use cases te voorkomen.

Question 3. What are the common use cases of Llama?

Dagelijkse toepassingen van Llama zijn onder andere het begrijpen van afbeeldingen en documenten, het beantwoorden van vragen, het genereren van afbeeldingen en tekst, het genereren en samenvatten van taal, taaltraining, conversatie-AI en meer. Llama kan uw vraag beantwoorden op basis van de afbeelding of de inhoud van het document dat u hebt aangeleverd. Bovendien kan het worden gebruikt om een chatbot of visuele assistent te creëren.

Question 4. What are the hardware requirements for using Llama models?

De hardwarevereisten voor het draaien van Llama-modellen worden bepaald door drie belangrijke factoren: modelgrootte, kwantificering en gebruiksscenario. Voor de meeste ontwikkelaars is een RTX 4070/4080/4090 of een Mac met 16-36 GB Unified Memory een flexibele keuze voor Llama-modellen tot 70 GB. Voor GPU-gebaseerde werking is het VRAM van uw grafische kaart de belangrijkste factor. Zoals gezegd, selecteert u de juiste modelgrootte op basis van uw behoeften en kiest u vervolgens het kwantificeringsniveau dat op uw hardware kan draaien.

Question 5. Is Llama as good as ChatGPT?

You can check the table above to compare their key factors between Llama and ChatGPT. Llama can be run locally and offline. It offers more secure data protection. Moreover, the Llama model itself is free to use. ChatGPT has a free version, but its advanced models and features require a paid plan.

Conclusie

Llama is not just another model. It is often viewed as a strategic shift toward a more accessible and customizable AI future. You can learn various related information about the Llama AI family in this no-nonsense review and then find out if it is worth the hype.

Vond je dit nuttig?

484 Votes