จุดเด่น: แชท AI , เกมแนว Retro , ตัวเปลี่ยนตำแหน่งที่ตั้ง , Roblox เวอร์ชันปลดล็อก

จุดเด่น: แชท AI , เกมแนว Retro , ตัวเปลี่ยนตำแหน่งที่ตั้ง , Roblox เวอร์ชันปลดล็อก

นับตั้งแต่การเปิดตัว Llama 1 อันเป็นก้าวสำคัญ API แบบปิดที่เป็นกรรมสิทธิ์ก็ถูกทำให้เป็นประชาธิปไตยอย่างถาวร ซีรีส์ Llama (Large Language Model Meta AI) แบบโอเพนซอร์สของ Meta ได้พลิกโฉมภูมิทัศน์ AI Llama 3 ประสิทธิภาพสูงและ Llama 4 รุ่นล่าสุด ทำให้โมเดลตระกูลนี้เป็นรากฐานสำหรับนวัตกรรม AI แบบโอเพนซอร์ส

หากคุณสับสนกับโมเดล AI นับไม่ถ้วน ลองอ่าน รีวิว Llama ฉบับครบถ้วนนี้ คุณจะได้รู้ว่า Llama คืออะไร อะไรทำให้ Llama AI แตกต่าง กรณีการใช้งานเชิงธุรกิจที่น่าสนใจ สถานะความสามารถเมื่อเทียบกับยักษ์ใหญ่อย่าง ChatGPT คู่มือเชิงปฏิบัติสำหรับองค์กร และอื่น ๆ อีกมากมาย.

สารบัญ

Llama หมายถึงชุดของโมเดลภาษาขนาดใหญ่พื้นฐาน (foundational LLMs) ที่พัฒนาโดย Meta แตกต่างจากโมเดลก่อนหน้า ซึ่งเข้าถึงได้เฉพาะผ่าน API ซีรีส์ Llama ถูกปล่อยสู่สาธารณะเพื่อการวิจัยและการใช้งานเชิงพาณิชย์ โดยมีสัญญาอนุญาตแบบกำหนดเองเพื่อป้องกันการใช้งานในทางที่ผิด ซึ่งใช้บังคับภายใต้เงื่อนไขด้านขนาดการใช้งาน เวอร์ชันล่าสุดคือ Llama 4.

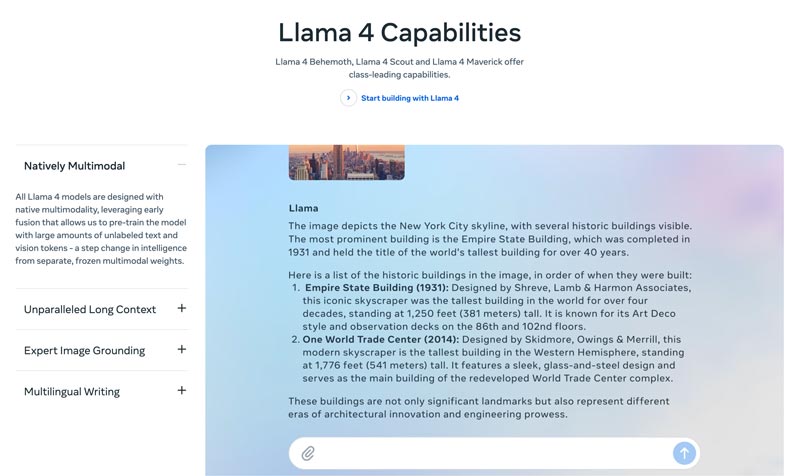

Llama 4 คือเวอร์ชันล่าสุด Meta ระบุว่าเป็นเวอร์ชันที่ฉลาด ยืดหยุ่น และใช้งานสะดวกที่สุด ด้วยความสามารถด้านการให้เหตุผลและการวางแผนที่ก้าวหน้า รองรับมัลติโหมด และการเขียนหลายภาษา Llama 4 สามารถเป็นผู้นำอุตสาหกรรมด้านขนาดหน้าต่างบริบท ช่วยให้คุณนำไอเดียสุดเจ๋งมาดีพลอยได้ง่าย ผ่าน Llama API และ Llama Stack Llama 4 เวอร์ชันปัจจุบันยังรองรับประสบการณ์ที่ปรับให้เป็นส่วนบุคคลมากขึ้น.

Llama 3 เปิดตัวในเดือนเมษายน 2024 เมื่อเทียบกับ Llama 2 แล้ว Llama 3 มีการปรับปรุงหลายด้าน รวมถึงความสามารถด้านการให้เหตุผลและการเขียนโค้ดที่ดีขึ้น ชุดข้อมูลฝึกที่ดีขึ้น หน้าต่างบริบทที่ใหญ่ขึ้น และตัวแบ่งคำ (tokenizer) ที่มีประสิทธิภาพมากขึ้น.

Llama 1 & 2: Llama รุ่นดั้งเดิมเปิดตัวช่วงต้นปี 2023 และ Llama 2 เปิดตัวในเดือนกรกฎาคม 2023 ซึ่งเป็นหมุดหมายของการเข้าสู่สนามแชตบอตของ Meta อย่างเต็มตัว นับตั้งแต่ Llama 2 ที่มีรุ่นปรับจูนเฉพาะทาง ซีรีส์นี้ถูกออกแบบมาให้สนทนาได้อย่างมีประโยชน์และปลอดภัย Llama 1/2 พัฒนาขึ้นมาเพื่อต่อกรกับ ChatGPT ของ OpenAI และ Bard ของ Google โดยตรงเป็นหลัก.

พัฒนาโดย Meta เพื่อพลิกโฉมภูมิทัศน์ของ AI เรื่องประสิทธิภาพสูงจึงไม่ใช่ปัญหาของคุณ Llama สามารถปรับจูนด้วยข้อมูลเฉพาะของบริษัทคุณเพื่อให้ทำงานได้ดีกว่าโมเดลขนาดใหญ่แบบทั่วไปในงานบางประเภท ธรรมชาติที่เอื้อต่อการปรับจูนนี้ทำให้ Llama เหมาะกับทั้งนักพัฒนาและนักวิจัยส่วนใหญ่.

ความโดดเด่นของ Llama ไม่ได้อยู่ที่ประสิทธิภาพเพียงอย่างเดียว ระบบนิเวศที่ Llama สร้างขึ้น อาจเป็นข้อได้เปรียบที่ยิ่งใหญ่กว่า ระบบนิเวศบน Hugging Face ทำให้เกิดกระแสการสร้างสรรค์นวัตกรรมอย่างล้นหลาม มีโมเดลอนุพันธ์ที่ผ่านการปรับจูนหลายพันตัวสำหรับงานหลากหลายรูปแบบที่คิดได้.

ยิ่งไปกว่านั้น Llama ยังได้นำ LLM ระดับท็อปมาไว้ในมือทุกคน การทำให้ AI เข้าถึงได้อย่างทั่วถึง (democratization of AI) คืออีกหนึ่งข้อดีที่ทำให้ Llama มีเอกลักษณ์ โมเดล Llama AI เปิดให้ใช้งานสำหรับนักวิจัย นักพัฒนา และสตาร์ทอัปทุกคน เพื่อนำไปใช้ต่อยอดและสร้างนวัตกรรม โดยไม่ต้องจ่ายค่า API หรือขออนุญาตก่อน.

ความได้เปรียบเชิงกลยุทธ์สำหรับธุรกิจ Llama ทำให้การสร้างระบบ AI เป็นทรัพย์สินที่คุณเป็นเจ้าของเอง คุณไม่จำเป็นต้องผูกติดกับราคาของผู้ให้บริการ การเปลี่ยนนโยบาย หรือการยกเลิก API อีกต่อไป ช่วยหลีกเลี่ยงการถูกล็อกอินกับผู้ให้บริการได้อย่างมีประสิทธิภาพ.

เหตุผลทางธุรกิจของ Llama ไม่ใช่แค่การใช้โมเดล AI ที่แตกต่างออกไปเท่านั้น แต่ในความเป็นจริงแล้ว มันอาจเป็นการเปลี่ยนแปลงพื้นฐานในวิธีที่บริษัทดำเนินการกับ AI ก็ได้

ในช่วงแรก หลายธุรกิจใช้บริการแบบ API เช่น GPT-4 ของ OpenAI ซึ่งถือว่าเป็นตัวเลือกที่สะดวกที่สุด เปิดโอกาสให้ทดลองและสร้างต้นแบบได้ง่ายและรวดเร็ว อย่างไรก็ตาม กลยุทธ์ด้าน AI แบบนี้กำลังถูกแทนที่ด้วยแนวทางระยะยาวที่มีความเป็นกลยุทธ์มากขึ้น นั่นคือการใช้โมเดลโอเพนซอร์สพื้นฐานอย่าง Llama ของ Meta เหตุผลหลักของกรณีศึกษา Llama มีสามข้อ ได้แก่ การประหยัดต้นทุน การควบคุมและการปรับแต่ง และความปลอดภัยของข้อมูล.

ค่าใช้จ่าย API สำหรับหลายบริษัท (ที่ประมวลผลคิวรีหลายล้านรายการต่อวัน) อาจสูงถึงหลายล้านบาทต่อปี การนำ Llama มาใช้ถือเป็นการเปลี่ยนจากค่าใช้จ่ายในการดำเนินงาน (OpEx) ไปเป็นค่าใช้จ่ายด้านการลงทุน (CapEx) ซึ่งทำให้ ROI ชัดเจนขึ้นเมื่อใช้งานในปริมาณมาก

Llama ช่วยให้คุณสร้าง AI ที่ได้รับการปรับแต่งอย่างพิถีพิถันและเป็นเอกลักษณ์เฉพาะตัว ซึ่งเหมาะสมกับธุรกิจหรือผลิตภัณฑ์ของคุณมากที่สุด คุณยังสามารถควบคุมอินพุตและเอาต์พุตของโมเดลได้อย่างสมบูรณ์ AI จะกลายเป็นสินทรัพย์หลัก ไม่ใช่บริการเช่า

ภาครัฐและภาคการเงินมีข้อกำหนดการกำกับดูแลข้อมูลที่เข้มงวด Llama สามารถติดตั้งใช้งานแบบ on-premise หรือใน VPC (Virtual Private Cloud) ที่ได้มาตรฐาน ซึ่งมักเป็นวิธีเดียวที่ถูกกฎหมายในการใช้ประโยชน์จากเทคโนโลยี LLM ยิ่งไปกว่านั้น การติดตั้ง Llama ภายใน VPC ที่ปลอดภัยยังช่วยให้ข้อมูลทั้งหมดของคุณได้รับความปลอดภัยและไม่ถูกส่งออกนอกไฟร์วอลล์ของคุณ ซึ่งจะช่วยลดความเสี่ยงจากการเปิดเผยข้อมูลของบุคคลที่สามได้อย่างมีประสิทธิภาพ

โดยสรุป กรณีการใช้งานเชิงธุรกิจของ Llama คือเรื่องของความเป็นเจ้าของ คุณจะได้กลับมาถือครองความได้เปรียบเชิงการแข่งขัน ความปลอดภัยของข้อมูล และการควบคุมต้นทุนของคุณเอง.

Llama ของ Meta มอบแนวทางใหม่ให้ธุรกิจใช้ AI โมเดล AI ทรงพลังนี้มีการประยุกต์ใช้อย่างกว้างขวาง รวมถึงระบบสนทนาอัตโนมัติ การสร้างภาพและข้อความ การฝึกอบรมภาษา การสรุปความ และงานที่เกี่ยวข้องอื่น ๆ ด้วยการใช้ความสามารถขั้นสูงของ AI Llama สามารถช่วยผลักดันให้ธุรกิจประสบความสำเร็จได้.

• งานบริการและสนับสนุนลูกค้า

แชทบอทขั้นสูงหรือผู้ช่วยเสมือนที่ขับเคลื่อนโดย Llama สามารถเข้าใจคำถามของลูกค้าได้ดีขึ้น โดยเฉพาะคำถามที่ซับซ้อน และให้คำตอบที่ถูกต้องและเข้าใจบริบท การให้การสนับสนุนลูกค้าตลอด 24 ชั่วโมงทุกวันจึงเป็นประโยชน์อย่างยิ่ง

• การวิเคราะห์ข้อมูลและธุรกิจอัจฉริยะ

Llama สามารถดึงข้อมูลจากหลากหลายแหล่ง และตัดสินใจในเบื้องต้นที่จำเป็นต้องมีทักษะทางเทคนิค ช่วยให้ผู้จัดการธุรกิจและนักวิเคราะห์สามารถค้นหาข้อมูล SQL ได้โดยการถามคำถาม โมเดลนี้สามารถวิเคราะห์ข้อความ รูปภาพ แผนภูมิ และเนื้อหาอื่นๆ เพื่อสรุปข้อมูลเชิงบรรยาย ซึ่งช่วยให้ระบุแนวโน้มใหม่ๆ ข้อมูลเชิงลึกของคู่แข่ง และข้อร้องเรียนที่พบบ่อยได้อย่างรวดเร็ว

• การตลาดและระบบอัตโนมัติด้านคอนเทนต์

กระบวนการสร้างเนื้อหาคุณภาพสูงและปรับแต่ง SEO นั้นใช้เวลานาน Llama สามารถสร้างฉบับร่างหรือบทความทั้งบทความได้อย่างรวดเร็วด้วยหัวข้อง่ายๆ และคีย์เวิร์ดหลายคำ จากนั้นบรรณาธิการที่เป็นมนุษย์ก็สามารถปรับแต่งผลลัพธ์เหล่านี้ได้ โมเดลนี้ยังสามารถสร้างโพสต์บนโซเชียลมีเดียได้โดยอัตโนมัติ ยิ่งไปกว่านั้น ยังช่วยเขียนหัวข้ออีเมลและโฆษณาที่น่าสนใจได้อีกด้วย

• การพัฒนาซอฟต์แวร์

โมเดล Llama เฉพาะโค้ดสามารถทำหน้าที่เป็นระบบเติมข้อความอัตโนมัติขั้นสูงเพื่อรักษาคุณภาพของโค้ด จัดการระบบเดิม และเร่งวงจรการพัฒนา สามารถช่วยตรวจสอบโค้ดเพื่อหาจุดบกพร่องที่อาจเกิดขึ้นได้ นอกจากนี้ ยังสามารถสร้างและอัปเดตเอกสารประกอบโค้ดและเอกสารอ้างอิง API โดยอัตโนมัติตามความคิดเห็นของโค้ดต้นฉบับได้อีกด้วย

ส่วนนี้แสดงการเปรียบเทียบแบบเคียงข้างกันระหว่างซีรีส์ Llama ของ Meta กับตัวเลือกชั้นนำอื่นๆ ในรูปแบบตาราง คุณสามารถเปรียบเทียบปัจจัยสำคัญเหล่านี้เพื่อค้นหาตัวเลือกที่เหมาะสมที่สุดกับความต้องการเฉพาะของคุณ

ควรชัดเจนว่าโมเดล AI เหล่านี้มีจุดแข็งและจุดอ่อนของตัวเอง การเลือกไม่ใช่การหาทางเลือกเดียว

| แบบจำลอง AI | เมต้าส์ LLaMA 4/3/2 | GPT-4 ของ OpenAI | คล็อด 3 ของแอนโทรปิก | PaLM 2 ของ Google |

| ใบอนุญาต | โอเพ่นซอร์ส ใบอนุญาตแบบกำหนดเอง | กรรมสิทธิ์ | กรรมสิทธิ์ | กรรมสิทธิ์ |

| เข้าถึง | ดาวน์โหลดและโฮสต์ด้วยตนเอง | เฉพาะ API เข้าถึงผ่านการสมัครสมาชิก | เฉพาะ API การเข้าถึงผ่านการกำหนดราคาตามการใช้งาน | เฉพาะ API เข้าถึงได้ผ่าน Vertex AI ของ Google |

| แบบจำลอง AI | เมต้าส์ LLaMA 4/3/2 | GPT-4 ของ OpenAI | คล็อด 3 ของแอนโทรปิก | PaLM 2 ของ Google |

| ประสิทธิภาพ | ระดับสูงสุด แข่งขันกับโมเดล AI ชั้นนำได้ ต้องมีการปรับแต่งอย่างละเอียดเพื่อให้ตรงกับประสิทธิภาพของ GPT-4 ในงานเฉพาะ ขาดความสามารถในการส่งมอบเนื้อหาสร้างสรรค์คุณภาพสูงที่น่าดึงดูด | ผู้นำในอุตสาหกรรม จัดการกับการใช้เหตุผลที่ซับซ้อน ความละเอียดอ่อน และการแก้ปัญหาอย่างสร้างสรรค์ | ระดับสูงสุด ยอดเยี่ยมในการวิเคราะห์ข้อมูล การสนทนาที่ซับซ้อน และการใช้เหตุผลในบริบทยาว | ระดับสูงสุด เก่งด้านการใช้เหตุผลและงานหลายภาษา |

| โครงสร้างต้นทุน | CapEx สูง, OpEx ต่ำ ต้นทุนจะปรับขนาดตามขนาดโมเดลและปริมาณการใช้งาน | ไม่มี CapEx, OpEx สูง ต้นทุนเริ่มต้น แต่จ่ายตามการใช้งาน | ไม่มี CapEx, OpEx สูง คล้ายกับ OpenAI จ่ายตามโทเค็น | ไม่มี CapEx, OpEx สูง จ่ายต่อโทเค็นบน Vertex AI พร้อมส่วนลดตามปริมาณ |

| ความเป็นส่วนตัวและความปลอดภัยของข้อมูล | การควบคุมสูงสุด ข้อมูลจะไม่มีวันออกจากโครงสร้างพื้นฐานของคุณ เหมาะสำหรับอุตสาหกรรมที่มีการควบคุมอย่างเข้มงวด | ข้อมูลอินพุต/เอาต์พุตได้รับการประมวลผลบนเซิร์ฟเวอร์ของ OpenAI | นโยบายความเป็นส่วนตัวที่เข้มงวด แต่ข้อมูลได้รับการประมวลผลโดย Anthropic | ความปลอดภัยระดับองค์กร ข้อมูลที่ประมวลผลบน Google Cloud นำเสนอการควบคุม VPC และความมุ่งมั่นในการจัดเก็บข้อมูล |

| การปรับแต่งและการควบคุม | การควบคุมแบบสมบูรณ์ สามารถปรับแต่งได้เต็มที่บนข้อมูลที่เป็นกรรมสิทธิ์ | ถูก จำกัด การปรับแต่งละเอียดมีเฉพาะรุ่นเก่าเท่านั้น (ไม่ใช่ GPT-4) | ถูก จำกัด ปรับแต่งผ่านวิศวกรรมและบริบทที่รวดเร็ว | แข็งแกร่ง การสนับสนุนที่ดีสำหรับการปรับแต่งและการเรียนรู้การเสริมแรง |

| ความสามารถในการปรับขนาด | คุณต้องจัดเตรียมและจัดการโครงสร้างพื้นฐานของคุณเอง | OpenAI จัดการโครงสร้างพื้นฐานทั้งหมด | Anthropic จัดการโครงสร้างพื้นฐานทั้งหมด | Google Cloud จัดการโครงสร้างพื้นฐาน |

โดยทั่วไปแล้ว Llama เหมาะอย่างยิ่งสำหรับบริษัทที่ต้องการการควบคุมที่สมบูรณ์แบบ ความเป็นส่วนตัวของข้อมูล และความสามารถในการปรับแต่ง GPT-4 เหมาะที่สุดสำหรับองค์กรที่ต้องการประสิทธิภาพและความสามารถในการใช้เหตุผลขั้นสูง สามารถจัดการงานที่ซับซ้อนได้ดีขึ้น โดยเฉพาะอย่างยิ่งการวิเคราะห์เชิงสร้างสรรค์และขั้นสูง Claude 3 เหมาะอย่างยิ่งสำหรับการใช้งานที่ให้ความสำคัญกับความปลอดภัยและการลดอคติ แทบไม่ก่อให้เกิดผลลัพธ์ที่เป็นอันตราย PaLM 2 เหมาะที่สุดสำหรับธุรกิจที่ผสานรวมเข้ากับระบบนิเวศ Google Cloud อย่างลึกซึ้ง ช่วยให้มั่นใจได้ว่าสามารถผสานรวมกับเครื่องมืออื่นๆ ของ Google ได้อย่างราบรื่น

ก่อนใช้งาน Llama คุณควรพิจารณาความต้องการของคุณให้สอดคล้องกับกรณีการใช้งานจริงก่อน ไม่ว่าคุณจะต้องการโมเดลพารามิเตอร์ 70B เพื่อคุณภาพสูงสุด หรือต้องการแค่โมเดล 8B สำหรับงานพื้นฐาน

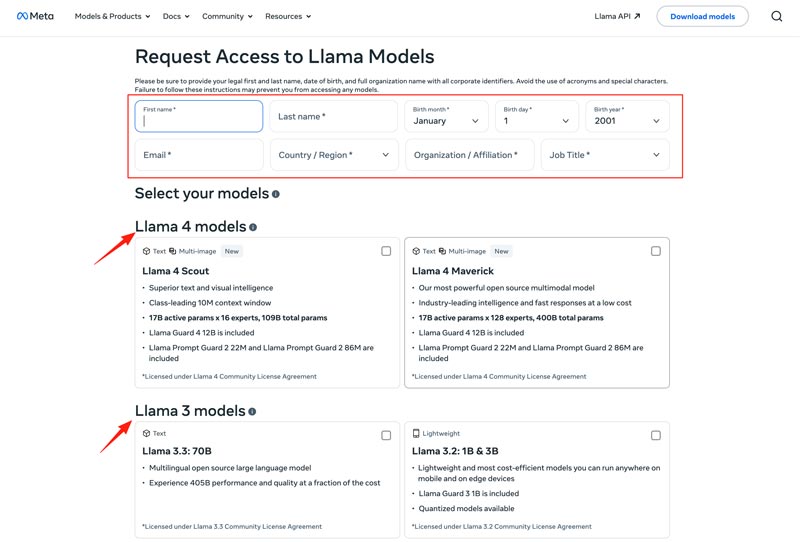

คุณควรเลือกวิธีการปรับใช้ของคุณ เช่น เครื่องภายใน, VM บนคลาวด์ หรือบริการที่มีการจัดการ การรันโมเดล Llama อย่างมีประสิทธิภาพมักต้องใช้ GPU ที่ทรงพลัง โดยเฉพาะอย่างยิ่งสำหรับโมเดลขนาดใหญ่ หลังจากนั้น คุณสามารถดาวน์โหลดโมเดลที่ถูกต้องได้จากเว็บไซต์ Meta

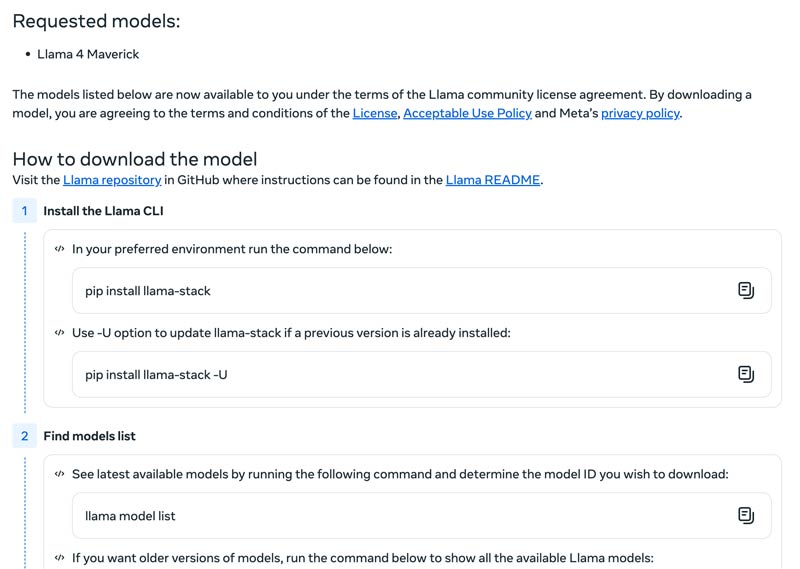

คลิกปุ่ม Download Models เพื่อเข้าสู่หน้า Request Access กรอกข้อมูลที่จำเป็นและเลือกโมเดล Llama ที่ต้องการ.

คลิกปุ่ม Next เพื่ออ่าน Terms and Conditions คุณควรตรวจสอบข้อตกลงการอนุญาตใช้งานชุมชน (Community License Agreement) อย่างละเอียด จากนั้นคลิกปุ่ม Accept and Continue แล้วทำตามคำแนะนำบนหน้าจอเพื่อดาวน์โหลดโมเดลที่เลือก.

คุณสามารถใช้เฟรมเวิร์กอย่าง Text Generation Inference เพื่อให้ได้เซิร์ฟเวอร์ API ประสิทธิภาพสูง หากต้องการอินเทอร์เฟซสำหรับแชต ให้ดีพลอย UI อย่าง Chatbot UI หรือ NextChat หลังจากนั้น ใช้ข้อมูลเฉพาะของคุณร่วมกับเฟรมเวิร์กเหล่านี้เพื่อสร้างโมเดลเฉพาะทางของคุณเอง.

คุณควรทราบวิธีการเอาชนะความท้าทายเพื่อใช้โมเดล AI ได้อย่างมีประสิทธิภาพ

• ความซับซ้อนของการตั้งค่าเริ่มต้น

คุณสามารถใช้เครื่องมือและคอนเทนเนอร์ที่สร้างไว้ล่วงหน้าได้ รันโมเดลในเครื่องได้ด้วยคำสั่งเดียว คุณยังสามารถเปลี่ยนไปใช้แพลตฟอร์มบนคลาวด์ได้โดยไม่ต้องตั้งค่าใดๆ Hugging Face ช่วยให้คุณรันและสร้างเดโมโดยใช้สภาพแวดล้อมที่กำหนดค่าไว้ล่วงหน้า นอกจากนี้ คุณยังสามารถเริ่มต้นด้วย llama.cpp เพื่อรัน Llama เวอร์ชันควอนไทซ์ได้

• การจัดการทรัพยากรและการเพิ่มประสิทธิภาพด้านต้นทุน

โมเดลขนาดใหญ่ต้องใช้ GPU ที่มีหน่วยความจำสูง ซึ่งมักจะหายากและมีราคาแพง

การหาปริมาณเป็นเทคนิคที่มีประสิทธิภาพสูงสุด คุณสามารถใช้ไลบรารีสำหรับการหาปริมาณ 4 บิตในระหว่างการอนุมานหรือการปรับแต่งละเอียด สำหรับฮาร์ดแวร์ที่มีประสิทธิภาพน้อยกว่า ให้ใช้ llama.cpp เพื่อรันโมเดล ทั้งสองวิธีนี้สามารถลดการใช้หน่วยความจำได้อย่างมีประสิทธิภาพ นอกจากนี้ ตรวจสอบให้แน่ใจว่าคุณเลือกโมเดลที่ถูกต้องสำหรับงานของคุณ โมเดลขนาดเล็กที่ปรับแต่งละเอียดแล้วอาจคุ้มค่ากว่า

• การติดตามเวอร์ชันใหม่ให้ทันสมัยอยู่เสมอ

มีการเปิดตัวโมเดล เทคนิค และไลบรารีใหม่ๆ มากมายทุกสัปดาห์ การติดตามให้ทันสมัยอยู่เสมออาจเป็นเรื่องยาก

คุณควรสมัครรับข้อมูลบล็อกอย่างเป็นทางการ เช่น Meta AI, Hugging Face และ vLLM ยิ่งไปกว่านั้น ยังมีการแบ่งปันเทคนิคการปรับแต่ง แอปพลิเคชัน การเพิ่มประสิทธิภาพ ประสบการณ์ โซลูชัน และอื่นๆ อีกมากมายบนแพลตฟอร์มอย่าง GitHub และ Hugging Face ซึ่งช่วยให้ทีมของคุณผสานรวมการปรับปรุงต่างๆ เข้าด้วยกันได้

คุณอาจต้องการทราบเพิ่มเติม:

คำถามที่ 1: อนุญาตให้ใช้ผลลัพธ์ที่ได้จากโมเดล Llama ไปฝึกโมเดล LLM อื่นหรือไม่

ใช่ Meta อนุญาตให้ใช้ผลลัพธ์ของ Llama เวอร์ชันใหม่กว่า (Llama 3.1 ขึ้นไป) เพื่อฝึกอบรมโมเดลอื่นๆ แน่นอนว่าคุณไม่ได้รับอนุญาตให้ใช้ผลลัพธ์นี้เพื่อสร้างผลิตภัณฑ์ที่แข่งขันกับ Meta นอกจากนี้ คุณต้องตระหนักถึงขอบเขตทางกฎหมายที่กำหนดไว้ในใบอนุญาตของ Meta อย่างเคร่งครัด

คำถามที่ 2: โมเดล Llama มีข้อจำกัดอะไรบ้าง และมีเงื่อนไขที่เกี่ยวข้องอย่างไร

ใช่ โมเดล Llama มีข้อจำกัดสำคัญ ซึ่งกำหนดโดยโครงสร้างการอนุญาตสิทธิ์ โมเดลเหล่านี้ไม่ใช่โอเพนซอร์สอย่างแท้จริง แต่เผยแพร่ภายใต้ใบอนุญาตที่เป็นกรรมสิทธิ์ของ Meta เพื่อปกป้องผลประโยชน์ของ Meta และป้องกันกรณีการใช้งานที่เป็นการแข่งขัน

คำถามที่ 3: กรณีการใช้งานทั่วไปของ Llama มีอะไรบ้าง

กรณีการใช้งาน Llama ในชีวิตประจำวันประกอบด้วยการทำความเข้าใจภาพและเอกสาร การตอบคำถาม การสร้างภาพและข้อความ การสร้างและสรุปภาษา การฝึกภาษา ปัญญาประดิษฐ์สำหรับการสนทนา และอื่นๆ อีกมากมาย Llama สามารถตอบคำถามของคุณโดยอิงจากเนื้อหาภาพหรือเอกสารที่คุณให้มา นอกจากนี้ ยังสามารถใช้สร้างแชทบอทหรือผู้ช่วยด้านภาพได้อีกด้วย

คำถามที่ 4: ฮาร์ดแวร์ขั้นต่ำที่ต้องใช้ในการรันโมเดล Llama คืออะไร

ข้อกำหนดด้านฮาร์ดแวร์สำหรับการรันโมเดล Llama นั้นพิจารณาจากปัจจัยหลักสามประการ ได้แก่ ขนาดของโมเดล การวัดปริมาณ และกรณีการใช้งาน สำหรับนักพัฒนาส่วนใหญ่ RTX 4070/4080/4090 หรือ Mac ที่มีหน่วยความจำแบบ Unified ขนาด 16-36GB ถือเป็นตัวเลือกที่ยืดหยุ่นสำหรับโมเดล Llama ที่มีความจุสูงสุดถึง 70GB สำหรับการใช้งานบน GPU ปัจจัยที่สำคัญที่สุดคือ VRAM ของการ์ดจอของคุณ ดังที่ได้กล่าวไปแล้ว ให้เลือกขนาดของโมเดลที่ถูกต้องตามความต้องการของคุณ จากนั้นเลือกระดับการวัดปริมาณที่สามารถรันบนฮาร์ดแวร์ของคุณได้

คำถามที่ 5: Llama ดีเทียบเท่า ChatGPT หรือไม่

คุณสามารถดูตารางด้านบนเพื่อเปรียบเทียบปัจจัยสำคัญระหว่าง Llama และ ChatGPT ได้ Llama สามารถรันแบบโลคัลและออฟไลน์ ทำให้มีการปกป้องข้อมูลที่ปลอดภัยยิ่งขึ้น นอกจากนี้ ตัวโมเดล Llama เองยังให้ใช้งานได้ฟรี ขณะที่ ChatGPT มีเวอร์ชันฟรี แต่โมเดลและฟีเจอร์ขั้นสูงจำเป็นต้องสมัครแพ็กเกจแบบชำระเงิน.

บทสรุป

Llama ไม่ได้เป็นแค่โมเดลอีกตัวหนึ่ง แต่มักถูกมองว่าเป็นการเปลี่ยนทิศทางเชิงกลยุทธ์ไปสู่อนาคตของ AI ที่เข้าถึงง่ายและปรับแต่งได้มากขึ้น คุณสามารถเรียนรู้ข้อมูลต่าง ๆ เกี่ยวกับตระกูล Llama AI ได้จากรีวิวที่ตรงไปตรงมานี้ แล้วค่อยตัดสินใจว่ามันคู่ควรกับกระแสที่ได้รับหรือไม่.

คุณพบว่าสิ่งนี้มีประโยชน์หรือไม่?

484 โหวต