Spotlight: AI-chatt , spel som Retro , platsbyte , Roblox avblockerad

Spotlight: AI-chatt , spel som Retro , platsbyte , Roblox avblockerad

Trött på oändliga AI-bildverktyg?

Stable Diffusion positionerar sig som en “frihetslösning” för AI-bildgenerering. När du söker efter en kraftfull text-till-bild‑modell som kan generera högkvalitativa bilder baserat på dina textbeskrivningar kan du stöta på den eller få relaterade rekommendationer.

Men i ett snabbt växande område med liknande modeller och konkurrenter som Midjourney, Seedance och Veo 3 kanske du undrar: Är Stable Diffusion värd din tid, eller levererar Stable Diffusion verkligen resultat av professionell kvalitet?

Denna recension av Stable Diffusion ger all nödvändig information om denna AI‑bildgenereringsmodell och besvarar just den frågan.

Innehållsförteckning

Stable Diffusion är en flexibel djupinlärningsbaserad text‑till‑bild‑modell utvecklad av Stability AI. Den bygger på diffusionsteknik (släppt 2022) som kan omvandla textbeskrivningar till visuella representationer. Modellen använder en CLIP ViT‑L/14‑textencoder för att generera högkvalitativa bilder som svar på prompts.

Jämfört med tidigare diffusionsmodeller minskar den senaste Stable Diffusion 3.5 minneskraven avsevärt. Den är utformad med en stor arkitektonisk innovation genom att implementera diffusionsprocessen i ett latent utrymme. Tidigare modeller arbetar direkt i bildutrymmet.

Tack vare det tekniska genombrottet och dess öppen källkod har Stable Diffusion snart lockat en mycket bredare användarbas, inklusive utvecklare, forskare, individuella skapare och företagsanvändare.

• Ständiga förbättringar med versionsuppdateringar. Sedan den första lanseringen har denna text‑till‑bild‑genereringsmodell genomgått en betydande utveckling. Huvudversionerna omfattar Stable Diffusion 1.5, 2.0, 2.1, 3.0 och den senaste 3.5‑serien. De har gjort stora förbättringar inom olika områden, inklusive utdata‑kvalitet, förståelse av prompts och genereringsförmåga, med mera.

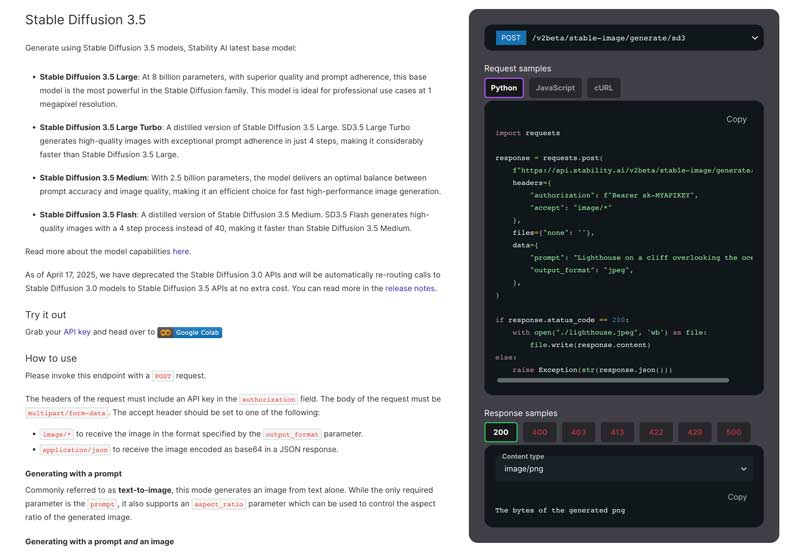

• Flera modellversioner. Flera specialiserade modeller är utformade för att tillgodose olika användarbehov. Den senaste basmodellen är Stable Diffusion 3.5. Den erbjuder avsevärda förbättringar jämfört med tidigare versioner. För närvarande finns det fyra huvudversioner i Stable Diffusion‑familjen: Stable Diffusion 3.5 Large, Large Turbo, Medium och Flash.

• Avancerad förståelse av prompts. Den nuvarande Stable Diffusion 3.5 har en sofistikerad arkitektur med flera textencoders som gör att den mer effektivt kan bearbeta mer komplexa och detaljerade prompts. Den kan hantera textbeskrivningar på upp till 10 000 tecken. Detta gör det möjligt för användare att ge mer detaljerade beskrivningar. Samtidigt kan Stable Diffusion producera resultat av högre kvalitet och större precision.

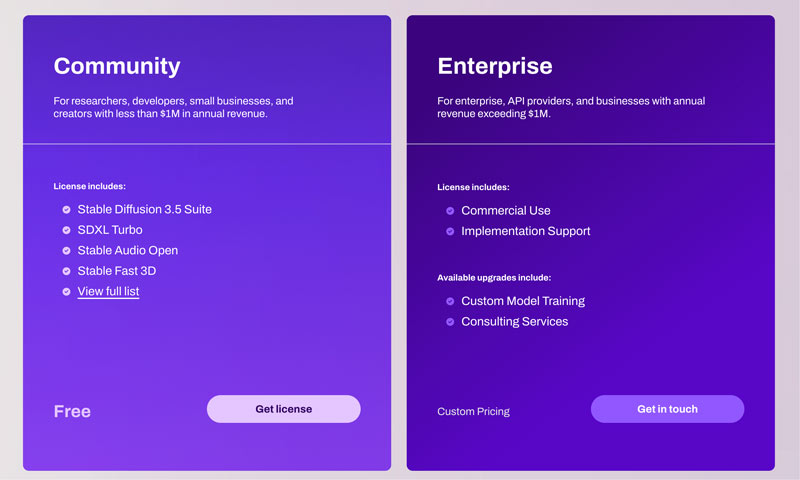

• Kommersiell och kreativ flexibilitet. Stable Diffusion 3.5‑modellerna släpps under Stability AI Community License och Enterprise License. Det tillåter både kommersiell och icke‑kommersiell användning. För de flesta vanliga användare, såsom forskare, utvecklare och småföretag med en årlig omsättning på mindre än $1M, kan de använda Stable Diffusion fritt utan begränsningar. Användare kan fritt anpassa AI:n efter sina specifika behov och konstnärliga stilar.

Som nämnts ovan gör Stable Diffusions mångsidighet den lämplig för nästan alla användare. Både utvecklare, forskare, designers, digitala konstnärer, AI-hobbyister och även studenter kan få betydande fördelar av dess funktioner.

Den senaste Stable Diffusion 3.5-modellen har avancerade funktioner för att generera finare bilddetaljer. Genererade foton har ofta korrekt belysning och motiv. Dessutom kan den bättre passa den specifika konststilen baserat på dina uppmaningar.

För de flesta bildgenereringsmodeller kan områden som mänskliga händer och ansiktsdrag vara särskilt utmanande. Med hjälp av en 16-kanalig VAE kan dessa vanliga artefakter och defekter effektivt åtgärdas. Stabil diffusion är bra på att återge exakta ljuseffekter.

Trots dessa förbättringar har Stable Diffusion fortfarande sina svagheter. Modellen fortsätter att möta vissa utmaningar, särskilt vid helkroppsrenderingar. Liksom andra AI-bildgenereringsmodeller producerar Stable Diffusion ofta oväntade resultat, särskilt när man genererar kompletta mänskliga figurer. Den nuvarande Stable Diffusion 3.5 fungerar bra med närbilder, porträtt och olika icke-mänskliga motiv.

Effektiviteten hos Stable Diffusion varierar beroende på vilken specifik modellversion som används, hårdvara, utdatainställningar och prompter. Generellt sett kan du med en kraftfull NVIDIA GPU enkelt generera en standardbild på 1024x1024 på 5–15 sekunder. Stable Diffusion är bättre än många alternativ och låter användare träna och finjustera modeller på sina egna datamängder. Detta är särskilt värdefullt för professionella användare.

Jämfört med tidigare modeller är den nuvarande Stable Diffusion 3.5 mycket enklare att använda. Men "enkel"-graden beror starkt på dina tekniska färdigheter, erfarenhetsnivå och valda gränssnitt.

Flera tillvägagångssätt finns tillgängliga för olika tekniska komfortnivåer. Gå till den officiella webbplatsen för Stability AI, skaffa en licens och skicka sedan en POST-förfrågan enligt anvisningarna.

Relativt sett har installationsprocessen för Stable Diffusion förenklats dramatiskt tack vare olika integrerade lösningar. Dessutom har Stable Diffusion ett webbgränssnitt med en omfattande instrumentpanel för bättre kontroll av genereringsprocessen. För en effektiv lokal distribution rekommenderas det också att verifiera de föreslagna hårdvarukraven. För nybörjare rekommenderar vi att använda Stable Diffusion på Windows 10 eller 11.

De flesta aktiva communities och plattformar, som Reddit, Discord och forum, samlar relaterade tekniker, skapelser och problemlösningslösningar om Stable Diffusion. Detta communitydrivna supportekosystem kan snabbt dela nya modeller, funktioner, praktiska lösningar och andra värdefulla resurser.

| Funktion/Modell | Stabil diffusion | Midjourney | Fröbildning | VEO 3 |

| Prissättning | Gratis modell med öppen källkod (Community License). Kostnader för hårdvara och moln | Prenumeration: Cirka $10 – $$1 152/månad | API: $0.09 – $1.50 per video | API: Gemini Developer API-prissättning |

| Hårdvarukrav | Hög (kräver en kraftfull GPU) | Låg (körs på Discord, ingen lokal hårdvara behövs) | Molnbaserat (ingen användarhårdvara krävs) | Molnbaserat (ingen användarhårdvara krävs) |

| Anpassning | Omfattande (öppen källkod, stöder ControlNet, LoRA och anpassad modellträning) | Begränsad (genom uppmaningar och grundläggande parametrar) | Omfattande (genom uppmaningar och kreativa kontroller) | Begränsad (främst i uppmaningar) |

| Bild-/videokvalitet | Hög övre gräns, beror på modeller och inställning | Hög standardkvalitet, stark konstnärlig stil | HD-videor i 1080p | 8 sekunder långa videor i 720p till 1080p |

| Textförståelse | Bra, bli utbildad och förbättrad med anpassade modeller | Excellent | Utmärkt, förstår komplexa instruktioner | Utmärkt, förstår komplexa berättelser |

| Enkel användning | Brantare inlärningskurva | Lätt | API-baserad, kräver integration | Enkelt, kräver integration |

Stable Diffusion är ett bra val för specifika användargrupper, främst de med tekniska färdigheter och anpassningskrav. Det erbjuder funktioner som motiverar dess brantare inlärningskurva och hårdvarukrav. Men för nybörjare erbjuder många konkurrenter en mycket enklare installations- och användarupplevelse. Om du har kompatibel hårdvara och tillräcklig motivation att lära dig är Stable Diffusion ett flexibelt och kreativt verktyg för AI-bildgenerering.

Fråga 1. Hur mycket kostar Stable Diffusion?

Stability AI erbjuder en Community License för utvecklare, forskare, småföretag och kreatörer för att använda Core Models (inklusive Stable Diffusion 3) gratis, såvida inte ditt företag har en årlig omsättning på över $1M USD eller du använder Stable Diffusion‑modellerna i kommersiellt syfte. I allmänhet är Core Models och Derivative Works gratis för dig att använda. Du fyller i den begärda informationen och skickar sedan in en förfrågan om den kostnadsfria Community License. Läs den här artikeln för att få fler gratis AI‑bildgeneratorer!

Fråga 2. Finns det hårdvarukrav för Stable Diffusion?

När du vill köra Stable Diffusion på din dator beror användarupplevelsen starkt på hårdvaran, särskilt GPU, RAM och CPU. Du bör ha ett NVIDIA-grafikkort. NVIDIAs CUDA-teknik är utformad med avancerad accelerationsteknik. Det kan vara det mest kompatibla alternativet för att köra Stable Diffusion. AMD-grafikkort rekommenderas ofta inte på grund av bristande optimering.

Fråga 3. Är Stable Diffusion lämpligt för nybörjare?

Att komma igång med Stable Diffusion har blivit mycket enklare tack vare installationspaket med ett klick och molntjänster. Men för nybörjare innebär processen fortfarande en inlärningskurva, än mindre att bemästra dess fulla potential. Oavsett om du väljer den lokala installationen eller dess molntjänst kan du interagera med den via ett webbgränssnitt efter att ha kört Stable Diffusion. Webbgränssnittet har ett visuellt gränssnitt för text-till-bild- och bild-till-bild-funktioner. Du kan använda dem för att generera och modifiera bilder. Dessutom kommer du ofta att behöva ge detaljerade textbeskrivningar för att producera önskade bilder. Den slutliga kvaliteten på din genererade bild beror i hög grad på de instruktioner du ger.

Fråga 4. Vilka typer av bilder kan Stable Diffusion skapa?

Stable Diffusion kan generera bilder i en mycket stor mängd olika typer. De flesta konststilar stöds, inklusive realistiska bilder, anime, oljemålning, akvarell och andra. Resultaten bestäms i första hand av den specifika AI‑modell som används och de prompts som ges.

Först måste du välja en Checkpoint‑modell. Modellen avgör den grundläggande stilen på den genererade bilden, till exempel om den blir realistisk eller tecknad. Du kan söka efter och ladda ner relaterade modeller från community‑plattformar som Hugging Face. Förfina den sedan med mindre modeller.

Fråga 5. Kan jag använda Stable Diffusion i kommersiellt syfte?

Ja, du kan använda Stable Diffusion för kommersiella ändamål. Kontrollera dock de specifika villkoren för den Stable Diffusion-version du använder på den officiella webbplatsen. Reglerna kan ha ändrats mellan olika modellversioner. Dessutom bör du se till att din planerade kommersiella användning inte bryter mot licensens förbjudna aktiviteter. Var dessutom medveten om den potentiella bristen på upphovsrättsskydd för de bilder du genererar.

Slutsats

Denna recension av Stable Diffusion ger dig en detaljerad introduktion till Stability AI:s text‑till‑bild‑genereringsmodell, särskilt den senaste modellen Stable Diffusion 3.5. Du bör genom recensionen få en tydlig bild av dess kapacitet, prestanda, styrkor och svagheter. När du läst klart detta inlägg bör du veta exakt vad Stable Diffusion kan göra för dig och om det är värt din tid.

Tyckte du att det här var användbart?

477 röster

Aiseesoft AI Photo Editor är ett avancerat skrivbordsprogram utformat för att förbättra, skala upp och klippa ut bilder.